Hai bisogno di una versione PDF dell’articolo per una lettura più comoda o per conservarne una copia? Clicca sul link sottostante per scaricare il PDF direttamente sul tuo dispositivo.

Scarica l’articolo in PDF (ITA)Do you need a PDF version of the article for easier reading or to keep a copy? Click the link below to download the PDF directly to your device.

Download Article as PDF (ENG)Dall’Obbedienza all’Iniziativa: Il Grande Salto Evolutivo

Fino a ieri, i nostri fidati assistenti AI erano come quei camerieri educati che aspettano pazientemente di prendere l’ordinazione. Oggi, con l’avvento dei modelli o3 e o4-mini di OpenAI, abbiamo promosso questi camerieri a chef creativi, capaci non solo di prendere l’ordine, ma di decidere quali ingredienti usare, come prepararli e persino di suggerire abbinamenti che non avremmo mai considerato.

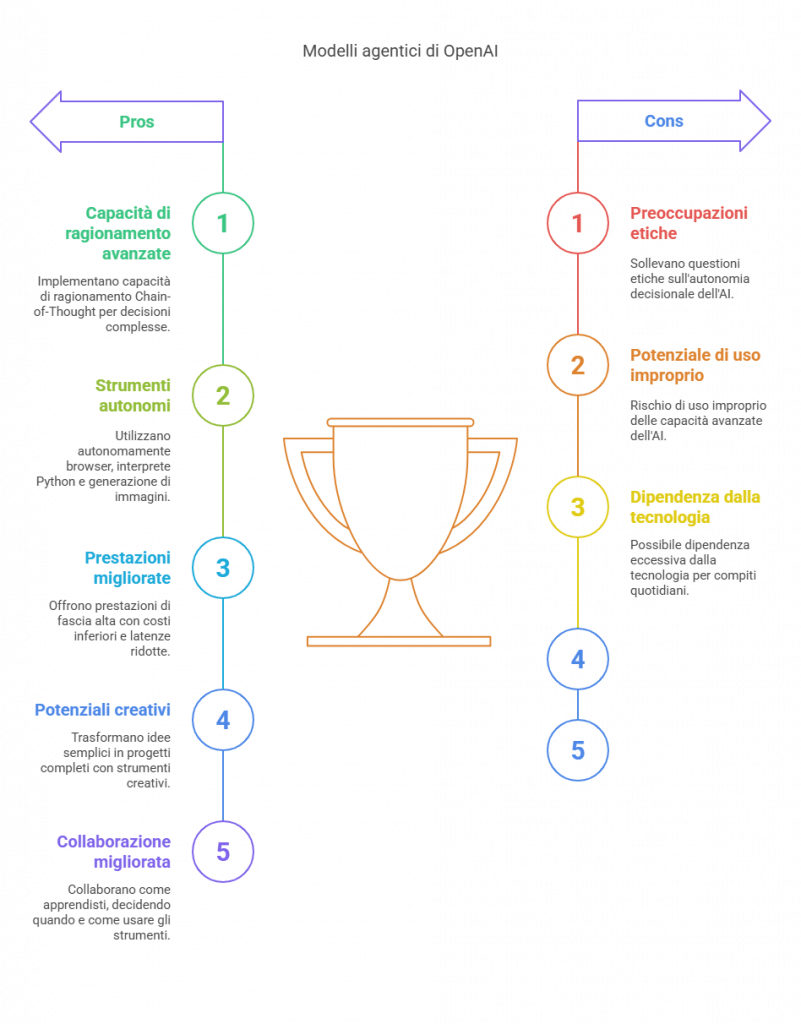

I modelli della serie “o” rappresentano una linea progettata specificamente per “pensare più a lungo prima di rispondere”, implementando capacità di ragionamento Chain-of-Thought (CoT)1. Attenzione però a non confonderli con GPT-4o: mentre in quest’ultimo la “o” sta per “omnimodale” (integrazione di input testuali, vocali e visivi), nei modelli come o3 e o4-mini la “o” indica “optimizer-based reasoning”, ovvero modelli ottimizzati per il ragionamento complesso1.

La vera rivoluzione sta nella loro capacità di utilizzare autonomamente tutti gli strumenti disponibili – browser, interprete Python, analisi file e persino generazione di immagini – scegliendo di propria iniziativa quale sia lo strumento più adatto alla situazione1. È come avere un assistente che non solo sa rispondere alle domande, ma che sa anche quando è il caso di prendere in mano una calcolatrice, consultare un’enciclopedia o disegnare uno schizzo per spiegarsi meglio.

Dalla Conversazione all’Agenzia: Un Cambio di Paradigma

Il 2023 ci ha fatto sognare con demo come GPT automatico e BabyAGI, facendoci intravedere il potenziale degli LLM che operano in loop, scegliendo azioni, osservandone i risultati e procedendo passo dopo passo (il cosiddetto framework ReACT)2. Ma quei primi esperimenti erano come prototipi grezzi di automobile: promettenti ma inaffidabili.

I nuovi modelli o3 e o4-mini rappresentano invece automobili di serie, pronte per la strada. OpenAI ha definito o3 come “il nostro sistema di ragionamento più avanzato”, mentre o4-mini promette prestazioni di fascia alta con costi inferiori e latenze ridotte1. È come essere passati dalle prime auto traballanti di inizio ‘900 alle Tesla moderne in un solo balzo evolutivo.

Scenari Quotidiani: Quando l’AI Diventa il Tuo Copilota di Vita

Il Progettista Improvvisato

Immaginiamo Marco, architetto alle prese con un progetto complesso. Invece di limitarsi a chiedere: “Come posso progettare una casa ecosostenibile?”, con o3 potrebbe dire: “Ho bisogno di progettare una villa su questo terreno collinare, considerando l’esposizione solare e i materiali locali.”

L’AI non si limiterebbe a offrire suggerimenti generici, ma prenderebbe l’iniziativa di:

- Analizzare immagini del terreno caricate da Marco

- Creare un modello 3D preliminare con un frammento di codice Python

- Generare diverse visualizzazioni dell’edificio da angolazioni diverse

- Ricercare normative locali e materiali disponibili nella zona

- Calcolare l’efficienza energetica della struttura proposta

Tutto questo senza che Marco debba specificare ogni singolo passaggio. È come avere un assistente che non aspetta istruzioni dettagliate, ma che anticipa le necessità e prende iniziative appropriate.

La Food Blogger e il Post Perfetto

Sofia gestisce un blog di cucina e sta preparando un post sulle melanzane alla parmigiana. Con o4-mini, potrebbe semplicemente dire: “Sto preparando un post sulla parmigiana di melanzane, aiutami a renderlo completo.”

L’AI agentica potrebbe:

- Generare immagini appetitose del piatto finito

- Scrivere la ricetta in formato strutturato

- Creare un breve script Python per calcolare automaticamente le proporzioni degli ingredienti in base al numero di persone

- Analizzare le tendenze di ricerca sull’argomento per suggerire keywords SEO

- Proporre varianti della ricetta per diverse esigenze alimentari

Sofia otterrebbe un pacchetto completo senza dover specificare ogni dettaglio o passare da uno strumento all’altro.

Lo Studente e la Tesina Interdisciplinare

Luca, studente universitario, deve preparare una tesina che collega matematica, storia e arte. Con i modelli agentici, potrebbe semplicemente esporre il suo obiettivo: “Devo creare una presentazione sul rapporto tra la sezione aurea, l’arte rinascimentale e la sua influenza sull’architettura moderna.”

L’AI potrebbe:

- Generare visualizzazioni matematiche della sezione aurea

- Analizzare quadri rinascimentali per evidenziarne le proporzioni

- Creare codice Python per calcolare e visualizzare queste proporzioni

- Produrre una timeline interattiva che mostra l’evoluzione di questo concetto

- Suggerire una struttura logica per la presentazione

L’intero processo verrebbe gestito autonomamente dall’AI, che ragionerebbe su quali strumenti usare e in quale ordine, un po’ come un tutor esperto che guida lo studente attraverso un progetto complesso.

La Differenza Sta nel Pensiero

Ciò che distingue i nuovi modelli agentici dai loro predecessori è proprio la capacità di “ragionare” sulle immagini, sui testi e sui problemi presentati1. Non si tratta solo di rispondere a domande, ma di analizzare, pianificare e decidere.

Mentre i primi tentativi di AI agentica soffrivano di gravi limitazioni – perdendo il filo, fermandosi troppo presto, producendo risultati imprevedibili2 – questi nuovi modelli affrontano proprio questi problemi. Come evidenziato nelle fonti, molti costruttori di agenti hanno abbandonato il promettente ma instabile framework ReACT per metodi più affidabili.

Un Cervello Esterno che Pensa con Te

Potremmo paragonare questi nuovi modelli a un “cervello esterno” che collabora con il nostro, capace di fungere da memoria estesa che va oltre i limiti della finestra di contesto3. Quando un LLM tradizionale raggiunge il limite della sua capacità di elaborazione (come i 4k token di ChatGPT 3.5), si trova in difficoltà3. I modelli agentici, invece, possono cercare autonomamente le informazioni più rilevanti, suddividere problemi complessi e gestire contesti molto più ampi.

Esempi Creativi: Quando l’AI Diventa Co-creatore

Immaginiamo Jessica, content creator, che deve realizzare un video senza nemmeno toccare una videocamera. Con i nuovi modelli agentici, Jessica potrebbe partire da un’idea semplice e trasformarla in un progetto completo4.

L’AI potrebbe:

- Elaborare uno script narrativo

- Generare immagini che rappresentano le scene chiave

- Trasformare queste immagini in video con strumenti come Luma

- Suggerire effetti sonori e musica di sottofondo

- Ottimizzare il tutto per diverse piattaforme social

Jessica potrebbe iniziare con un semplice: “Voglio creare un video sulla Regina degli Scoiattoli Digitali” e vedere come l’AI espande questa idea in un progetto completo, proprio come mostrato nel video di Jessica sui tool AI creativi4.

Lo Scrittore Bloccato

Marco è uno scrittore con un blocco creativo. Invece di chiedere genericamente idee per una storia, con i modelli agentici potrebbe dire: “Ho un personaggio, un detective tecnofobico, che deve risolvere un crimine in una città dove tutto è gestito dall’IA.”

L’AI potrebbe:

- Proporre una struttura narrativa completa

- Generare immagini dei personaggi principali

- Creare una mappa interattiva della città immaginaria

- Scrivere dialoghi campione con voci distintive

- Suggerire colpi di scena basati su analisi di trame di successo simili

Tutto questo navigando autonomamente tra diversi strumenti creativi e prendendo decisioni su quali utilizzare per supportare al meglio il processo creativo dello scrittore.

Le Implicazioni: Oltre la Convenienza

Questo passaggio epocale da modelli conversazionali a modelli agentici va ben oltre la semplice convenienza. Stiamo assistendo a una trasformazione fondamentale nel modo in cui interagiamo con l’intelligenza artificiale.

I sistemi agentici possiedono un livello di “agency”, ovvero la capacità di agire in modo indipendente in base a obiettivi, istruzioni o feedback, senza una guida umana costante5. A differenza dei sistemi di IA convenzionali limitati a compiti fissi, l’IA agentica è dinamica, impara dalle interazioni e migliora il suo comportamento nel tempo5.

Da Strumento a Collaboratore

La differenza principale è che non stiamo più utilizzando l’AI come uno strumento, ma stiamo iniziando a collaborare con essa. È come passare dall’avere un martello all’avere un apprendista che sa quando e come usare quel martello (e tutti gli altri attrezzi nella cassetta).

Conclusione: L’Inizio di una Nuova Era

I modelli o3 e o4-mini di OpenAI rappresentano molto più di un semplice aggiornamento: sono l’incarnazione di un salto evolutivo nell’intelligenza artificiale. Il passaggio da sistemi puramente conversazionali a sistemi agentici segna l’inizio di una nuova fase nella nostra relazione con le macchine.

Come tutte le grandi rivoluzioni tecnologiche, questa trasformazione promette di rendere più semplici alcuni aspetti della nostra vita, ma anche di sfidare il nostro modo di pensare e lavorare. La vera domanda non è più “cosa può fare l’AI?”, ma “come possiamo lavorare insieme all’AI per fare cose che nessuno dei due potrebbe fare da solo?”.

In un futuro molto prossimo, potremmo guardare indietro all’era dei semplici chatbot come guardiamo oggi ai primi telefoni cellulari: con un misto di nostalgia e incredulità per quanto fossero limitati rispetto a ciò che è venuto dopo. Nel frattempo, preparatevi a ridefinire le vostre aspettative su ciò che significa collaborare con l’intelligenza artificiale: non è più solo una questione di dare comandi, ma di stabilire obiettivi e lasciare che l’AI ragioni sul modo migliore per raggiungerli.

Citations:

- https://www.dday.it/redazione/52715/openai-lancia-o3-e-o4-mini-modelli-potentissimi-con-capacita-di-ragionamento-e-analisi-delle-immagini

- https://unite.ai/it/they-promised-us-agents-but-all-we-got-were-static-chains/

- https://www.commitsoftware.it/abbiamo-veramente-bisogno-di-un-database-vettoriale-specializzato/

- https://www.youtube.com/watch?v=YdSDKkvOatw

- https://www.unite.ai/it/agentic-ai-how-large-language-models-are-shaping-the-future-of-autonomous-agents/

- https://gomoot.com/openai-o3-e-o4-mini-pensiero-visivo-e-tool-agentici-potenziati-in-chatgpt/

- https://www.macitynet.it/openai-ha-presentato-i-modelli-o3-e-o4-mini/

- https://www.html.it/magazine/openai-presenta-i-modelli-ai-o3-e-o4-mini-con-avanzate-capacita-di-reasoning/

- https://www.hwupgrade.it/news/web/openai-lancia-o3-e-o4-mini-i-nuovi-modelli-ora-pensano-con-le-immagini_137843.html

- https://www.techbelve.it/modelli-ai-agentici-openai-gpt-4-mini-e-o3-ragionano/

- https://www.reddit.com/r/MachineLearning/comments/19ek3jk/r_from_llm_to_conversational_agent_a_memory/?tl=it

- https://www.diariodiunanalista.it/posts/chatbot-python-langchain-rag/

- https://www.youtube.com/watch?v=nFeRrma8aV0

- https://clickup.com/it/blog/263476/agenti-llmi

- https://www.albavista.it/openai-presenta-o3-e-o4-mini-modelli-con-ragionamento-avanzato-da-testo-e-immagini/

- https://www.reddit.com/r/LangChain/comments/1grcjpa/prove_me_wrong_an_agent_is_just_a_convenient/?tl=it

- https://www.programmareinpython.it/blog/python-e-llm-guida-introduttiva-2024/

- https://www.reddit.com/r/LocalLLaMA/comments/1c6ejb8/what_are_some_creative_uses_of_llmai_that_we_can/

- https://www.ai4business.it/intelligenza-artificiale/levoluzione-degli-agenti-ai-e-dei-sistemi-agentici/

- https://learn.microsoft.com/it-it/azure/ai-services/openai/concepts/models

FAQ: Il Colpo di Stato Digitale

Come i modelli agentici stanno riscrivendo le regole del gioco

I modelli o3 e o4-mini rappresentano una nuova generazione di intelligenza artificiale sviluppata da OpenAI, specificamente progettata per il “ragionamento basato su ottimizzazione” (optimizer-based reasoning):

- o3 è definito da OpenAI come “il nostro sistema di ragionamento più avanzato”, capace di pensare più a lungo prima di rispondere

- o4-mini offre prestazioni di fascia alta con costi inferiori e latenze ridotte

- A differenza di GPT-4o (dove “o” sta per “omnimodale”), nei modelli o3 e o4-mini la “o” indica la capacità di ragionamento complesso

- Implementano capacità di ragionamento Chain-of-Thought (CoT) che permettono di seguire passaggi logici strutturati

La caratteristica rivoluzionaria di questi modelli è la loro capacità di utilizzare autonomamente gli strumenti disponibili (browser, interprete Python, analisi file, generazione di immagini) scegliendo di propria iniziativa quale sia lo strumento più adatto alla situazione.

La differenza fondamentale tra modelli agentici e tradizionali può essere paragonata a quella tra un cameriere che aspetta ordini e uno chef che prende iniziative:

| Modelli conversazionali tradizionali | Modelli agentici |

|---|---|

| Aspettano istruzioni specifiche dall’utente | Prendono iniziative autonome per raggiungere un obiettivo |

| Rispondono solo a ciò che viene esplicitamente richiesto | Analizzano, pianificano e decidono quali strumenti utilizzare |

| Generano output in base al prompt immediato | Ragionano attraverso passaggi multipli (framework ReACT) |

| Limitati dalla finestra di contesto | Possono estendere le loro capacità cercando informazioni aggiuntive |

| Strumenti che eseguono compiti | Collaboratori che risolvono problemi |

I modelli agentici possiedono un livello di “agency”, ovvero la capacità di agire in modo indipendente in base a obiettivi, istruzioni o feedback, senza una guida umana costante. A differenza dei sistemi di IA convenzionali limitati a compiti fissi, l’IA agentica è dinamica, impara dalle interazioni e migliora il suo comportamento nel tempo.

I modelli agentici aprono possibilità in numerosi campi, trasformando l’interazione uomo-macchina. Ecco alcuni scenari concreti:

📐 Il Progettista Improvvisato

Un architetto come Marco può dire: “Ho bisogno di progettare una villa su questo terreno collinare, considerando l’esposizione solare e i materiali locali.” L’AI può autonomamente:

- Analizzare immagini del terreno

- Creare un modello 3D preliminare con codice Python

- Generare visualizzazioni dell’edificio da diverse angolazioni

- Ricercare normative locali e materiali disponibili

- Calcolare l’efficienza energetica della struttura proposta

🍽️ La Food Blogger e il Post Perfetto

Sofia, blogger di cucina, può semplicemente dire: “Sto preparando un post sulla parmigiana di melanzane, aiutami a renderlo completo.” L’AI agentica può:

- Generare immagini appetitose del piatto finito

- Scrivere la ricetta in formato strutturato

- Creare uno script Python per calcolare le proporzioni degli ingredienti

- Analizzare tendenze di ricerca per suggerire keywords SEO

- Proporre varianti della ricetta per diverse esigenze alimentari

📚 Lo Studente e la Tesina Interdisciplinare

Luca, studente universitario, può esporre: “Devo creare una presentazione sul rapporto tra la sezione aurea, l’arte rinascimentale e l’architettura moderna.” L’AI può:

- Generare visualizzazioni matematiche della sezione aurea

- Analizzare quadri rinascimentali evidenziandone le proporzioni

- Creare codice Python per calcolare e visualizzare queste proporzioni

- Produrre una timeline interattiva dell’evoluzione del concetto

- Suggerire una struttura logica per la presentazione

La caratteristica comune di tutti questi scenari è che l’utente fornisce solo l’obiettivo generale, mentre l’AI gestisce autonomamente i passaggi intermedi e la scelta degli strumenti più appropriati.

I modelli agentici possono trasformarsi in veri co-creatori, superando il ruolo di semplici strumenti di supporto:

🎬 Il Content Creator Multimediale

Jessica, content creator, potrebbe realizzare un video senza toccare una videocamera, partendo da un’idea semplice come “Voglio creare un video sulla Regina degli Scoiattoli Digitali”. L’AI agentica potrebbe:

- Elaborare uno script narrativo completo

- Generare immagini che rappresentano scene chiave

- Trasformare queste immagini in video con strumenti appropriati

- Suggerire effetti sonori e musica di sottofondo

- Ottimizzare il contenuto per diverse piattaforme social

📝 Lo Scrittore Bloccato

Marco, scrittore con un blocco creativo, potrebbe dire: “Ho un personaggio, un detective tecnofobico, che deve risolvere un crimine in una città gestita dall’IA.” L’aiutante agentico potrebbe:

- Proporre una struttura narrativa completa

- Generare immagini dei personaggi principali

- Creare una mappa interattiva della città immaginaria

- Scrivere dialoghi campione con voci distintive

- Suggerire colpi di scena basati su analisi di trame simili di successo

In questi scenari, l’IA si trasforma da semplice esecutore di comandi a partner creativo che contribuisce attivamente al processo, navigando autonomamente tra diversi strumenti e prendendo decisioni su quali utilizzare per supportare al meglio il processo creativo.

Il passaggio da modelli conversazionali a modelli agentici rappresenta un cambiamento fondamentale nella nostra relazione con l’intelligenza artificiale:

Da strumento a collaboratore

Non stiamo più usando l’AI come uno strumento, ma stiamo iniziando a collaborare con essa. È come passare dall’avere un martello all’avere un apprendista che sa quando e come usare quel martello e tutti gli altri attrezzi nella cassetta.

Cervello esterno

I modelli agentici possono fungere da “cervello esterno” che collabora con il nostro, superando i limiti della finestra di contesto e gestendo problemi complessi cercando autonomamente informazioni rilevanti.

Ridefinizione del workflow

Invece di guidare l’AI attraverso ogni passaggio, gli utenti potranno concentrarsi sugli obiettivi di alto livello, lasciando all’AI il compito di determinare i passaggi intermedi necessari.

Nuove competenze umane

Diventerà cruciale sviluppare la capacità di impostare obiettivi chiari e valutare criticamente le soluzioni proposte, piuttosto che conoscere ogni dettaglio tecnico dell’esecuzione.

La vera domanda non è più “cosa può fare l’AI?”, ma “come possiamo lavorare insieme all’AI per fare cose che nessuno dei due potrebbe fare da solo?”. In un futuro molto prossimo, potremmo guardare indietro all’era dei semplici chatbot come guardiamo oggi ai primi telefoni cellulari: con un misto di nostalgia e incredulità per quanto fossero limitati.

L’evoluzione dai primi esperimenti di IA agentica ai modelli attuali è paragonabile a quella dalle prime auto traballanti alle moderne Tesla:

2023: I primi esperimenti

Demo come GPT automatico e BabyAGI hanno mostrato il potenziale degli LLM che operano in loop, utilizzando il framework ReACT (Reasoning, Acting, and Observing). Questi primi prototipi erano promettenti ma inaffidabili.

Problemi dei primi agenti

I primi tentativi soffrivano di gravi limitazioni: perdevano il filo del ragionamento, si fermavano troppo presto, producevano risultati imprevedibili. Molti costruttori hanno abbandonato il promettente ma instabile framework ReACT per metodi più affidabili.

Modelli o3 e o4-mini: La svolta

I nuovi modelli di OpenAI rappresentano “automobili di serie, pronte per la strada” rispetto ai prototipi precedenti. Sono specificamente ottimizzati per il ragionamento, con la capacità di pensare più a lungo prima di rispondere e di utilizzare autonomamente gli strumenti più appropriati.

Il futuro: Integrazione completa

L’evoluzione porterà probabilmente a sistemi sempre più capaci di apprendere dalle interazioni, migliorare il loro comportamento nel tempo e integrare fonti di conoscenza sempre più diverse, avvicinandosi a una forma di collaborazione uomo-macchina sempre più naturale e intuitiva.

La differenza fondamentale sta nel fatto che i modelli attuali hanno superato molte delle instabilità e limitazioni dei primi prototipi, offrendo un’esperienza più affidabile, prevedibile e realmente utile in scenari pratici.

Video in Italiano

Video in Inglese

Da informatico a cercatore di senso