Hai bisogno di una versione PDF dell’articolo per una lettura più comoda o per conservarne una copia? Clicca sul link sottostante per scaricare il PDF direttamente sul tuo dispositivo.

Scarica l’articolo in PDF (ITA)Do you need a PDF version of the article for easier reading or to keep a copy? Click the link below to download the PDF directly to your device.

Download Article as PDF (ENG)Problemi dei Modelli Transformer

I modelli Transformer, sebbene potenti, presentano diversi svantaggi:

- Elevata Computabilità: I modelli Transformer richiedono una grande quantità di risorse computazionali per l’addestramento e l’inferenza, rendendoli costosi e inefficienti.

- Complessità del Fine-Tuning: Il processo di fine-tuning per adattare i modelli a nuovi compiti è complesso e spesso richiede di ricominciare da capo, rendendo difficile il riutilizzo dei modelli esistenti.

- Limitazioni del Contesto: I modelli Transformer hanno una finestra di contesto limitata, il che significa che possono gestire solo una quantità fissa di informazioni alla volta, limitando la loro capacità di comprendere contesti più ampi.

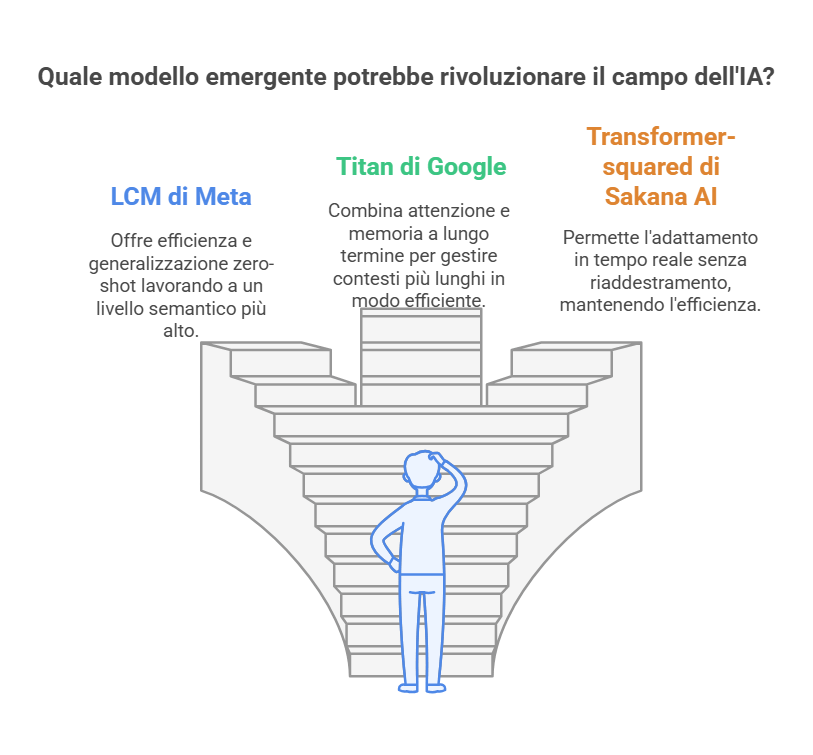

LCM di Meta

Il modello LCM (Large Concept Models) di Meta rappresenta un significativo passo avanti rispetto ai tradizionali modelli basati su token. LCM opera a un livello semantico più alto, lavorando con concetti piuttosto che con token individuali. Questo approccio consente al modello di ragionare in modo più astratto e indipendente dalla lingua o modalità specifica.

- Vantaggi:

- Efficienza e Accuratezza: LCM elabora sequenze più brevi in modo più efficiente mantenendo un’elevata accuratezza.

- Generalizzazione Zero-Shot: LCM eccelle in compiti di generalizzazione zero-shot, applicando conoscenze a lingue e modalità non viste durante l’addestramento.

- Multilinguismo: Supporta oltre 200 lingue per il testo e 76 lingue per la parola, rendendolo altamente inclusivo.

Titan di Google

Titan di Google introduce un modulo di memoria a lungo termine che emula il funzionamento del cervello umano. Questo modello combina meccanismi di attenzione con una memoria a lungo termine, permettendo di gestire contesti più lunghi e di memorizzare informazioni rilevanti durante l’inferenza.

- Vantaggi:

- Memoria a Lungo Termine: Titan può memorizzare e utilizzare informazioni contestuali storiche, superando la limitazione della finestra di contesto fissa dei modelli Transformer.

- Efficienza Computazionale: Il modello è progettato per essere più efficiente nel gestire lunghe sequenze di dati, riducendo i costi computazionali.

- Prestazioni Superiori: Titan ha dimostrato prestazioni superiori in vari compiti, inclusa la modellazione del DNA e la previsione delle serie temporali.

Transformer-squared di Sakana AI

Transformer-squared di Sakana AI è un modello auto-adattativo che può modificare il proprio comportamento in tempo reale senza la necessità di fine-tuning. Questo modello utilizza tecniche matematiche per allineare i suoi pesi con le richieste degli utenti durante l’inferenza, rendendolo altamente flessibile e adattabile.

- Vantaggi:

- Adattabilità in Tempo Reale: Transformer-squared può adattarsi a nuovi compiti senza la necessità di retraining, utilizzando una tecnica chiamata Singular Value Fine-tuning (SVF).

- Efficienza Computazionale: Questo modello richiede meno risorse computazionali rispetto ai tradizionali metodi di fine-tuning, grazie alla sua capacità di modificare solo i componenti essenziali.

- Versatilità: Transformer-squared ha dimostrato una notevole versatilità in vari compiti e architetture di modelli.

Tabella Comparativa

| Modello | Architettura | Vantaggi | Svantaggi |

|---|---|---|---|

| LCM (Meta) | Basato su concetti semantici | Efficienza, generalizzazione zero-shot, multilinguismo | Complessità nell’implementazione |

| Titan (Google) | Memoria a lungo termine e attenzione | Memoria a lungo termine, efficienza computazionale, prestazioni superiori | Richiede ulteriori test su larga scala |

| Transformer-squared (Sakana AI) | Auto-adattativo con SVF | Adattabilità in tempo reale, efficienza computazionale, versatilità | Potenziale sensibilità all’overfitting |

Conclusione

I modelli LCM di Meta, Titan di Google e Transformer-squared di Sakana AI rappresentano un passo avanti significativo nel superamento delle limitazioni dei modelli Transformer. Ognuno di questi modelli offre vantaggi unici che potrebbero rivoluzionare il campo dell’intelligenza artificiale, aprendo nuove possibilità per applicazioni più efficienti, adattabili e versatili.

Il Futuro dell’AI: Oltre i Transformer

- Elevata richiesta di risorse computazionali

- Complessità nel processo di fine-tuning

- Limitazioni nella finestra di contesto

- Maggiore efficienza nell’elaborazione delle sequenze

- Eccellente generalizzazione zero-shot

- Supporto per oltre 200 lingue testuali e 76 parlate

- Memoria contestuale estesa

- Maggiore efficienza computazionale

- Prestazioni superiori in compiti specifici come analisi DNA

- Adattamento in tempo reale senza fine-tuning

- Utilizzo efficiente delle risorse

- Alta versatilità in diversi compiti

- Ridurre significativamente i costi computazionali

- Migliorare l’adattabilità a nuovi compiti

- Aumentare l’efficienza nell’elaborazione del linguaggio

- Aprire nuove possibilità per applicazioni AI più sofisticate

Video in Italiano

Video in Inglese

Da informatico a cercatore di senso