Hai bisogno di una versione PDF dell’articolo per una lettura più comoda o per conservarne una copia? Clicca sul link sottostante per scaricare il PDF direttamente sul tuo dispositivo.

Scarica l’articolo in PDF (ITA)Do you need a PDF version of the article for easier reading or to keep a copy? Click the link below to download the PDF directly to your device.

Download Article as PDF (ENG)La Rivoluzione Silenziosa dei Modelli di Diffusione

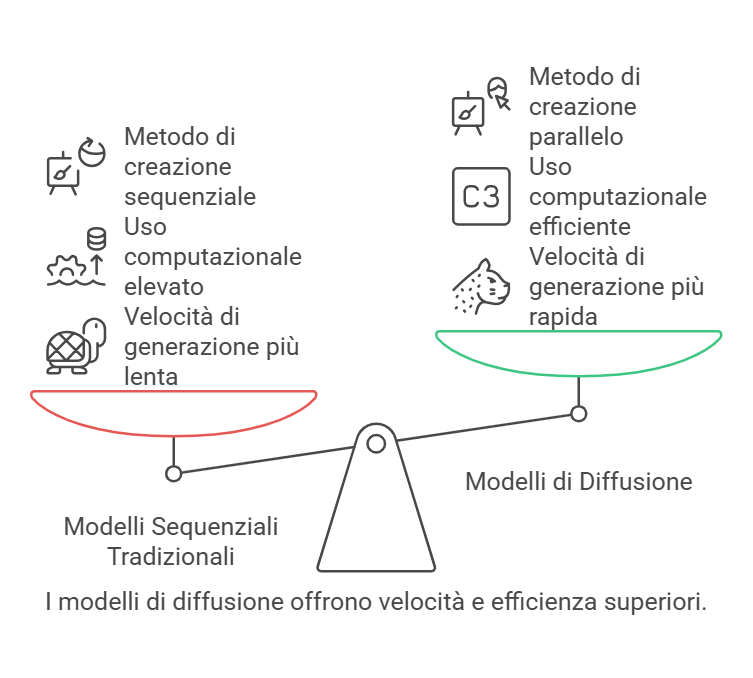

Per anni, abbiamo vissuto nell’era dei modelli autoregressivi, quei giganti dell’IA come GPT e Claude che generano testo in modo sequenziale, una parola dopo l’altra, da sinistra a destra. Questo approccio, per quanto ingegnoso, porta con sé un limite intrinseco: la velocità. Ogni token (unità di testo) deve attendere che quello precedente sia stato generato, creando un collo di bottiglia che rallenta l’intero processo. Come un pittore meticoloso che completa un dettaglio alla volta, questi modelli creano opere raffinate ma a costo di tempo ed enormi risorse computazionali3.

I modelli di diffusione, invece, rappresentano un approccio completamente diverso. Immaginate un artista che abbozza prima l’intera tela con tratti grossolani, per poi perfezionare progressivamente ogni area fino a ottenere l’opera completa. Ecco, questo è esattamente il funzionamento di Mercury: un processo “coarse-to-fine” che affina un’iniziale stima approssimativa attraverso passaggi paralleli di “denoising”2. Questa tecnica, già ampiamente utilizzata per generare immagini, video e audio con strumenti come Stable Diffusion e Midjourney, trova finalmente applicazione efficace anche nel campo del linguaggio4.

La mia prima reazione a questo cambiamento di paradigma è stata di stupore misto a scetticismo. Mi chiedevo: come può un modello generare testo di qualità senza seguire il flusso logico sequenziale del pensiero umano? La risposta, come spesso accade nell’IA, è sorprendentemente elegante.

Il Processo di Mascheramento: Il Cuore della Diffusione Testuale

La chiave del funzionamento di Mercury risiede nel concetto di “mascheramento”. Mentre i modelli di diffusione per immagini aggiungono rumore continuo ai valori dei pixel, i modelli di diffusione testuale come Mercury utilizzano speciali “token maschera” che funzionano come equivalenti del rumore4. Il processo inizia con un testo completamente mascherato che viene gradualmente rivelato e affinato in passaggi paralleli.

Questo approccio mi ricorda il modo in cui noi umani spesso concepiamo un’idea: non necessariamente parola per parola in sequenza, ma piuttosto come un concetto generale che viene progressivamente affinato e articolato. È affascinante vedere come l’intelligenza artificiale stia evolvendo verso metodi che, in qualche modo, rispecchiano aspetti del nostro processo cognitivo, pur seguendo percorsi computazionali radicalmente diversi.

Durante l’addestramento, Mercury impara a prevedere il completamento più probabile di porzioni di testo parzialmente oscurate, confrontando i risultati con le risposte reali. Le connessioni neurali che producono previsioni corrette vengono rafforzate, permettendo al modello di generare output sempre più accurati4. La bellezza di questo approccio è che il modello non è vincolato a considerare solo il testo generato in precedenza, permettendogli di correggere errori e migliorare progressivamente l’output complessivo.

Mercury: Il Pioniere della Nuova Frontiera

Inception Labs, fondata dal professor Stefano Ermon di Stanford insieme ai colleghi Volodymyr Kuleshov e Aditya Grover, ha concretizzato anni di ricerca in un prodotto commerciale che promette di ridefinire gli standard del settore3. Mercury non è solo un esperimento accademico, ma un modello pronto per applicazioni pratiche che offre vantaggi tangibili rispetto ai tradizionali LLM.

La prima versione rilasciata, Mercury Coder, è ottimizzata per la generazione di codice e supera le prestazioni di modelli veloci già esistenti come GPT-4o Mini e Claude 3.5 Haiku su benchmark standard di coding3. Ciò che trovo particolarmente impressionante è che, nonostante la sua velocità di inferenza significativamente superiore, Mercury mantiene un livello di qualità competitivo, dimostrando che i modelli basati sulla diffusione possono confrontarsi alla pari con i migliori LLM autoregressivi.

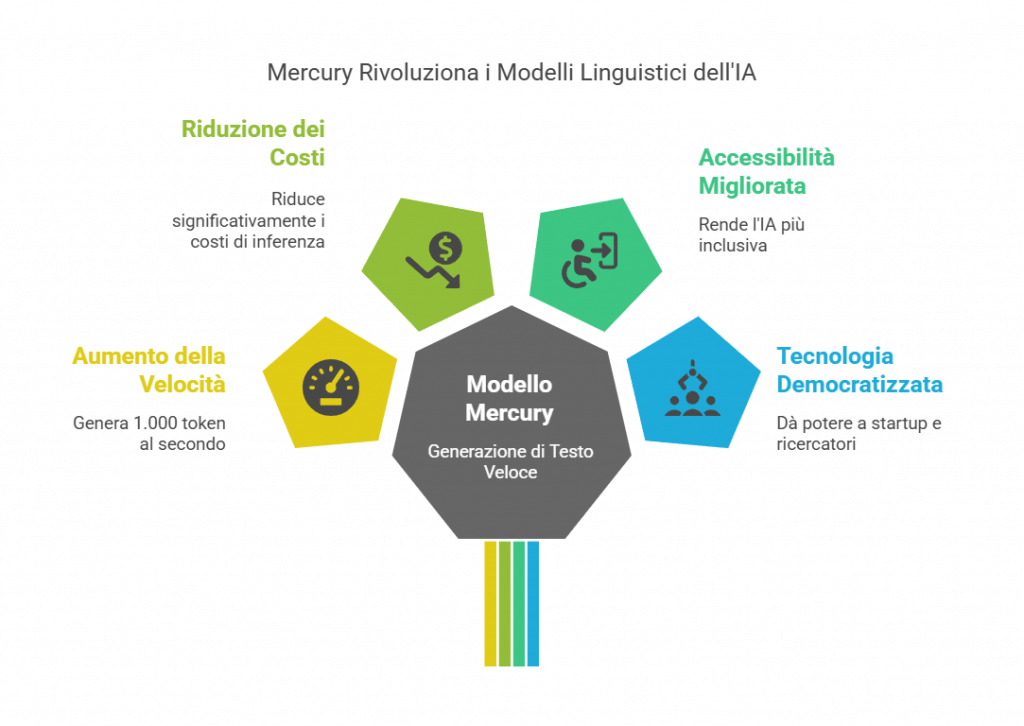

Prestazioni Senza Precedenti: La Velocità Come Game-Changer

I numeri parlano chiaro e sono francamente stupefacenti. Mentre i modelli tradizionali raggiungono un massimo di circa 200 token al secondo, Mercury è capace di generare oltre 1.000 token al secondo su GPU NVIDIA H100 standard3. Per contestualizzare questa statistica, alcuni modelli di frontiera funzionano a meno di 50 token al secondo, il che significa che Mercury offre un miglioramento di velocità fino a 20 volte superiore3. 🚀

Questa non è semplicemente un’ottimizzazione incrementale, ma un salto quantico che trasforma radicalmente le possibilità d’uso dell’IA generativa. Pensate a tutte quelle applicazioni in cui la latenza è critica: assistenti virtuali, strumenti di codifica in tempo reale, sistemi di risposta in emergenza. In tutti questi scenari, la differenza tra attendere secondi o frazioni di secondo può determinare il successo o il fallimento dell’interazione uomo-macchina.

Mi affascina particolarmente il fatto che questi miglioramenti di velocità derivino da avanzamenti algoritmici piuttosto che dalla dipendenza da hardware specializzato3. Ciò significa che, man mano che la tecnologia GPU continuerà ad avanzare, i guadagni di prestazioni di Mercury potrebbero amplificarsi ulteriormente, creando un effetto moltiplicativo sull’efficienza.

Implicazioni Economiche e Democratizzazione dell’IA

Uno degli aspetti più rilevanti di questa innovazione è il suo potenziale impatto sui costi dell’inferenza. Come umanista digitale, sono particolarmente sensibile al tema dell’accessibilità della tecnologia. L’approccio basato sulla diffusione di Mercury ha il potenziale di rendere l’IA di alta qualità più accessibile, riducendo drasticamente il prezzo dell’inferenza3.

“I nostri modelli sfruttano le GPU in modo molto più efficiente,” ha dichiarato Ermon. “Credo che questo sia un grande passo avanti. Cambierà il modo in cui le persone costruiscono modelli linguistici.”3

Questa efficienza computazionale non è solo una questione tecnica, ma ha profonde implicazioni sociali. Un’IA più economica significa più accessibilità, più inclusività, più possibilità per startup, ricercatori indipendenti e paesi in via di sviluppo di partecipare attivamente all’evoluzione di queste tecnologie. In un momento in cui si discute molto della concentrazione di potere nelle mani di poche grandi aziende tecnologiche, innovazioni come Mercury rappresentano una potenziale forza democratizzante.

Una Nuova Architettura per Nuove Possibilità

Ciò che trovo particolarmente stimolante è come Mercury stia ridefinendo i confini del possibile. I modelli di diffusione erano stati a lungo considerati impraticabili per il testo, ma le prestazioni di Mercury suggeriscono che il campo stia entrando in una nuova fase3. La domanda ora è quanto bene questi modelli si adatteranno e se potranno eguagliare la profondità e la complessità dei LLM tradizionali in applicazioni più sfumate.

Mercury è disponibile per i clienti enterprise attraverso API e implementazioni on-premise, consentendo alle aziende di integrare i dLLM (diffusion Large Language Models) nei loro flussi di lavoro senza dipendere da servizi basati su cloud3. Inception Labs supporta anche il fine-tuning del modello, rendendo Mercury adattabile a vari casi d’uso, dalla ricerca al supporto clienti, fino alle applicazioni enterprise su larga scala3.

Ho riflettuto su come questa tecnologia potrebbe influenzare il mio lavoro quotidiano. Immagino strumenti di scrittura assistita che generano istantaneamente bozze complete che posso poi perfezionare, o assistenti di ricerca che producono sintesi di articoli scientifici in tempo reale mentre leggo. Le possibilità sono entusiasmanti e, allo stesso tempo, sollevano interrogativi sulla natura della creatività e dell’autenticità nell’era dell’IA generativa ultrarapida.

La Dimensione Umana della Velocità Artificiale

Come umanista digitale, mi trovo spesso a riflettere sulla relazione tra avanzamento tecnologico e esperienza umana. La velocità di Mercury pone interrogativi interessanti: siamo pronti per un’IA che genera risposte quasi istantaneamente? Come cambierà il nostro rapporto con la tecnologia quando il tempo di risposta non sarà più percepibile?

Andrew Ng, figura di spicco nel campo dell’IA, ha sottolineato l’importanza di questa innovazione in un tweet: “I Transformer hanno dominato la generazione di testo LLM, generando token in modo sequenziale. Questo è un interessante tentativo di esplorare i modelli di diffusione come alternativa, generando l’intero testo contemporaneamente usando un processo coarse-to-fine. Congratulazioni @StefanoErmon e team!”3

Credo che la vera sfida sarà bilanciare questa velocità con la qualità e l’affidabilità che ci aspettiamo dai sistemi di IA. La velocità non deve compromettere la precisione o l’utilità dell’output. Allo stesso tempo, mi domando se questa immediatezza potrebbe modificare le nostre aspettative sulla comunicazione in generale, portandoci a preferire risposte rapide anche nelle interazioni umane.

Il Futuro dei Modelli di Diffusione nel Linguaggio

Guardando al futuro, sono convinto che i modelli di diffusione come Mercury rappresentino solo l’inizio di una nuova traiettoria evolutiva per l’IA linguistica. Così come i modelli di diffusione hanno rivoluzionato la generazione di immagini, video e audio negli ultimi anni, potremmo assistere a una trasformazione simile nel campo del linguaggio.

Immagino futuri modelli di diffusione multimodali capaci di generare contemporaneamente testo, immagini e altri media in modo coerente e integrato. Prevedo anche l’emergere di architetture ibride che combinano i punti di forza dei modelli autoregressivi e di diffusione, sfruttando la profondità contestuale dei primi e la velocità parallela dei secondi. 💡

Non sottovaluterei nemmeno l’impatto ambientale di questa innovazione. L’efficienza computazionale di Mercury potrebbe tradursi in un minore consumo energetico per task di IA, contribuendo a rendere il settore più sostenibile. In un’epoca in cui l’impronta ecologica dell’IA è sotto scrutinio, questo aspetto non è secondario.

Conclusione: Un Nuovo Capitolo nell’Evoluzione dell’IA

L’introduzione di Mercury segna l’inizio di un nuovo capitolo nell’evoluzione dei modelli linguistici. Come tutte le grandi innovazioni, non si tratta solo di miglioramenti incrementali, ma di un ripensamento fondamentale del modo in cui affrontiamo un problema. I modelli di diffusione offrono una prospettiva fresca sul language processing, consentendo una generazione testuale che è al contempo rapida, efficiente e di alta qualità.

Sono entusiasta di vedere come questa tecnologia evolverà nei prossimi anni e come influenzerà le nostre interazioni quotidiane con l’IA. Come umanista digitale, resto vigile sui potenziali impatti sociali e culturali, ma anche fiducioso che innovazioni come Mercury possano democratizzare l’accesso all’IA e aprire nuove possibilità creative ed espressive.

Il viaggio dell’intelligenza artificiale è appena iniziato, e i modelli di diffusione rappresentano un passo avanti particolarmente significativo. La strada è ancora lunga, ma la direzione è promettente. E mentre continuiamo a esplorare questo territorio inesplorato, ricordiamoci che la tecnologia più potente è quella che potenzia e amplifica ciò che ci rende umani.

🚀 La Rivoluzione dei Modelli di Diffusione

Video in Italiano

Video in Inglese

Da informatico a cercatore di senso