Hai bisogno di una versione PDF dell’articolo per una lettura più comoda o per conservarne una copia? Clicca sul link sottostante per scaricare il PDF direttamente sul tuo dispositivo.

Scarica l’articolo in PDF (ITA)Do you need a PDF version of the article for easier reading or to keep a copy? Click the link below to download the PDF directly to your device.

Download Article as PDF (ENG)

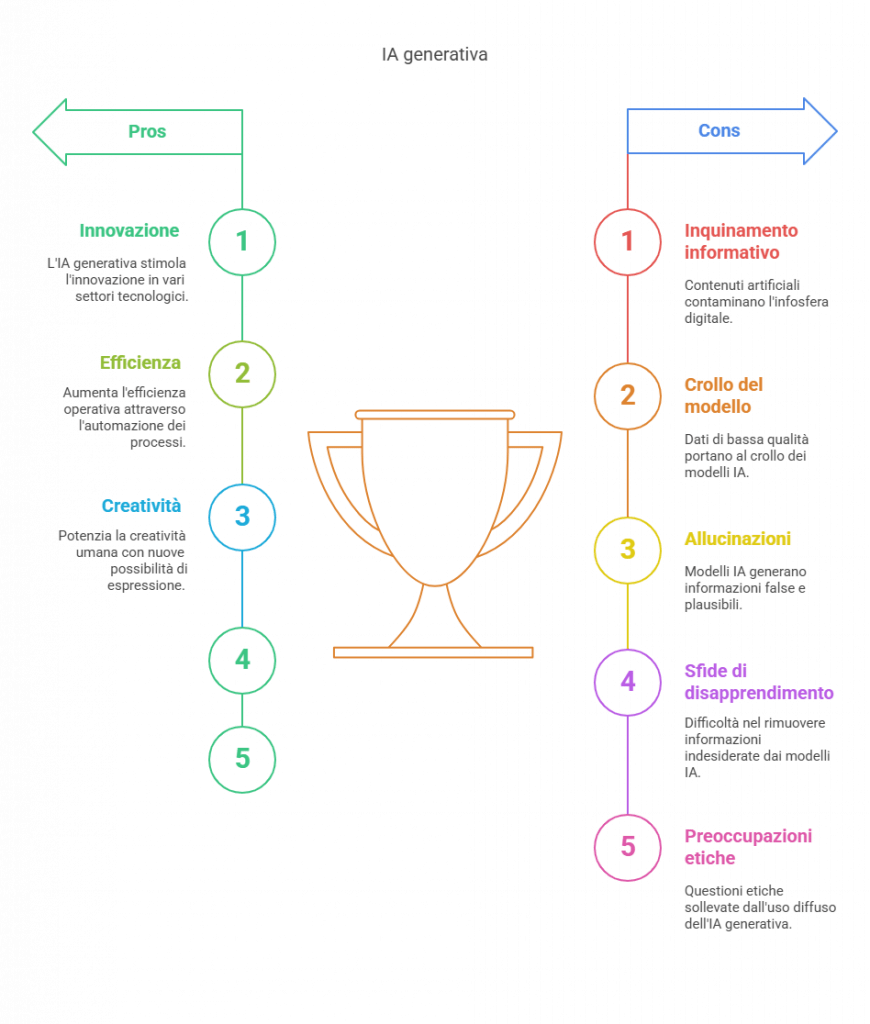

Un’infosfera sempre più contaminata

Immaginate un lago cristallino in cui viene riversata quotidianamente una piccola quantità di sostanze inquinanti. Con il passare del tempo, queste sostanze non solo deteriorano la qualità dell’acqua, ma iniziano anche a modificare l’ecosistema stesso. Questa è l’analogia che emerge dalle parole di Floridi quando descrive ciò che sta accadendo alla nostra infosfera.

“La sfera digitale vede, accanto ai dati ‘reali’, la presenza di un numero crescente di contenuti di origine artificiale, prodotti dall’AI generativa”, spiega il filosofo. Il problema fondamentale è che questi contenuti – spesso contaminati da “allucinazioni”, ovvero informazioni false ma plausibili – vanno poi a costituire i futuri dataset per l’addestramento dei modelli di intelligenza artificiale successivi.

Il circolo vizioso del “model collapse”

Con la lucidità che lo contraddistingue, Floridi introduce il concetto di “model collapse“, un fenomeno preoccupante che rappresenta la deriva finale di questo processo di inquinamento informativo: “È dovuto all’introduzione di dati che non sono di alta qualità e che portano a modelli di minori qualità, che generano a loro volta dati ancora più scarsi. Si entra in un circolo vizioso in cui cattiva qualità genera ulteriore cattiva qualità. Fino a un punto in cui si parla di collasso per l’inutilità del prodotto ottenuto”1.

Questo allarme trova conferma nei dati più recenti. Secondo informazioni pubblicate nell’aprile 2025, i nuovi modelli di OpenAI, o3 e o4-mini, mostrano tassi di allucinazione significativamente superiori rispetto ai loro predecessori, nonostante siano stati progettati per ragionare in modo più approfondito prima di rispondere3. Il modello o3 è incappato in allucinazioni nel 33% dei casi, circa il doppio rispetto ai predecessori o1 (16%) e o3-mini (14,8%), mentre o4-mini ha raggiunto un inquietante tasso del 48% – quasi una risposta su due risulta inventata3. Ciò che è più preoccupante è che OpenAI stessa non sembra in grado di spiegare con certezza le cause di questo peggioramento.

Machine Unlearning: disimparare per migliorare?

Nell’intervista, Floridi affronta anche un tema cruciale per il futuro dell’IA: il “machine unlearning”, ovvero la capacità di far “disimparare” ai modelli determinate informazioni. “Sono strumentazioni che servono a risolvere il problema dell’output che non vogliamo”, spiega il filosofo1.

Il concetto è affascinante: si individuano informazioni che il nuovo modello non dovrebbe produrre e si avvicina il vecchio modello al nuovo, rimuovendo le informazioni indesiderate. Tuttavia, Floridi aggiunge un caveat importante: “Il machine unlearning funziona bene quando io faccio il training con il machine learning pensando già in anticipo che potrei voler invertire il processo”.

Questa osservazione acquista particolare rilevanza alla luce delle recenti ricerche. Uno studio pubblicato a gennaio 2025 su arXiv ha evidenziato come anche il gold standard dell’unlearning – il retraining da zero – possa fallire in determinate condizioni, e come l’eliminazione di dati duplicati possa portare a un significativo degrado delle prestazioni del modello.

Le allucinazioni: un problema strutturale

Uno degli aspetti più illuminanti dell’intervista è quando Floridi chiarisce che le allucinazioni non sono un bug, ma una caratteristica intrinseca dei sistemi di IA generativa: “Le allucinazioni fanno parte del sistema. Questi sono sistemi statistici che non possono essere dimostrabilmente sicuri al 100%”1.

Il filosofo prosegue con una distinzione fondamentale rispetto alla vecchia intelligenza artificiale: “Contrariamente alla vecchia intelligenza artificiale, che aveva anche la possibilità di avere risultati dimostrabilmente accertabili, in questo caso si tratta di strumenti statistici. E quindi sta nella statistica stessa la possibilità dell’errore, dell’allucinazione”1.

Questa caratteristica strutturale pone interrogativi profondi sulla nostra crescente dipendenza da questi sistemi. Come possiamo distinguere l’informazione autentica da quella generata artificialmente? Come possiamo navigare in un’infosfera sempre più contaminata?

Formazione e adattamento: correre senza inseguire

Nella parte conclusiva dell’intervista, Floridi offre spunti preziosi sul tema della formazione in relazione alle nuove tecnologie. Interrogato sulla possibilità di introdurre il prompt engineering nelle scuole, il filosofo mette in guardia contro l’inseguimento acritico delle mode tecnologiche: “Quando si cambia il sistema formativo di base, ci vogliono anni per l’implementazione”1, ricordando che tra ideazione e realizzazione di riforme educative possono passare 7-8 anni, rendendo obsolete molte delle competenze specifiche insegnate.

Invece, Floridi sostiene che “cose come il prompt engineering o simili skills si possono acquisire nel giro di pochissime settimane nel mondo del lavoro”1, suggerendo che sia più appropriato che sia l’azienda a fornire formazione su questi aspetti specifici, mentre l’educazione di base dovrebbe concentrarsi su principi più duraturi.

Conclusione: verso un’ecologia dell’informazione

L’intervista con Luciano Floridi ci lascia con la consapevolezza che siamo di fronte a una sfida epocale: preservare la qualità e l’integrità della nostra infosfera. Come ambientalisti digitali, dobbiamo sviluppare nuove forme di alfabetizzazione mediatica e critica, capaci di riconoscere e arginare l’inquinamento informativo.

La prevenzione, come sottolinea il filosofo, sarebbe la strada più intelligente, ma “purtroppo, la prevenzione non è tipica della storia umana, quindi temo che si andrà poi ai ripari, a risolvere questioni che si sarebbero dovute anticipare”1. Una riflessione che, nella sua lucida amarezza, ci invita a non ripetere con l’infosfera gli stessi errori commessi con il nostro ambiente naturale.

In un mondo in cui l’intelligenza artificiale generativa continua a evolversi a ritmi vertiginosi, la bussola etica e filosofica offerta da pensatori come Floridi diventa un punto di riferimento essenziale, non solo per comprendere il presente, ma per immaginare e costruire un futuro digitale più consapevole e sostenibile.

Citations:

- https://ainews.it/i-modelli-generativi-inquinano-linformazione-la-nostra-intervista-con-luciano-floridi-ai-talks-13/

- https://it.wikipedia.org/wiki/Intelligenza_artificiale_generativa

- https://www.hwupgrade.it/news/scienza-tecnologia/o3-e-o4-mini-sono-piu-inclini-alle-allucinazioni-inventano-il-doppio-rispetto-ai-predecessori-e-openai-non-sa-perche_137996.html

- https://arxiv.org/abs/2501.16663

- https://ainews.it/i-modelli-generativi-inquinano-linformazione-la-nostra-intervista-con-luciano-floridi-ai-talks-13/

- https://www.ibm.com/it-it/think/topics/ai-model

- https://www.agendadigitale.eu/industry-4-0/ai-index-2025-ecco-tracciati-tutti-i-progressi-dellintelligenza-artificiale/

- https://www.edps.europa.eu/data-protection/technology-monitoring/techsonar/machine-unlearning

- https://www.redhat.com/it/topics/ai/predictive-ai-vs-generative-ai

- https://pragmaetimos.com/it/limpatto-dellintelligenza-artificiale-generativa-nella-data-analysis/

- https://myndo.it/i-6-migliori-tool-di-ai-per-lanalisi-dei-dati-nel-2024/

- https://www.agendadigitale.eu/cultura-digitale/ampliare-la-diffusione-dei-dati-statistici-con-lai-i-costi-che-frenano-linnovazione/

- https://www.syntho.ai/it/ai-generated-synthetic-data/

- https://www.agendadigitale.eu/cultura-digitale/capire-le-allucinazioni-dellia-perche-accadono-e-come-gestirle/

- https://research.google/blog/announcing-the-first-machine-unlearning-challenge/

- https://www.sap.com/italy/products/artificial-intelligence/what-is-generative-ai.html

- https://www.netcoadv.it/allucinazioni-intelligenza-artificiale/

- https://blog.ml.cmu.edu/2025/04/18/llm-unlearning-benchmarks-are-weak-measures-of-progress/

- https://www.festivalstatistica.it/2024/alla-scoperta-dellintelligenza-artificiale-generativa-un-viaggio-europeo-nellai-per-la-statistica-ufficiale/

- https://www.cio.com/article/3965880/ai-agent-per-i-cio-sono-il-futuro-ma-con-cautela.html

- https://llmunlearningsemeval2025.github.io

- https://www.capgemini.com/it-it/prospettive/i-nostri-articoli/rivoluzione-dei-dati-sintetici/

Da informatico a cercatore di senso