Dentro la Scatola Nera: Quando l’IA Decide del Tuo Farmaco

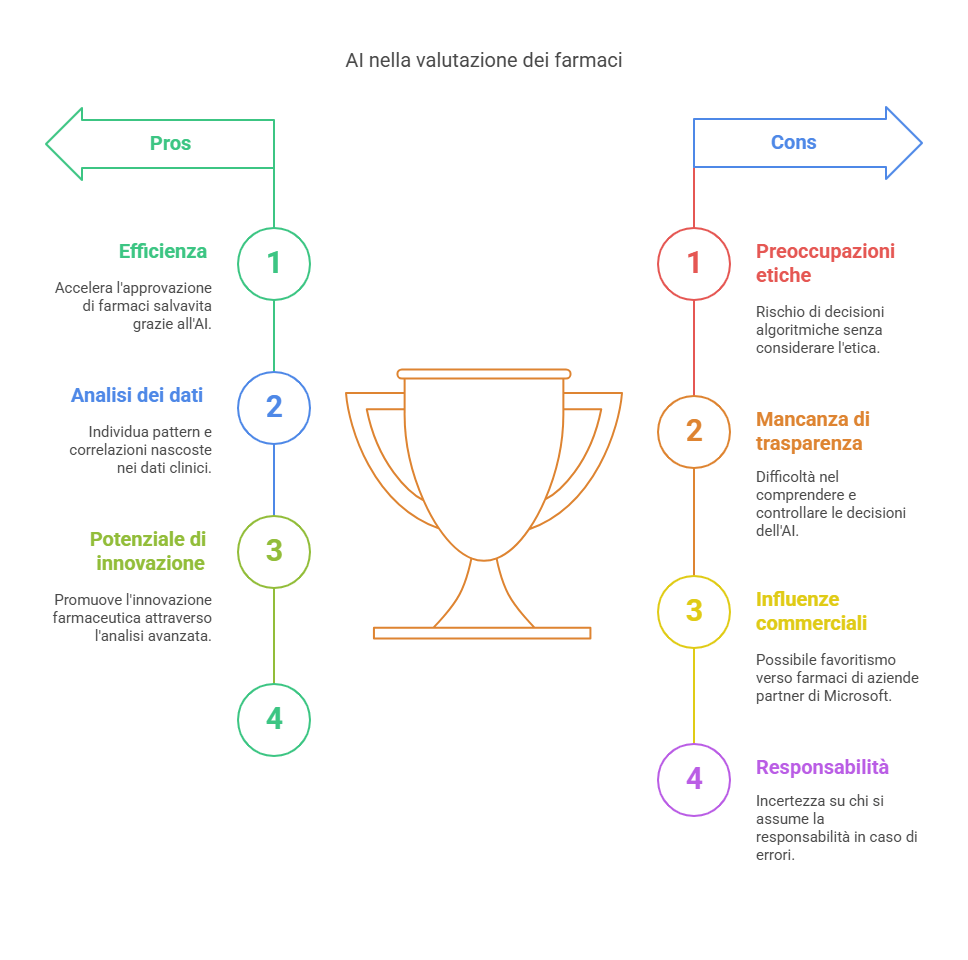

Certo, capisco la promessa di efficienza, la possibilità di accelerare i tempi di approvazione di farmaci salvavita. Ma a quale prezzo? Immaginatevi la scena: un algoritmo, addestrato su montagne di dati, che setaccia studi clinici, report di sicurezza, statistiche. Un algoritmo che, in teoria, dovrebbe essere in grado di individuare pattern, correlazioni, segnali che sfuggono all’occhio umano.

Un algoritmo che, in ultima analisi, esprime un giudizio: “Questo farmaco è sicuro ed efficace” oppure “Questo farmaco presenta troppi rischi”. E noi? Noi saremmo ridotti a semplici numeri, a pazienti anonimi che si fidano ciecamente di una decisione presa da una macchina. Una macchina che, per quanto sofisticata, non potrà mai comprendere la complessità della vita umana, la sofferenza, la speranza. Mi chiedo: chi controllerà questo cderGPT?

Chi deciderà quali dati verranno utilizzati per addestrarlo? Chi si assumerà la responsabilità se l’algoritmo commetterà un errore, se approverà un farmaco dannoso o boccerà una cura miracolosa?

La risposta, temo, è che nessuno lo sa. O meglio, lo sanno in pochi, rinchiusi in stanze ovattate, lontani dalle nostre paure e dalle nostre incertezze. E poi c’è Microsoft, gigante tech che ha investito miliardi in OpenAI. Un gigante che, legittimamente, vuole veder fruttare il suo investimento. Ma come possiamo essere sicuri che gli interessi commerciali di Microsoft non influenzeranno le decisioni di cderGPT?

Come possiamo garantire che l’algoritmo non favorirà i farmaci prodotti dalle aziende partner di Microsoft, a scapito di alternative più economiche o più efficaci?

Speranza e dubbi sul futuro della nostra salute.

Lo so, forse sono paranoico. Forse sto esagerando. Ma non riesco a scrollarmi di dosso questa sensazione di disagio, questa paura di essere manipolato, di essere trasformato in una pedina in un gioco più grande di me.

Eppure, non voglio chiudere la porta ai progressi che questa tecnologia può portare. Forse la chiave per accompagnare questa rivoluzione non è il rifiuto, ma la vigilanza e la partecipazione consapevole.

Forse serve un comitato etico misto – un punto di incontro tra ingegneri informatici, medici, pazienti, filosofi, e persino giuristi – che sorvegli il funzionamento di cderGPT. Un gruppo trasparente, che lavori per garantire che l’algoritmo sia allenato e usato in modo responsabile, che tenga conto delle complessità umane e non si limiti ai dati numerici.

Un comitato che possa tradurre la “scatola nera” in una finestra aperta, dove la tecnologia e l’etica dialogano, permettendo a tutti noi di sentirci parte della scelta, del controllo, della speranza.

Fino ad allora, continuerò a sentirmi come se stessi guardando dentro una scatola nera, senza sapere cosa c’è dentro, senza sapere chi la controlla, senza sapere se mi proteggerà o mi danneggerà. Ma almeno, ora, posso immaginare una via per far sentire la nostra voce anche in quella stanza. E questo già porta un po’ di luce nel buio.

Se un algoritmo decidesse cosa introdurre e far scorrere nelle tue vene, saresti pronto a fidarti?

♻ Ti senti pronto a permettere che un algoritmo decida

Raffaella Zanetti Esperta di Neuro Marketing

cosa far scorrere nelle tue vene?

♻ È possibile conciliare progresso digitale e umanità?

♻ Questa scelta riguarda anche noi, i nostri figli o i “gradini più alti”?

♻ Lascia le tue riflessioni affinché si senta anche la tua voce. Fai parte di questo

umanesimo digitale: esprimi la tua personale riflessione qui sotto.

Da informatico a cercatore di senso