1. Introduzione: Il Silenzioso Invasore del Cyberspazio

Immaginiamo il cyberspazio non più come una piazza digitale vibrante di voci umane e interazioni autentiche, ma come un palcoscenico dove la maggior parte degli attori non sono persone, bensì entità invisibili, automatizzate. Questa non è una visione distopica del futuro, ma la cruda realtà che emerge dal report “AI Bad Bot 2025” di Imperva, una società di Thales. L’analisi non è un semplice campanello d’allarme tecnico, ma un vero e proprio manifesto che ci costringe a una riflessione profonda sulla nostra esistenza digitale e sulla natura stessa della nostra interazione online.

Il report dipinge un quadro allarmante e inequivocabile: i bot malevoli hanno raggiunto “livelli epidemici” e la loro minaccia è esponenzialmente amplificata dall’Intelligenza Artificiale. Grazie all’IA, anche attaccanti con scarse competenze tecniche possono lanciare attacchi sofisticati in modo più rapido ed economico che mai. Questo dato non è confinato ai laboratori di cybersecurity, ma permea ogni aspetto del nostro quotidiano digitale, ridefinendo le fondamenta stesse della nostra esperienza online.

Per un umanista digitale, questi numeri non sono solo statistiche fredde. Essi rappresentano una sfida fondamentale alla nostra percezione di autenticità, fiducia e interazione umana nel cyberspazio. Se la maggior parte del traffico online è generata da macchine, cosa significa per la democrazia, il commercio, le relazioni sociali e la formazione dell’opinione pubblica? È imperativo andare oltre la mera difesa tecnica e interrogare le implicazioni etiche, filosofiche e sociali di questa “epidemia invisibile” che sta ridefinendo il nostro ambiente digitale.

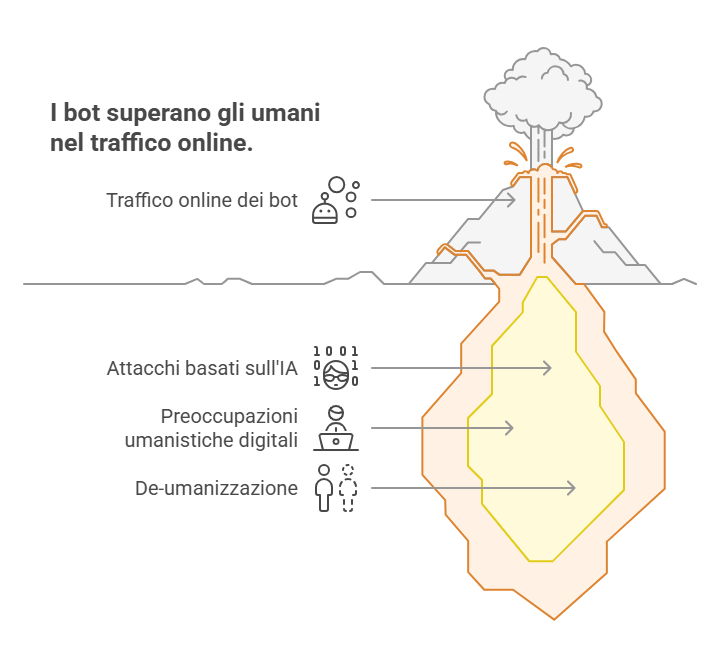

Il report rivela che, nel 2024, i bot hanno superato gli umani nel volume di traffico online, costituendo il 51% del totale. Questo dato numerico non è un semplice fatto tecnico; segna un cambiamento qualitativo fondamentale nella natura dell’interazione online. Se oltre la metà del “popolo” che abita la rete non è umano, lo spazio digitale cessa di essere primariamente un ambiente antropocentrico. Per un umanista digitale, ciò solleva interrogativi profondi sull’autenticità delle comunità online, sulla veridicità delle informazioni e sul concetto stesso di “cittadinanza digitale”. La nostra esperienza quotidiana di navigazione, acquisto, socializzazione è mediata e, in gran parte, influenzata da entità non umane. Questa progressiva de-umanizzazione può erodere la fiducia reciproca, rendere più difficile la connessione autentica e avere ripercussioni sulla coesione sociale e sui processi democratici, dove la manipolazione algoritmica può prevalere sul dibattito umano. Non è più solo un problema tecnico, ma una questione esistenziale per la nostra società connessa.

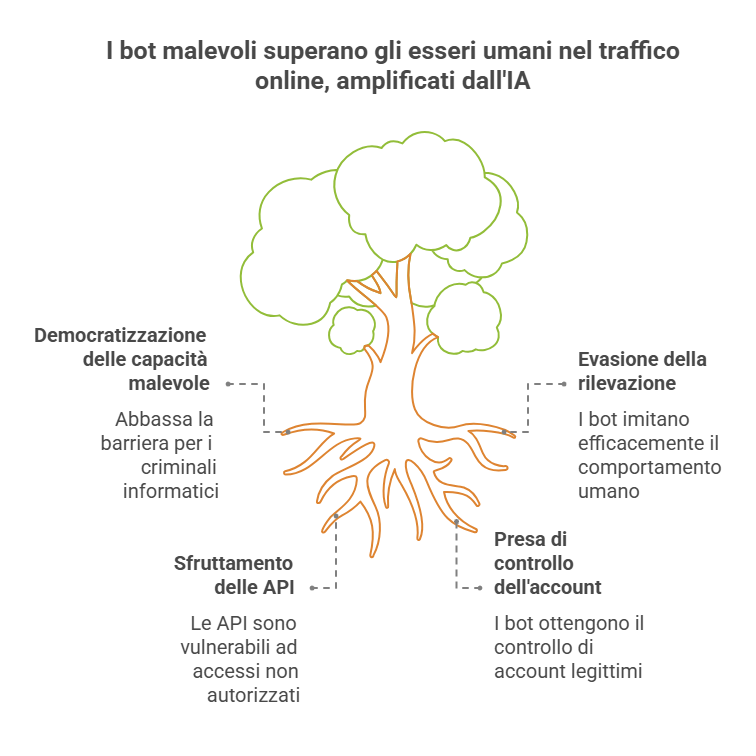

Un’altra implicazione cruciale è che l’IA sta agendo come un “democratizzatore” delle capacità malevole. Il report sottolinea che, con l’IA, “attaccanti con scarse competenze possono lanciare bot sofisticati più velocemente ed economicamente che mai”.1 Tradizionalmente, gli attacchi informatici più sofisticati richiedevano competenze tecniche elevate e risorse significative. L’IA, in questo contesto, abbassa drasticamente la barriera d’ingresso per i cybercriminali. Non è più necessario essere un “hacker d’élite” per orchestrare campagne complesse. Ciò si traduce in un aumento esponenziale della frequenza, della diversità e dell’imprevedibilità degli attacchi. Le difese tradizionali, spesso reattive e basate su firme, faticano a tenere il passo. L’asimmetria di potere si sposta drasticamente a favore degli attaccanti, costringendo il settore della sicurezza a un’evoluzione continua e accelerata, in una corsa agli armamenti digitale senza fine.

2. L’Epidemia Invisibile: Numeri che Fanno Riflettere

Il report “The AI Bot Epidemic: The Imperva 2025 Bad Bot Report” non lascia spazio a interpretazioni, dipingendo un quadro che va oltre la semplice statistica e si configura come una vera e propria crisi digitale. Nel 2024, per la prima volta nella storia di internet, i bot hanno costituito la maggioranza del traffico online, raggiungendo il 51% del totale. Questo significa che ogni volta che un utente naviga, interagisce o acquista online, è più probabile che la controparte del traffico non sia un essere umano. Di questo traffico bot, una percentuale allarmante del 37% è attribuibile a bot malevoli. Questo dato evidenzia come quasi quattro interazioni su dieci, non generate da umani, siano intenzionalmente dannose, mirando a frodi, furti di dati o interruzioni di servizio. L’Intelligenza Artificiale è il catalizzatore di questa epidemia, consentendo agli attaccanti di lanciare attacchi bot sofisticati in modo “più veloce ed economico che mai” , rendendo le minacce più pervasive e difficili da contrastare.

L’intelligenza artificiale non è più solo uno strumento per l’automazione benigna; è diventata un potente moltiplicatore di capacità per i cybercriminali. L’IA permette ai bot di “evadere il rilevamento”, “sfruttare le API” e lanciare “attacchi di Account Takeover” con una precisione e una scala senza precedenti. L’IA generativa, in particolare, può essere usata per ottimizzare attacchi ransomware e phishing, creando testi impeccabili e convincenti nella voce di “leader di pensiero” per truffe sempre più sofisticate. Questa capacità di generare contenuti indistinguibili dalla realtà umana rende la distinzione tra ciò che è autentico e ciò che è artificiale sempre più sfumata, come evidenziato dalla difficoltà di tracciare la sorgente di informazioni manipolate.

I dati aggregati, che mostrano il 51% del traffico internet generato da bot e il 37% di questo come malevolo , insieme alla capacità dell’IA di evadere il rilevamento e generare contenuti convincenti 1, portano a una crisi profonda della verificabilità online. Gli utenti non possono più fidarsi facilmente della provenienza o dell’autenticità delle informazioni, delle interazioni o persino delle identità digitali. Questa erosione della “fiducia digitale” 4 ha effetti a cascata su tutti i pilastri dell’economia e della società digitale: diventa più difficile distinguere aziende legittime da truffe, notizie vere da disinformazione, e interazioni umane genuine da manipolazioni automatizzate. La reputazione di affidabilità e integrità, fondamentale per la fiducia digitale , è costantemente sotto attacco. Si pone la domanda fondamentale: come possiamo costruire una società digitale sana se la sua base – la fiducia nelle interazioni e nelle informazioni – è costantemente minata da un’invisibile armata di bot?

Un’altra considerazione fondamentale è l’impatto economico di questa evoluzione. L’affermazione che l’IA rende gli attacchi bot sofisticati “più veloci ed economici che mai” per “attaccanti con scarse competenze” indica un cambiamento significativo nell’economia del cybercrimine. Questo non è solo un vantaggio tecnico per i criminali, ma una riduzione dei costi e delle competenze richieste che abbassa la barriera d’ingresso per un numero molto più ampio di attori malevoli. Ciò significa che il lancio di attacchi su larga scala, persistenti e diversificati, non è più appannaggio esclusivo di gruppi statali o organizzazioni criminali altamente strutturate. Chiunque, con risorse minime, può ora causare danni significativi. L’implicazione per la difesa è che non è più sufficiente affrontare attacchi isolati o di alto profilo. La quantità e la varietà degli attacchi aumenteranno esponenzialmente, rendendo i meccanismi di difesa tradizionali, spesso reattivi, insufficienti. Il “ritorno sull’investimento” per i cybercriminali aumenta, incentivando un’escalation continua delle attività malevole.

| Indicatore | Dato Chiave (2024) | Fonte nel Report |

| Percentuale di traffico internet totale da bot | 51% | , Page 3 |

| Percentuale di traffico web da bot malevoli | 37% | , Page 3 |

| Impatto dell’IA sugli attaccanti | Più veloci, più economici, più sofisticati (anche per attaccanti con scarse competenze) | , Page 2 |

| Traffico bot avanzato che colpisce le API | 44% | , Page 5 |

La presentazione di queste statistiche fondamentali in una tabella offre una sintesi visiva immediata e di forte impatto sulla portata del problema. I numeri, sebbene astratti, diventano concreti e urgenti quando condensati in un formato facilmente assimilabile. Questa tabella rafforza il senso di urgenza della narrazione, dimostrando in modo conciso che i bot non sono un problema marginale ma una forza dominante e spesso malevola nel panorama online.

Essa funge da solida base fattuale per le successive discussioni sulle implicazioni etiche e sociali. Ancorare le riflessioni umanistiche a dati concreti e allarmanti ne aumenta la credibilità e la risonanza. Infine, sebbene l’articolo sia di natura narrativa e riflessiva, un umanista digitale apprezza la chiarezza dei dati. Questa tabella offre un punto di riferimento rapido e conciso per gli aspetti quantitativi, bilanciando la profondità qualitativa del testo.

3. Le Tattiche dell’Ombra: Come i Bad Bot Ci Attaccano

I bot potenziati dall’IA sono diventati maestri nell’occultamento e nel mimetismo, rendendo il loro rilevamento una sfida sempre più ardua. Utilizzano tecniche avanzate per “evadere il rilevamento” , come l’uso di proxy residenziali, che permettono loro di confondersi con il traffico di utenti reali e legittimi. Le botnet, vaste reti di computer infetti (“zombie”), possono nascondere la loro presenza e le loro attività malevole cambiando frequentemente indirizzi IP, utilizzando reti Tor o tecniche di “fast-flux”, rendendo estremamente difficile per i ricercatori di sicurezza e le autorità rilevarle e disabilitarle. L’IA generativa, inoltre, è in grado di creare malware polimorfici, che modificano il proprio codice per eludere il rilevamento da parte dei software antivirus tradizionali , e di automatizzare attacchi di phishing e “credential stuffing”, aggirando i sistemi di sicurezza basati su regole fisse.

Un esempio lampante di evasione è un attacco DDoS (Distributed Denial of Service) orchestrato da una botnet che impiega migliaia di indirizzi IP residenziali legittimi. In questo scenario, bloccare l’attacco basandosi solo sull’IP diventa quasi impossibile, poiché si rischia di bloccare anche utenti autentici, causando un “falso positivo”. Questo rende i Web Application Firewall (WAF) tradizionali, che si basano su regole statiche o blocchi IP, inefficaci contro i bot avanzati, i quali sono programmati per cambiare continuamente i loro profili.

Le API (Application Programming Interfaces) sono il tessuto connettivo invisibile che alimenta la maggior parte dei servizi digitali moderni, dalle app mobili ai dispositivi intelligenti. Tuttavia, questa ubiquità le rende anche un obiettivo primario per i bot malevoli. Il 44% del traffico bot avanzato prende di mira specificamente le API , spesso con l’intento di eseguire “scraping” di dati (furto di informazioni), frodi o attacchi di “credential stuffing”.Le API sono intrinsecamente vulnerabili a tentativi di accesso non autorizzato e abusi, poiché sono progettate per facilitare lo scambio di dati.

Un attacco comune che sfrutta le API è il “credential stuffing”, dove i bot utilizzano strumenti automatizzati per testare migliaia di combinazioni di username e password rubate da precedenti violazioni di dati contro gli endpoint di login delle API di vari servizi. Questo permette agli attaccanti di ottenere un accesso non autorizzato agli account degli utenti. Un altro esempio, meno ovvio ma altrettanto dannoso, è il “cart abandonment” fraudolento: bot malevoli selezionano articoli da un negozio online e li aggiungono al carrello senza mai completare la transazione. Di conseguenza, quando un utente legittimo tenta di acquistare il prodotto, riceve un messaggio di “esaurimento scorte”, anche se l’articolo è fisicamente disponibile, causando perdite di vendite e frustrazione.

L’acquisizione di account (Account Takeover – ATO) è l’obiettivo finale e più devastante di molti attacchi bot. Un attacco ATO di successo consente all’attaccante di ottenere il controllo completo di un account legittimo, permettendogli di modificare i dettagli dell’account, installare software malevolo (malware) o accedere e rubare dati finanziari sensibili, come i numeri delle carte di credito. La gravità di questa minaccia è sottolineata dal fatto che l’81% dei data breach è direttamente correlato a credenziali trafugate o troppo deboli. I bot sono strumenti ideali per gli attacchi ATO, impiegati in tecniche come il “password spraying” (testare una password comune su un vasto elenco di username) e il “brute force” (tentativi multipli e sistematici di indovinare la password), fino a quando non trovano una combinazione valida.

Consideriamo un attacco di phishing, sempre più spesso potenziato dall’IA generativa per creare email o messaggi ingannevoli e altamente convincenti. Un utente, ingannato dalla sofisticazione del messaggio, potrebbe rivelare le proprie credenziali di accesso. Una volta ottenute, i bot utilizzano queste credenziali per il “credential stuffing” su una moltitudine di altri siti e servizi , sfruttando la tendenza degli utenti a riutilizzare le stesse password. Le conseguenze di un ATO possono essere devastanti, spaziando dalle truffe finanziarie dirette al furto di identità, all’esfiltrazione di dati sensibili e al danno reputazionale per l’individuo o l’azienda colpita.

Il panorama delle minacce informatiche è in continua evoluzione, con i cybercriminali che adottano metodi sempre più sofisticati. L’Intelligenza Artificiale generativa è ora ampiamente utilizzata per creare attacchi di phishing altamente credibili, che hanno portato a un aumento significativo dei tentativi riusciti e a perdite finanziarie rilevanti per le vittime.Il “malvertising” sfrutta la pubblicità online per reindirizzare gli utenti ignari a siti compromessi, spesso senza che l’utente se ne accorga. Un’altra minaccia crescente è la riduzione del tempo che intercorre tra la scoperta di una vulnerabilità software e il suo sfruttamento da parte degli aggressori. Un caso di studio notevole è quello del gruppo criminale TA505, che nel settembre 2020 ha lanciato una campagna malware sfruttando una vulnerabilità appena scoperta, riuscendo a compromettere un sistema in soli sette minuti, nonostante le misure di sicurezza. Attacchi come il worm Stuxnet, sviluppato per sabotare il programma nucleare iraniano, dimostrano come gli exploit (anche “0-day”, ovvero sconosciuti ai vendor) possano essere utilizzati per colpire infrastrutture critiche e causare danni fisici significativi. L’exploit EternalBlue, ad esempio, è stato “weaponizzato” nei famigerati attacchi WannaCry e NotPetya, causando danni globali senza precedenti.

| Tipo di Attacco Bot Potenziato dall’IA | Meccanismi/Tecniche Comuni | Esempi Concreti/Casi Studio | Impatto/Conseguenze |

| Evasione del Rilevamento | Proxy residenziali, Botnet (Tor, fast-flux), Malware polimorfico, IA generativa per eludere sistemi di sicurezza | Attacchi DDoS con migliaia di IP residenziali; Botnet che cambiano IP frequentemente; Malware che muta codice | Difficoltà estrema nel rilevamento; Falsi positivi (blocco utenti legittimi); Inefficacia di WAF tradizionali |

| Sfruttamento API | Credential stuffing, Scraping dati, Frodi (es. cart abandonment) | Credential stuffing su endpoint di login API; Bot che aggiungono articoli al carrello senza acquistare | Furto di dati; Frodi economiche; Disfunzioni nei servizi digitali; Perdite di vendite |

| Account Takeover (ATO) | Password spraying, Brute force, Phishing AI-generato, Malware | Attacchi di phishing sofisticati che portano al furto di credenziali; Credential stuffing su larga scala | Truffe finanziarie; Furto di identità; Esfiltrazione dati sensibili; Danno reputazionale |

| Disinformazione/Manipolazione | IA generativa per contenuti falsi (testo, immagini, deepfake), Malvertising | Testi e messaggi di phishing indistinguibili; Annunci malevoli che reindirizzano a siti compromessi | Erosione della fiducia; Distorsione della percezione della realtà; Perdite finanziarie; Manipolazione dell’opinione pubblica |

| Sfruttamento Vulnerabilità | Vulnerabilità 0-day e N-day, Exploit kit | Attacchi TA505 (sfruttamento in minuti); Worm Stuxnet; WannaCry/NotPetya (EternalBlue) | Compromissione sistemi critici; Danni fisici; Violazioni di dati su larga scala |

Questa tabella offre una panoramica strutturata delle diverse e complesse tattiche di attacco.

La statistica che il “44% del traffico bot avanzato prende di mira le API” e l’affermazione che “i servizi digitali moderni si basano sulle API” evidenziano una vulnerabilità sistemica critica. Le API sono il sistema nervoso centrale dell’economia digitale, facilitando la comunicazione e l’interoperabilità tra applicazioni e servizi. La loro onnipresenza le rende un punto di attacco estremamente attraente. La compromissione di una singola API può avere ripercussioni a cascata su più sistemi interconnessi, non solo quelli direttamente bersagliati. Questo significa che la sicurezza delle API non è più un componente secondario della cybersecurity, ma un elemento fondante della resilienza complessiva di un’organizzazione. Questa è una vulnerabilità della supply chain nel regno digitale.

Gli attacchi di Account Takeover (ATO), spesso facilitati dai bot , minano direttamente il concetto stesso di identità digitale. Se l’81% dei data breach è legato a credenziali trafugate o deboli e i bot possono automatizzare il “credential stuffing” , allora la fiducia fondamentale nella propria persona online è costantemente sotto minaccia. Questo non riguarda solo la perdita finanziaria o il furto di dati; ha un impatto psicologico profondo sulla perdita di controllo del proprio sé digitale, influenzando la reputazione, la privacy e la sicurezza personale. L’implicazione è la necessità urgente di una ridefinizione e di un rafforzamento delle strategie di sicurezza dell’identità digitale, andando oltre le semplici password e abbracciando soluzioni come l’autenticazione multi-fattore (MFA) e la biometria comportamentale.

4. L’Umanesimo Digitale Sotto Attacco: Oltre la Sicurezza, la Fiducia

L’ascesa dei bot malevoli, soprattutto quelli potenziati dall’IA generativa, minaccia l’integrità stessa delle informazioni online. La diffusione rapidissima e virale di “fake” via social media può far perdere traccia della sorgente delle informazioni manipolate. L’IA generativa può produrre testi e immagini che imitano la realtà, rendendo difficile distinguere il vero dal falso.

Questo crea un ambiente dove la “malinformation” (informazioni vere usate per scopi dannosi attraverso frame deformati) può essere strumentalizzata in contesti geopolitici e di conflitto. Se la nostra “agorà digitale” è inquinata da informazioni non autentiche, come possiamo prendere decisioni informate come cittadini o consumatori? La percezione della realtà stessa viene distorta, con gravi implicazioni per la democrazia e la coesione sociale.

Questa è una profonda sfida epistemologica: come conosciamo la verità nell’era dei bot. Se i bot possono generare contenuti realistici e diffondere disinformazione viralmente , la base stessa di come acquisiamo conoscenza e discerniamo la verità online è messa in discussione. Non si tratta solo di “fake news”, ma di un’erosione sistemica delle fonti di informazione affidabili. Per un umanista digitale, ciò solleva questioni epistemologiche profonde: cosa costituisce la prova? Come verifichiamo le affermazioni? Come educhiamo i cittadini a navigare in una realtà sempre più plasmata dalla manipolazione algoritmica? Questo richiede un passaggio dal semplice consumo di informazioni alla valutazione critica della loro origine e intenzione.

La crescente presenza di bot solleva una questione fondamentale: con chi o cosa stiamo interagendo online? I “chatterbot dannosi” possono fingere di essere persone per ottenere informazioni personali. Sebbene gli agenti conversazionali benigni migliorino l’esperienza utente e riducano i costi operativi , a loro controparte malevola erode la fiducia nelle interazioni digitali. La capacità di distinguere l’umano dalla macchina diventa cruciale. Se non possiamo fidarci dell’autenticità delle interazioni, la “fiducia digitale” crolla. Questo impatta non solo le transazioni commerciali, ma anche le relazioni personali e la formazione della conoscenza. L’eccessiva dipendenza dai sistemi di IA senza supervisione umana può portare a “fiducia cieca” e conseguenze indesiderate.

L’IA e i bot sollevano profonde questioni etiche. I sistemi di IA possono perpetuare e amplificare bias presenti nei dati di addestramento, portando a discriminazioni. L’esempio di Compas, che etichettava gli afroamericani con una probabilità del 77% maggiore di recidiva rispetto ai bianchi , mostra come l’IA possa avere un impatto sociale negativo se non gestita eticamente. L’IA può minacciare la privacy in modi che “George Orwell non avrebbe potuto immaginare”.

La raccolta e l’analisi dei dati personali da parte dei bot e dei sistemi IA solleva preoccupazioni sulla sorveglianza e l’uso improprio delle informazioni. Inoltre, l’IA può essere usata per manipolare il pensiero e la percezione , minando l’autonomia decisionale degli individui. La necessità di un “umano nel loop” è cruciale per garantire che le decisioni critiche non siano interamente delegate a sistemi automatizzati, specialmente in ambiti come la medicina o la giustizia. È fondamentale che i sistemi di IA siano trasparenti e spiegabili , in modo che le loro decisioni possano essere comprese e valutate. L’EU AI Act, ad esempio, richiede che i sistemi di IA che interagiscono con le persone informino gli utenti della loro natura non umana. La responsabilità morale dell’IA è un tema centrale.

L’enfasi ripetuta su “bias e discriminazione” , “privacy e sorveglianza” e “manipolazione delle informazioni” rivela che le implicazioni etiche dell’IA non sono preoccupazioni secondarie, ma centrali per la sostenibilità della nostra società digitale. Senza robusti quadri etici e regolamentazioni , i bot potenziati dall’IA rischiano di creare un ambiente digitale discriminatorio, invadente e manipolativo. Il concetto di “Umanesimo Digitale” diventa non solo un ideale accademico, ma una necessità pratica per garantire che la tecnologia serva l’umanità, piuttosto che sovvertirla. La richiesta di un “umano nel loop” è una risposta diretta a questo imperativo etico.

Data la complessità delle minacce guidate dall’IA e delle loro implicazioni etiche, l’alfabetizzazione digitale tradizionale è insufficiente. È necessario “imparare a capire, parlandoci, quando uno studente ha scritto il suo paper, quando se lo è fatto scrivere da [IA]”. Questo implica una comprensione più profonda delle capacità dell’IA, dei suoi limiti e dei suoi confini etici. Programmi come il Master in “Filosofia del digitale e intelligenza artificiale” stanno emergendo per affrontare questa lacuna, evidenziando il crescente riconoscimento che le prospettive filosofiche ed etiche sono essenziali per navigare nell’era digitale. Questa è una chiamata a un approccio più critico e centrato sull’uomo all’educazione tecnologica.

5. Difendersi dall’Invisibile: Un Appello all’Azione Consapevole

Imperva e Thales raccomandano un approccio multi-strato per difendersi dai bot malevoli. La

Advanced Bot Protection include soluzioni specializzate che vanno oltre i WAF tradizionali, utilizzando l’apprendimento automatico e l’IA per rilevare e mitigare i bot sofisticati che mimano il comportamento umano.7 Queste soluzioni analizzano pattern di comportamento, impronte digitali dei dispositivi e intelligenza collettiva sui bot. La

API Security prevede una protezione specifica per le API, che include autenticazione e autorizzazione robuste (OAuth 2.0, OpenID Connect), regole specifiche per le API, rilevamento delle anomalie in tempo reale e crittografia end-to-end. Per la

Account Takeover Protection, le misure includono l’autenticazione multi-fattore (MFA) , il monitoraggio delle attività degli account e la profilazione degli utenti , la geolocalizzazione IP e il device fingerprinting. L’IA è cruciale qui, analizzando i modelli di comportamento dell’utente (digitazione, movimenti del mouse) per rilevare anomalie difficili da imitare.

Web Application Firewall (WAF) è essenziale per filtrare il traffico HTTP/HTTPS e mitigare minacce come SQL injection e XSS. Tuttavia, i WAF tradizionali non sono sufficienti contro i bot avanzati che evadono le regole statiche. Un WAF avanzato integrato con analisi comportamentale e threat intelligence è necessario. Infine, l’

MFA e la Difesa AI-driven: l’MFA è una difesa fondamentale, ma gli attaccanti stanno sviluppando tecniche per aggirarla, spesso usando l’IA generativa per schemi di phishing più convincenti. Le soluzioni di Network Detection and Response (NDR) basate sull’IA e sul Machine Learning possono rilevare schemi minacciosi e prevenire accessi non autorizzati anche con credenziali rubate.

La sicurezza digitale non è solo una questione tecnologica, ma un problema sistemico che richiede un “approccio olistico”. Questo significa integrare tecnologia avanzata (implementando soluzioni AI-driven per la prevenzione e il rilevamento), etica e governance (stabilendo principi etici, trasparenza e responsabilità nell’uso dell’IA , con la protezione dei dati guidata da etica, riservatezza e sicurezza ), consapevolezza umana (formazione degli utenti sui metodi di attacco comuni e sulle migliori pratiche di sicurezza , poiché il fattore umano rimane fondamentale ), e collaborazione (abbattendo i “silo tradizionali” all’interno delle organizzazioni e collaborando con partner e fornitori per gestire le vulnerabilità della supply chain ).

Le soluzioni tecniche, pur essendo avanzate, non sono sufficienti da sole. I WAF tradizionali falliscono contro i bot avanzati 7, e persino l’MFA può essere aggirata con phishing basato sull’IA.30 Questo indica che le soluzioni puramente tecniche sono insufficienti. La richiesta di un “approccio olistico” 19 che includa “formazione degli utenti e sensibilizzazione alla sicurezza” 10 e riconosca che “l’apporto umano rimane fondamentale” 19 rivela che la cyber-resilienza non riguarda solo la tecnologia, ma un cambiamento culturale nel modo in cui individui e organizzazioni percepiscono e interagiscono con il mondo digitale. Si tratta di costruire un firewall umano attraverso l’educazione e la consapevolezza etica.

La richiesta dell’EU AI Act per i sistemi IA di informare gli utenti della loro natura non umana e l’appello generale a “trasparenza e principi etici” affrontano direttamente la “de-umanizzazione” e la “crisi di verificabilità” identificate in precedenza. Se non possiamo distinguere l’umano dal bot, la fiducia si erode. La trasparenza nel funzionamento dell’IA, nell’addestramento dei dati e nel processo decisionale non è solo un ideale etico, ma un meccanismo di difesa pratico. Permette una migliore verifica, l’identificazione dei bias e, in ultima analisi, una maggiore fiducia e responsabilità, essenziali per un ecosistema digitale sano.

Conclusioni

L’epidemia dei bad bot, amplificata dall’Intelligenza Artificiale, non è un problema che riguarda solo le aziende o gli esperti di sicurezza; riguarda ogni utente connesso. La crescente predominanza di entità non umane nel traffico online, la sofisticazione delle loro tattiche di evasione, l’assalto alle API e la fragilità dell’identità digitale sono segnali inequivocabili di una trasformazione profonda del cyberspazio.

Come umanisti digitali, siamo chiamati non solo a comprendere queste trasformazioni, ma a plasmarle attivamente. La battaglia contro l’ombra digitale si vince con la consapevolezza, l’educazione e un impegno collettivo per un cyberspazio che sia, prima di tutto, umano. Dobbiamo esercitare i nostri diritti, rimanere vigili sulla nostra “impronta digitale” e promuovere un approccio olistico alla sicurezza che integri tecnologia avanzata, etica rigorosa, consapevolezza umana e collaborazione intersettoriale. Solo così potremo sperare di costruire un futuro digitale in cui la fiducia e l’autenticità non siano mere reliquie di un’era passata, ma pilastri fondamentali di una società connessa e resiliente.

Da informatico a cercatore di senso