Parte I: Le Fondamenta – L’Arte e la Scienza del Prompt Engineering

1.1 Definire il Prompt: L’Interfaccia Primaria per i Modelli Linguistici di Grandi Dimensioni (LLM)

Il prompt engineering è, quindi, l’arte e la scienza di progettare e ottimizzare questi prompt per guidare i modelli di IA verso la generazione di risposte pertinenti e di alta qualità. Si tratta di un processo di strutturazione delle istruzioni in modo tale che il modello possa comprendere l’intento dell’utente, seguire le direttive e produrre l’output atteso. L’analogia con un set di mattoncini Lego è particolarmente calzante: utilizzare un LLM senza un’adeguata ingegneria del prompt è come costruire senza istruzioni. Si potrebbe creare qualcosa di interessante per caso, ma mancherebbero due fattori cruciali: il controllo e la prevedibilità. Sebbene l’esplorazione libera possa essere utile per il brainstorming o per generare idee inaspettate, non è un metodo affidabile per ottenere risultati specifici e coerenti. Il prompt engineering, al contrario, introduce un livello di rigore e intenzionalità, trasformando un’interazione potenzialmente casuale in un processo mirato e controllato.

1.2 Tecniche e Metodologie Fondamentali

Il “prompt engineering” non è semplicemente una questione di formulazione di domande, ma una disciplina che si avvale di tecniche sistematiche per affinare l’interazione con gli LLM. Queste metodologie rappresentano l’aspetto “ingegneristico” della pratica, un approccio strutturato, sebbene spesso sperimentale, per gestire un sistema intrinsecamente non deterministico. Le tecniche principali includono:

- Prompting Zero-Shot: Questa è la forma più semplice di interazione, in cui al modello viene assegnato un compito senza fornirgli alcun esempio esplicito di come eseguirlo. L’LLM si basa esclusivamente sulla sua vasta conoscenza pre-addestrata per interpretare e rispondere alla richiesta. Un esempio classico è un comando diretto come “Riassumi questo documento” o “Traduci questo testo in francese”. L’efficacia di questa tecnica dipende dalla capacità del modello di generalizzare le sue conoscenze a compiti nuovi e non visti.

- Prompting Few-Shot: Per compiti più complessi o che richiedono un formato di output specifico, la tecnica few-shot si rivela più efficace. Questo metodo prevede di fornire al modello alcuni esempi (da uno a pochi) di coppie input-output desiderate prima di presentare la richiesta finale. Ad esempio, per estrarre informazioni specifiche da un testo, si potrebbero fornire due o tre esempi di testo e l’estrazione corretta. Questi esempi fungono da guida, “insegnando” al modello il formato, lo stile e il tipo di informazione richiesta, migliorando significativamente la pertinenza e l’accuratezza della risposta finale.

- Prompting Chain-of-Thought (CoT): Questa tecnica avanzata migliora le capacità di ragionamento degli LLM scomponendo un problema complesso in una serie di passaggi intermedi. Invece di chiedere direttamente la risposta finale, il prompt guida il modello a “pensare ad alta voce”, esplicitando i passaggi logici necessari per arrivare alla soluzione. Ad esempio, di fronte a un problema matematico, un prompt CoT potrebbe essere: “Prima, identifica le variabili note. Secondo, scrivi l’equazione necessaria. Terzo, sostituisci i valori e risolvi l’equazione”. Questo processo non solo aumenta la probabilità di ottenere una risposta corretta, ma rende anche il ragionamento del modello più trasparente e interpretabile.

- Prompting Guidato da Persona: Per controllare il tono, lo stile e il punto di vista della risposta, è possibile istruire l’IA ad adottare una “persona” o un ruolo specifico. Questo viene fatto attraverso un’istruzione esplicita all’inizio del prompt, come “Sei un assistente virtuale amichevole che aiuta gli utenti a risolvere problemi con il computer” o “Rispondi come un esperto di finanza che si rivolge a un principiante”. Questa tecnica è fondamentale per applicazioni come i chatbot del servizio clienti o i generatori di contenuti, dove la coerenza del “brand voice” è essenziale.

Queste tecniche, utilizzate singolarmente o in combinazione, costituiscono il toolkit del prompt engineer. Il processo è spesso iterativo: si parte da un prompt iniziale, si valuta l’output e si affina l’istruzione fino a raggiungere il risultato desiderato, un ciclo di feedback che è al centro della disciplina.

1.3 La Proposta di Valore Iniziale: Sbloccare le Capacità Latenti

L’importanza del prompt engineering, soprattutto nelle prime fasi di adozione degli LLM, non può essere sottovalutata. La sua proposta di valore iniziale risiedeva nella capacità di trasformare una tecnologia potente ma grezza in uno strumento pratico e utilizzabile. Gli LLM, nella loro essenza, sono modelli probabilistici che predicono la sequenza di parole più probabile; non sono motori di verità o sistemi dotati di un’intrinseca comprensione degli obiettivi umani. Di conseguenza, i loro output grezzi possono essere generici, irrilevanti o non strutturati.

Il prompt engineering ha fornito la soluzione a questo problema. Attraverso prompt ben congegnati, gli sviluppatori hanno ottenuto un maggiore controllo sulle interazioni con l’IA, garantendo che le risposte fossero non solo pertinenti ma anche presentate in un formato conciso e utilizzabile. Questo ha migliorato drasticamente l’esperienza dell’utente, riducendo la necessità di tentativi ed errori e fornendo risultati coerenti fin dalla prima richiesta. Inoltre, un’ingegneria dei prompt efficace ha permesso di ridurre significativamente lo sforzo di revisione e modifica post-generazione, un passaggio che altrimenti sarebbe stato dispendioso in termini di tempo e risorse umane. Infine, ha offerto un meccanismo per prevenire l’uso improprio dell’IA, limitando la generazione di contenuti inappropriati o al di fuori dell’ambito previsto per l’applicazione.

Andando oltre i benefici immediati, il prompt engineering ha agito come un ponte concettuale indispensabile. Ha colmato il divario tra la natura probabilistica e basata su pattern degli LLM e le esigenze deterministiche e orientate agli obiettivi delle applicazioni software e degli utenti finali. Un LLM, da solo, genera testo statisticamente plausibile. Un’applicazione aziendale, invece, richiede un output specifico, affidabile e formattato per essere utile. Il prompt engineering ha fornito l’impalcatura — le regole, gli esempi, i vincoli e la persona — che ha costretto la generazione probabilistica del modello a conformarsi a un risultato strutturato e desiderato. In questo senso, il suo valore iniziale non è stato solo quello di ottenere risposte migliori, ma di rendere una tecnologia rivoluzionaria effettivamente utilizzabile per compiti pratici, trasformandola da una curiosità accademica a uno strumento di produttività.

Parte II: Il Punto di Svolta – I Limiti Intrinseci di un Mondo Centrato sul Prompt

Nonostante il suo ruolo fondamentale nell’abilitare le prime applicazioni di IA generativa, l’approccio centrato esclusivamente sul prompt engineering ha presto rivelato i suoi limiti strutturali. Man mano che le ambizioni per i sistemi di IA sono cresciute, passando da semplici generatori di testo a complesse applicazioni aziendali, le crepe nel paradigma del “prompt perfetto” sono diventate evidenti. Questi limiti non sono semplici inconvenienti, ma indicazioni di una fondamentale inadeguatezza architettonica che ha reso necessario un passaggio a un approccio più sistemico.

2.1 La Scalabilità e la Fragilità dei Prompt Artigianali

Uno dei problemi più significativi del prompt engineering è la sua intrinseca fragilità e la mancanza di scalabilità. La creazione di un prompt efficace è spesso un processo di “tentativi ed errori”, un’arte empirica che può essere dispendiosa in termini di tempo e frustrante. Quello che funziona per un modello o una versione specifica potrebbe non funzionare per la successiva. Sottili variazioni nella formulazione di un prompt possono portare a output drasticamente diversi, rendendo i risultati imprevedibili. Questa natura non deterministica è in diretto conflitto con i principi fondamentali dell’ingegneria del software, che richiedono prevedibilità, ripetibilità e stabilità.

Questa fragilità rende estremamente difficile costruire pipeline software robuste basate su prompt artigianali. Un sistema che si basa su una serie di istruzioni testuali finemente calibrate è destinato a rompersi non appena le condizioni cambiano: un aggiornamento del modello sottostante, un nuovo tipo di input dell’utente o un aumento della complessità del compito possono invalidare l’intero sistema. L’approccio del “prompt hacking” o del “vibe coding” — l’arte di trovare la giusta combinazione di parole per ottenere il risultato desiderato in un dato momento — non è scalabile all’interno di team di sviluppo o per prodotti destinati a un vasto pubblico. In un ambiente di produzione, dove l’affidabilità è fondamentale, un componente così imprevedibile rappresenta una passività inaccettabile.

2.2 Il Vincolo della Finestra di Contesto e il “Knowledge Cutoff”

Oltre alla fragilità, il prompt engineering si scontra con due limiti tecnici fondamentali degli LLM: la dimensione finita della finestra di contesto e la natura statica della loro conoscenza.

Ogni LLM ha una “finestra di contesto”, ovvero una quantità massima di testo (misurata in token) che può elaborare in una singola interazione. Questo pone un limite rigido alla quantità di informazioni che possono essere fornite in un prompt, rendendo difficile per il modello gestire lunghe conversazioni o analizzare documenti di grandi dimensioni. La seconda limitazione, forse ancora più critica, è il “knowledge cutoff”: la conoscenza di un LLM è congelata al momento del suo addestramento. Non ha accesso a eventi, dati o informazioni che si sono verificati dopo quella data. Questo porta inevitabilmente a risposte obsolete o, peggio, a “allucinazioni”, ovvero la generazione di informazioni plausibili ma fattualmente errate o completamente inventate.

Il prompt engineering da solo non può risolvere questi problemi. La soluzione più ovvia, ovvero “riempire” il prompt con quante più informazioni di contesto possibili (“prompt stuffing”), si rivela controproducente. Fornire troppe informazioni in un singolo prompt può sopraffare il modello, portandolo a ignorare dettagli cruciali o a confondersi su quali istruzioni dare la priorità. Inoltre, questo approccio si scontra rapidamente con i limiti della finestra di contesto. Questo fallimento espone un difetto architettonico fondamentale nell’approccio “prompt-only”. I problemi principali — la mancanza di conoscenza aggiornata e l’incapacità di elaborare grandi volumi di dati — non possono essere risolti semplicemente migliorando l’istruzione. L’errore non risiede nel

prompt, ma nell’architettura stessa, che tratta l’LLM come un “cervello” autonomo da interrogare abilmente. Diventa chiaro che è necessario un nuovo approccio, uno che non si basi su una singola istruzione statica, ma su un sistema dinamico che gestisce il flusso di informazioni prima che queste raggiungano l’LLM. Questa presa di coscienza rappresenta il salto concettuale che porta al context engineering.

2.3 La Democratizzazione e la Mercificazione del Prompting

Infine, il valore del prompt engineering come disciplina specialistica ha iniziato a diminuire a causa della sua stessa accessibilità. Le tecniche e le strategie che una volta sembravano un’arte oscura sono state rapidamente democratizzate e mercificate. I template di prompt per una vasta gamma di compiti sono diventati onnipresenti e open-source, riducendo la necessità di crearli da zero. Molte applicazioni moderne hanno iniziato ad astrarre completamente il livello del prompt, nascondendolo dietro interfacce utente intuitive con pulsanti, menu a tendina e slider, dove l’utente finale non è nemmeno consapevole di stare, di fatto, “ingegnerizzando” un prompt.

La barriera all’ingresso per il prompt engineering di base è estremamente bassa; chiunque abbia una buona padronanza della lingua può iniziare a ottenere risultati decenti con un po’ di pratica. Questo rende difficile costruire una carriera difendibile basata esclusivamente su questa abilità. Alcuni esperti prevedono addirittura che i modelli di IA diventeranno così sofisticati da essere in grado di scrivere e ottimizzare i propri prompt, rendendo la competenza umana in questo campo ancora meno critica. Di conseguenza, il mercato del lavoro si è evoluto. I ruoli di “Prompt Engineer” sono in gran parte scomparsi, assorbiti da titoli più robusti e olistici come “AI Engineer”, “LLM Developer” o “Applied Researcher”. In questi ruoli, il prompting è solo una delle tante competenze in un toolkit molto più ampio che include l’architettura dei sistemi, la gestione dei dati e l’integrazione di API. Questa evoluzione segnala che l’industria ha riconosciuto i limiti di un approccio incentrato sul prompt e si sta muovendo verso la costruzione di sistemi di IA più complessi e integrati.

Parte III: Il Nuovo Paradigma – L’Ascesa del Context Engineering

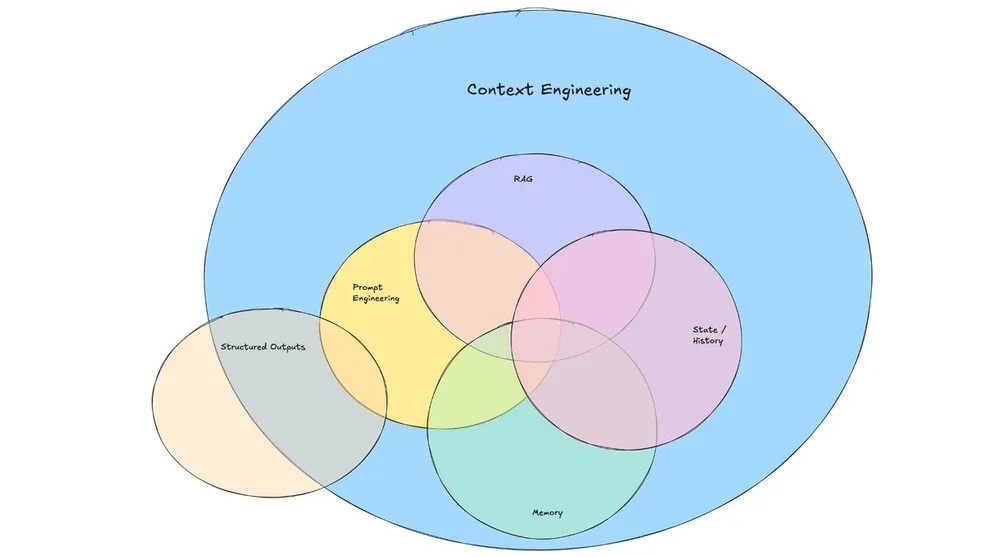

Di fronte ai limiti intrinseci del prompt engineering, è emerso un nuovo paradigma, più robusto, scalabile e allineato ai principi dell’ingegneria del software: il context engineering. Questa disciplina rappresenta un cambiamento fondamentale nel modo in cui concepiamo e costruiamo applicazioni basate su LLM. Non si tratta più di perfezionare una singola istruzione, ma di progettare l’intero ecosistema informativo in cui opera il modello.

3.1 Definire il Context Engineering: Progettare l’Ambiente Informativo

Il context engineering è la disciplina sistematica che si occupa di progettare sistemi, flussi di lavoro e architetture che decidono quali informazioni un modello di IA vede prima di generare una risposta. L’obiettivo non è più solo creare un buon prompt, ma costruire l’intero

ambiente informativo per garantire che il modello possa gestire in modo intelligente e personalizzato qualsiasi richiesta gli venga sottoposta.

Il cambiamento chiave è il passaggio da un’istruzione statica a un “pacchetto informativo” dinamico. Questo pacchetto viene assemblato al momento della richiesta, attingendo da molteplici fonti: la cronologia della conversazione, i database degli utenti, documenti esterni, API, feed di dati in tempo reale e strumenti disponibili. Se il prompt engineering è come dare a qualcuno indicazioni stradali per una destinazione, il context engineering è come essere il suo sistema GPS personale: un sistema che si aggiorna costantemente con informazioni sul traffico in tempo reale, condizioni stradali, preferenze personali e percorsi alternativi. L’attenzione si sposta da

cosa dire al modello in un dato momento a cosa il modello sa quando glielo si dice. Invece di affidarsi a un prompt statico, il context engineering crea “pacchetti di informazioni” adattivi che cambiano in base al compito specifico, alla storia dell’utente e alla situazione attuale, garantendo che ogni interazione con l’IA sia informata dal contesto più pertinente e aggiornato possibile.

3.2 Un’Analisi Comparativa: Dalla Creazione di Testi alla Progettazione di Sistemi

La transizione dal prompt engineering al context engineering segna un’evoluzione dalla micro-gestione di singole interazioni alla macro-progettazione di sistemi intelligenti. Il prompt engineering si concentra sulla creazione di un’istruzione specifica per ottenere una risposta una tantum. Il context engineering, al contrario, si occupa di progettare l’intero flusso e l’architettura per garantire prestazioni coerenti e scalabili attraverso molteplici utenti e sessioni. La mentalità cambia: da quella di un copywriter o di uno scrittore creativo, che affina le parole per ottenere l’impatto perfetto, a quella di un architetto del software o di un progettista di sistemi, che orchestra componenti complessi per costruire un’applicazione affidabile.

È fondamentale comprendere che il prompt engineering non viene sostituito, ma piuttosto assorbito da una disciplina più ampia: il prompt engineering è un sottoinsieme del context engineering. Un prompt ben scritto rimane una componente necessaria, ma la sua efficacia è ora determinata dalla qualità dell’ambiente di contesto in cui viene inserito. Un’istruzione brillante sepolta sotto migliaia di token di cronologia di chat irrilevante o documenti mal formattati sarà inefficace. Il context engineering garantisce che il prompt sia supportato e valorizzato da un contesto pulito, pertinente e ottimizzato.

La tabella seguente sintetizza le differenze chiave tra i due approcci, evidenziando la maturazione del campo verso pratiche ingegneristiche più rigorose.

| Dimensione | Prompt Engineering | Context Engineering |

| Obiettivo Principale | Ottenere una risposta specifica e una tantum da un prompt. | Costruire un sistema affidabile e scalabile che funzioni in modo coerente. |

| Ambito di Applicazione | Una singola coppia input-output. | L’intero ambiente informativo: memoria, strumenti, dati, cronologia. |

| Mentalità | Scrittura creativa, affinamento delle parole (“wordsmithing”). | Progettazione di sistemi, architettura del software per LLM. |

| Strumenti Chiave | Editor di testo, interfacce di chat (es. ChatGPT). | Database vettoriali, sistemi RAG, framework API, moduli di memoria. |

| Scalabilità | Bassa; i prompt sono fragili e si rompono con l’aumentare della complessità. | Alta; l’architettura è progettata fin dall’inizio per l’uso in produzione. |

| Debugging | Riformulare il prompt, fare congetture su cosa è andato storto. | Ispezionare l’intera finestra di contesto, il flusso di dati, le chiamate API. |

| Analogia | Scrivere una lettera perfetta. | Gestire un’intera famiglia (bilanciare budget, orari, imprevisti). |

Questa analisi comparativa chiarisce che il passaggio non è solo una questione di terminologia, ma un profondo cambiamento di prospettiva. Il focus si sposta dal singolo “atto comunicativo” (il prompt) alla progettazione dell’intero “sistema cognitivo” dell’applicazione, che include tutto ciò che il modello deve sapere per agire in modo efficace e intelligente nel suo dominio specifico.

Parte IV: I Pilastri Architettonici del Context Engineering

Il context engineering non è un concetto astratto, ma un insieme di pratiche architettoniche concrete. Si basa su tre pilastri tecnici fondamentali che, lavorando in sinergia, creano un ambiente informativo ricco e dinamico per l’LLM. Questi pilastri affrontano direttamente i limiti del prompt engineering, fornendo al modello conoscenza aggiornata, memoria persistente e la capacità di agire nel mondo reale.

4.1 Pilastro I – Ancoraggio alla Realtà con la Retrieval-Augmented Generation (RAG)

La Retrieval-Augmented Generation (RAG) è un framework di intelligenza artificiale che risolve direttamente i problemi del “knowledge cutoff” e delle allucinazioni. Funziona collegando un LLM a basi di conoscenza esterne, come database aziendali, documentazione tecnica o fonti di dati aggiornate. Questo processo trasforma l’LLM da un sistema a “libro chiuso”, che si basa solo sulla sua memoria statica, a un sistema a “libro aperto”, che può consultare fonti esterne prima di rispondere.

Il meccanismo della RAG si articola in tre fasi principali:

- Indicizzazione (Indexing): I dati esterni (siano essi documenti PDF, record di un database o pagine web) vengono pre-elaborati. Vengono suddivisi in blocchi di testo più piccoli (“chunks”), trasformati in rappresentazioni numeriche chiamate “embeddings” attraverso un modello di linguaggio, e infine memorizzati in un database specializzato chiamato “vector database”. Questo processo crea una libreria di conoscenza ricercabile semanticamente.

- Recupero (Retrieval): Quando un utente pone una domanda, il sistema non la invia immediatamente all’LLM. Invece, la domanda viene anch’essa trasformata in un embedding e utilizzata per interrogare il vector database. Il database restituisce i “chunks” di informazione i cui embedding sono semanticamente più simili a quello della domanda. In questo modo, il sistema recupera i frammenti di conoscenza più pertinenti per rispondere.

- Aumento (Augmentation): I frammenti di testo recuperati vengono quindi inseriti dinamicamente nel prompt, insieme alla domanda originale dell’utente. Questo “prompt aumentato” viene infine inviato all’LLM, che ora ha a disposizione un contesto fattuale, specifico e aggiornato su cui basare la sua generazione.

Il valore strategico della RAG è immenso. Permette alle applicazioni di IA di utilizzare dati proprietari, specifici di un dominio o semplicemente troppo recenti per essere inclusi nel training del modello, il tutto senza i costi proibitivi del ri-addestramento o del fine-tuning. Inoltre, poiché le risposte sono ancorate a documenti specifici, è possibile citare le fonti, rendendo l’output dell’LLM verificabile e aumentando la fiducia dell’utente nel sistema.

4.2 Pilastro II – Mantenere lo Stato con la Memoria Conversazionale

Per impostazione predefinita, gli LLM sono “stateless”, ovvero privi di stato: ogni richiesta viene elaborata in modo indipendente, senza alcun ricordo delle interazioni precedenti. Questo è un limite enorme per qualsiasi applicazione che richieda un dialogo coerente, come un chatbot. La memoria conversazionale è il meccanismo che permette a un’applicazione di IA di ricordare il contesto di una conversazione, creando un’esperienza fluida e simile a quella umana.

Esistono diverse strategie per implementare la memoria, ognuna con i propri compromessi:

- Buffer Memory: La forma più semplice, che consiste nel memorizzare l’intera cronologia della conversazione e includerla in ogni nuovo prompt. Sebbene fornisca all’LLM il massimo contesto possibile, questo approccio è inefficiente: consuma rapidamente la finestra di contesto, aumenta i costi di inferenza e rallenta i tempi di risposta.

- Window Memory: Una variante più pragmatica che memorizza solo le ultime

kinterazioni. Questo mantiene il contesto immediato, è efficiente in termini di token e costi, ma perde la memoria a lungo termine. Il bot “dimenticherà” ciò che è stato detto all’inizio di una lunga conversazione. - Summary Memory: Un approccio più sofisticato che utilizza un LLM per riassumere progressivamente la conversazione. Invece di conservare la trascrizione completa, si mantiene un riassunto in evoluzione. Questo permette di preservare il contesto a lungo termine anche in conversazioni molto lunghe, ma introduce una latenza aggiuntiva, un costo per la generazione del riassunto e il rischio di perdere dettagli importanti nel processo di sintesi.

- Approcci Ibridi (es. Summary Buffer Memory): Queste strategie cercano di combinare i vantaggi dei metodi precedenti. Ad esempio, si possono mantenere le ultime

kinterazioni in forma grezza (come nella Window Memory) e riassumere tutte le interazioni precedenti. Questo offre un buon equilibrio tra la conservazione dei dettagli recenti e il mantenimento del contesto a lungo termine.

Il valore strategico della memoria è evidente. È il pilastro che consente la personalizzazione, permettendo al sistema di ricordare le preferenze dell’utente, i problemi passati e i dettagli specifici menzionati in precedenza. Per applicazioni come il supporto clienti, dove un utente si aspetta che l’agente (umano o artificiale) ricordi il suo problema, la memoria conversazionale non è un’opzione, ma un requisito fondamentale.

4.3 Pilastro III – Abilitare l’Azione con l’Uso di Strumenti e l’Integrazione di API

L’ultimo pilastro trasforma l’LLM da un semplice generatore di testo a un agente attivo in grado di compiere azioni. L’uso di strumenti (noto anche come “function calling”) è il meccanismo che permette a un LLM di interagire con funzioni esterne e API. Questo estende le sue capacità oltre i confini della sua conoscenza pre-addestrata, consentendogli di accedere a dati in tempo reale, interagire con sistemi esterni e modificare lo stato del mondo.

Il processo di utilizzo degli strumenti si svolge in quattro passaggi orchestrati dall’applicazione:

- Definizione (Definition): Lo sviluppatore fornisce all’LLM una descrizione degli strumenti disponibili. Questa descrizione, solitamente in un formato strutturato come JSON Schema, include il nome della funzione, una spiegazione del suo scopo e i parametri che accetta. Ad esempio, si potrebbe definire uno strumento

get_weather(location)che recupera il meteo per una data città. - Decisione (Decision): Quando l’LLM riceve un prompt dall’utente (es. “Che tempo fa a Roma?”), analizza la richiesta. Se riconosce che uno degli strumenti a sua disposizione può aiutare a rispondere, invece di inventare una risposta, genera un output speciale. Questo output non è una frase in linguaggio naturale, ma un oggetto JSON strutturato che indica l’intenzione di chiamare uno strumento specifico e fornisce gli argomenti necessari (es.

{ "name": "get_weather", "arguments": { "location": "Roma" } }). - Esecuzione (Execution): L’applicazione che gestisce l’LLM intercetta questo output JSON. È importante notare che l’LLM non esegue mai direttamente la funzione. È l’applicazione stessa che interpreta la richiesta, chiama la funzione o l’API reale (es. un’API meteorologica) con gli argomenti forniti e ne riceve il risultato (es. “25°C, soleggiato”).

- Generazione della Risposta (Response Generation): Infine, l’applicazione invia un nuovo prompt all’LLM, includendo il risultato dell’esecuzione dello strumento. L’LLM utilizza questa nuova informazione per formulare una risposta finale e coerente in linguaggio naturale per l’utente (es. “A Roma ci sono 25°C ed è soleggiato.”).

Il valore strategico dell’uso di strumenti è trasformativo. Permette all’LLM di superare i suoi limiti intrinseci, accedendo a informazioni in tempo reale (meteo, prezzi delle azioni), interagendo con sistemi aziendali proprietari (CRM, database di inventario) e compiendo azioni concrete (prenotare una riunione, inviare un’email, elaborare un rimborso). Questo pilastro è ciò che permette di costruire veri e propri agenti di IA, capaci non solo di conversare, ma di agire per conto dell’utente.

L’Ingegneria del Prompt è Morta.

Lunga Vita all’Ingegneria del Contesto.

Il modo in cui comunichiamo con l’intelligenza artificiale sta subendo una trasformazione radicale. Stiamo passando dal sussurrare istruzioni precise alla costruzione di interi universi digitali in cui l’AI può ragionare, agire e diventare un partner strategico.

L’Era dei Prompt: L’Arte della Domanda Perfetta

Il prompt engineering è stato il nostro primo passo: l’abilità di formulare una domanda per ottenere la risposta desiderata. Un’arte necessaria, ma che mostrava i suoi limiti. L’AI era un esecutore brillante ma privo di memoria, intrappolato nel momento presente.

delle interazioni iniziali con gli LLM si basava su prompt “single-shot”, senza memoria o dati esterni.

Le Sfide di un’AI Senza Contesto

Un’analisi dei principali ostacoli incontrati affidandosi esclusivamente al prompt engineering.

L’Alba del Contesto: Costruire l’Universo dell’AI

L’ingegneria del contesto non si concentra sulla singola domanda, ma sull’ecosistema informativo che la circonda. Forniamo all’AI tre pilastri fondamentali per trasformarla da calcolatrice di parole ad architetto di soluzioni.

Memoria

La capacità di ricordare le interazioni passate, garantendo coerenza e conversazioni fluide.

Conoscenza (RAG)

L’accesso a database esterni, documenti e API per “ancorare” le risposte a dati reali e aggiornati.

Strumenti (Agenti AI)

La facoltà di eseguire azioni concrete, come inviare email, interrogare sistemi o automatizzare workflow.

Modello LLM Potenziato

Il risultato è un’AI che non solo risponde, ma comprende, ragiona e agisce nel suo ambiente.

Impatto del RAG sull’Accuratezza

Confronto diretto della pertinenza delle risposte a una domanda su dati specifici e recenti (es. “Quali sono i dati di vendita del Q3?”).

Crescita della Complessità dei Task Automatizzati

L’introduzione di Agenti AI ha sbloccato la capacità di gestire workflow complessi, non solo semplici query.

Parte V: Sintetizzare il Sistema – Dai Prompt agli Agenti Intelligenti

I tre pilastri del context engineering — RAG, memoria e uso di strumenti — non operano in isolamento. È la loro orchestrazione sinergica che dà vita ad applicazioni di IA sofisticate e a quelli che oggi definiamo “agenti intelligenti”. La vera ingegneria risiede nel modo in cui questi componenti vengono assemblati dinamicamente per costruire, per ogni singola interazione, il contesto perfetto per l’LLM.

5.1 L’Anatomia della Finestra di Contesto di un’Applicazione Moderna

In un’applicazione moderna basata su LLM, ciò che viene inviato al modello è molto più della semplice domanda dell’utente. Il “meta-prompt” finale è un costrutto complesso, assemblato dinamicamente dall’applicazione che funge da orchestratore. Questo meta-prompt può essere composto da diversi elementi, ognuno con uno scopo preciso :

- System Prompt: Un’istruzione di alto livello che definisce la persona, il ruolo, le regole e il comportamento generale dell’IA (es. “Sei un assistente legale esperto. Sii conciso e cita sempre le fonti”).

- Cronologia Conversazionale (Memoria): Un riassunto o le trascrizioni delle interazioni recenti per mantenere la coerenza del dialogo.

- Documenti Recuperati (RAG): Frammenti di testo pertinenti estratti da una base di conoscenza esterna per ancorare la risposta a fatti specifici e aggiornati.

- Definizioni degli Strumenti (Tool Use): La descrizione delle API e delle funzioni che l’LLM può richiedere di utilizzare per compiere azioni o recuperare dati in tempo reale.

- Query dell’Utente: La domanda o il comando immediato dell’utente.

In molti casi, il contenuto statico (come il system prompt) può costituire solo una piccola parte del contesto totale. Si stima che il prompt finale possa essere composto per l’80% da contenuto dinamico (memoria, RAG, risultati di strumenti) e solo per il 20% da istruzioni statiche. Questo evidenzia un aspetto cruciale del context engineering: la gestione attenta della finestra di contesto. Poiché lo spazio dei token è una risorsa limitata e costosa, l’applicazione deve effettuare un “context budgeting”, allocando strategicamente lo spazio disponibile ai diversi tipi di informazione in base alle esigenze del compito specifico. L’arte sta nel riempire la finestra di contesto con la giusta combinazione di informazioni, nella giusta quantità e nel giusto formato, per massimizzare le possibilità che l’LLM produca l’output desiderato.

5.2 Applicazioni Reali in Primo Piano

L’efficacia di questo approccio orchestrato diventa evidente quando si analizzano applicazioni complesse del mondo reale, che sarebbero impossibili da realizzare con il solo prompt engineering.

- Supporto Clienti Avanzato: Un chatbot di supporto di nuova generazione non si limita a rispondere a domande frequenti. Quando un cliente avvia una chat, il sistema utilizza l’ID del cliente per recuperare la sua cronologia di acquisti e i ticket di supporto precedenti da un database (RAG). Mantiene un ricordo della conversazione in corso per evitare che il cliente debba ripetersi (Memoria). Se il cliente chiede “Dov’è il mio ultimo ordine?”, il sistema può chiamare un’API di tracciamento delle spedizioni per ottenere lo stato in tempo reale (Uso di Strumenti). Se il cliente desidera un rimborso, il bot può avviare il processo chiamando un’altra API interna, il tutto all’interno di un’unica conversazione fluida e contestualizzata.

- Assistenti di Codifica IA: Strumenti come GitHub Copilot o altri assistenti di codifica avanzati vanno ben oltre il semplice completamento del codice. Un assistente basato sul context engineering indicizza l’intera base di codice del progetto per comprendere le relazioni tra file e funzioni (RAG). Ricorda le modifiche recenti apportate dallo sviluppatore e il suo stile di codifica (Memoria). Può eseguire test, fare il refactoring di una funzione o persino interagire con un sistema di CI/CD chiamando gli script e le API appropriate (Uso di Strumenti). Questo livello di consapevolezza del contesto trasforma l’assistente da un semplice strumento di autocompletamento a un vero e proprio “pair programmer”.

- Consulenti Finanziari Personalizzati: Un sistema di consulenza finanziaria basato sul context engineering può fornire consigli altamente personalizzati e tempestivi. Integra dati di mercato in tempo reale e notizie finanziarie (RAG + Uso di Strumenti). Ricorda gli obiettivi finanziari a lungo termine, la tolleranza al rischio e le preferenze di investimento discusse dall’utente in conversazioni precedenti (Memoria). Può analizzare la performance attuale del portafoglio dell’utente collegandosi al suo account di brokeraggio tramite API (Uso di Strumenti) e generare raccomandazioni che tengono conto di tutti questi fattori contemporaneamente.

Questi esempi dimostrano in modo inequivocabile che le applicazioni di IA di alto valore non sono problemi di prompt engineering, ma problemi di context engineering.

5.3 L’Emergere dell’Agente di IA

La sintesi di questi tre pilastri porta alla creazione di un “agente di IA”. Un agente è più di un chatbot; è un sistema progettato per raggiungere obiettivi complessi e multi-passo. Il suo compito primario non è semplicemente rispondere a una domanda, ma raccogliere le informazioni giuste, estendere il contesto e utilizzare strumenti per portare a termine un compito.

Il context engineering è la disciplina che abilita l’IA agentica. La qualità di un agente non è determinata esclusivamente dalla potenza del modello LLM sottostante, ma in misura ancora maggiore dalla qualità dell’architettura di contesto che lo circonda. Un agente efficace deve essere in grado di:

- Percepire il suo ambiente: Attraverso la RAG e l’uso di strumenti, l’agente può accedere a informazioni esterne e dati in tempo reale.

- Ricordare le percezioni e le azioni passate: Attraverso la memoria conversazionale, l’agente può mantenere un modello coerente del mondo e della sua interazione con esso.

- Agire sul suo ambiente: Attraverso l’uso di strumenti, l’agente può modificare stati, eseguire compiti e influenzare sistemi esterni.

Il context engineering fornisce i pattern architettonici per soddisfare tutti e tre questi requisiti. Di conseguenza, padroneggiare il context engineering è un prerequisito per la costruzione di agenti di IA efficaci. Un sistema ben progettato che fornisce un contesto eccellente può consentire a un LLM di medie capacità di superare le prestazioni di un LLM più potente ma inserito in una povera architettura di contesto. La vera intelligenza del sistema emerge non dal solo modello, ma dall’interazione dinamica tra il modello e l’ambiente informativo che l’ingegnere ha sapientemente costruito per esso.

Parte VI: L’Imperativo Strategico del Context Engineering

La transizione dal prompt engineering al context engineering non è un semplice aggiornamento tecnico; rappresenta il più significativo cambiamento strategico nel panorama dell’intelligenza artificiale applicata. Segna il passaggio dalla fase di sperimentazione con una tecnologia nascente alla fase di ingegnerizzazione di sistemi affidabili, intelligenti e integrati. Comprendere le implicazioni di questo cambiamento è fondamentale per chiunque voglia costruire, gestire o investire in prodotti basati sull’IA.

6.1 Dal “Prompt Hacking” alla Progettazione di Sistemi

Il futuro della costruzione di sistemi affidabili basati su LLM non risiede in “hack” di prompt ingegnosi e fragili, ma in un lavoro di progettazione rigoroso e metodico. L’attenzione della comunità di sviluppo si sta spostando dalla ricerca dell’input testuale ottimale alla definizione del problema, dei suoi confini e del flusso di informazioni necessario per risolverlo. La vera sfida ingegneristica non è più come formulare una domanda, ma come progettare l’intero flusso e l’architettura del “processo di pensiero” di un modello.

Le implementazioni di IA di maggior successo tratteranno il contesto non come un semplice input, ma come una risorsa critica e vincolata, che richiede un’ottimizzazione attenta, proprio come la CPU, la memoria o la larghezza di banda nell’informatica tradizionale. Questo implica lo sviluppo di pratiche come il “context budgeting” (allocazione esplicita dello spazio di contesto), tecniche di compressione del contesto per massimizzare la densità informativa e strategie di caching per evitare di ricalcolare informazioni usate di frequente. La disciplina sta maturando, adottando un rigore che la avvicina sempre di più all’ingegneria del software tradizionale.

6.2 Il Cambiamento delle Competenze dello Sviluppatore

Questa evoluzione paradigmatica si riflette direttamente sul mercato del lavoro e sulle competenze richieste. I ruoli di “Prompt Engineer” sono stati in gran parte sostituiti da titoli più completi come “AI Engineer”, “LLM Developer” o “Machine Learning Operations (MLOps) Engineer”. Le competenze richieste non si limitano più ai fondamenti dell’elaborazione del linguaggio naturale (NLP) e alla scrittura creativa.

Lo sviluppatore di IA del futuro è un architetto di sistemi sofisticato. Deve possedere una profonda conoscenza dell’integrazione di sistemi, dell’architettura dei dati, dei database vettoriali, della progettazione di API e della sicurezza informatica. Deve essere in grado di orchestrare flussi di dati complessi tra LLM, database, servizi esterni e interfacce utente. Il suo lavoro non è più quello di “convincere” una scatola nera a dare la risposta giusta, ma di progettare un sistema trasparente e controllabile in cui l’LLM è solo uno dei componenti, per quanto potente. Questa è una trasformazione da “addestratore di modelli” a “costruttore di sistemi intelligenti”.

6.3 Analisi Conclusiva: Il Contesto come Asset Fondamentale

In conclusione, il contesto è emerso come la “valuta centrale” che determina se un sistema di IA fornisce un valore reale o rimane un costoso esperimento tecnologico. Come ha affermato Andrej Karpathy, una delle figure più influenti nel campo, in ogni applicazione LLM di livello industriale, il context engineering è la delicata arte e scienza di riempire la finestra di contesto con le informazioni giuste al momento giusto.

Il passaggio dal prompt engineering al context engineering rappresenta una maturazione fondamentale per l’industria dell’IA. È il momento in cui l’attenzione si sposta dall’incanto per le capacità grezze di un modello alla disciplina necessaria per costruire prodotti robusti. Le aziende, gli sviluppatori e i leader tecnologici che padroneggeranno l’arte e la scienza della progettazione e della gestione del contesto saranno coloro che costruiranno la prossima generazione di prodotti di intelligenza artificiale veramente trasformativi. Non vincerà chi avrà accesso al modello più grande, ma chi saprà costruire l’ambiente informativo più intelligente attorno ad esso.

Da informatico a cercatore di senso

![VIDU (il Sora cinese) è finalmente disponibile [Tutorial] 7 VIDU (il Sora cinese) è finalmente disponibile [Tutorial]](https://umanesimodigitale.info/wp-content/uploads/2024/08/Designer-14-150x150.jpeg)