🧠 Quando l’IA diventa alibi: il caso Deloitte e la crisi dell’integrità digitale

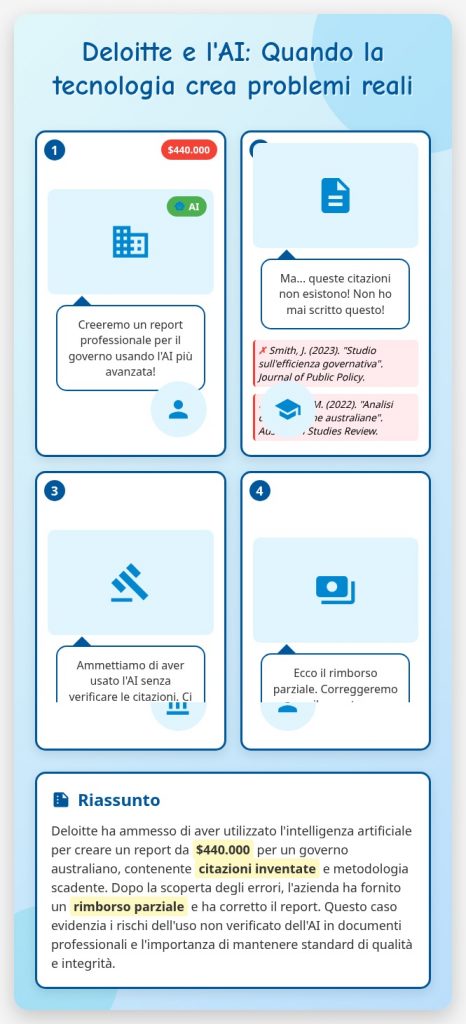

Nel cuore dell’infosfera contemporanea, dove ogni documento può essere generato, ogni citazione simulata e ogni parere confezionato in pochi secondi, il caso del report Deloitte commissionato dal governo australiano rappresenta un campanello d’allarme che non possiamo ignorare. Un report da 440.000 dollari, destinato al Dipartimento per le Relazioni sul Lavoro, è stato rivelato come un prodotto viziato da errori metodologici, citazioni inventate e persino un falso riferimento a una sentenza della Corte Federale.

📉 Una crisi di credibilità

Che un documento ufficiale, pagato con fondi pubblici, possa contenere citazioni accademiche inesistenti è già di per sé inquietante. Ma che queste citazioni siano state probabilmente “allucinate” da un sistema di intelligenza artificiale, e che nessuno nel processo di revisione se ne sia accorto, è sintomo di una crisi più profonda: quella della delega cieca alla tecnologia e della disattenzione umana.

Gli accademici coinvolti, il cui nome è stato associato a lavori mai scritti, hanno dovuto intervenire pubblicamente per segnalare l’errore. Solo allora Deloitte ha provveduto a correggere il report e a offrire un rimborso parziale. Ma il danno reputazionale, per loro e per l’intero ecosistema della ricerca, resta.

🧾 Il problema non è (solo) l’IA

Troppo facile puntare il dito contro l’intelligenza artificiale. Il vero nodo è umano: è la tentazione di scorciatoie, la mancanza di verifica, l’erosione dei processi di controllo. L’IA non è colpevole di aver inventato citazioni; è colpevole chi le ha accettate senza verificarle. In un contesto dove ogni secondo post parla delle “promesse e dei pericoli” della GenAI, questo episodio ci ricorda che il pericolo maggiore è l’uso superficiale e irresponsabile della tecnologia.

⚠️ Dove sono finiti rigore e responsabilità?

Un tempo, la produzione di un report governativo implicava settimane di ricerca, confronto, revisione. Oggi, bastano pochi prompt e un algoritmo. Ma ciò che manca è la domanda di qualità. Non basta che un testo “sembri” autorevole: deve esserlo. E questo richiede tempo, competenza, etica.

Il caso Deloitte non è un incidente isolato. È il sintomo di un sistema che ha smarrito il senso del controllo, dove l’efficienza ha soppiantato la verità, e dove l’integrità è sacrificata sull’altare della rapidità.

🔍 Una chiamata alla vigilanza

Serve una nuova alfabetizzazione digitale, che non si limiti a insegnare come usare l’IA, ma insegni a dubitare, a verificare, a pretendere rigore. Serve una cultura della responsabilità condivisa, dove ogni attore—tecnologo, consulente, accademico, funzionario—si senta custode della qualità.

Perché il vero rischio non è che l’IA sbagli. È che noi smettiamo di accorgercene.

Da informatico a cercatore di senso