L’Inganno del Moment AI

Mi trovo spesso in conversazioni surreali nei corridoi digitali del 2025. Amministratori delegati esaltati che dicono: “Abbiamo ChatGPT, siamo già AI-driven”. Responsabili IT che si congratulano per aver lanciato un chatbot interno. Dipendenti che, di nascosto, usano Claude e ChatGPT personali perché gli strumenti ufficiali dell’azienda non funzionano. Sono l’ingegnere, l’umanista digitale che ha passato anni a combattere questa battaglia, e voglio condividere ciò che è realmente in gioco.

Il grande inganno di questa epoca è semplice, ma devastante: confondere l’accesso alla tecnologia con la trasformazione reale. È come possedere una Ferrari parcheggiata in garage e pensare di essere un pilota. La macchina c’è, ma non sta andando da nessuna parte.

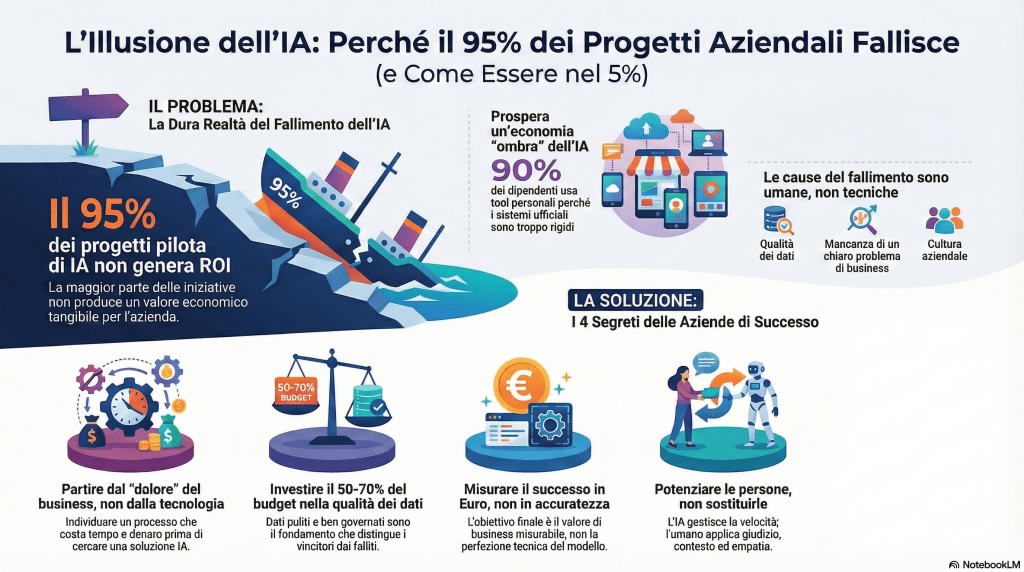

I numeri sono limpidi e terrificanti. Secondo un report recente del MIT, il 95% dei progetti AI pilota in aziende fallisce a livello di ROI significativo. Solo il 5% raggiunge realmente la trasformazione di processo. Eppure nel contempo, in Italia, il 46% dei dipendenti dichiara di usare AI sul lavoro, un balzo vertiginoso dal 12% dell’anno precedente. Come è possibile questo paradosso apparente? La risposta è inquietante: la “Shadow AI Economy”.

Mentre le aziende investono miliardi in progetti enterprise official che restano bloccati, il 90% dei dipendenti utilizza tranquillamente ChatGPT, Claude e altri tool personali per svolgere il lavoro quotidiano. Non lo fanno per sfida; lo fanno perché funziona. I sistemi ufficiali sono rigidi, complicati, scollegati dal workflow reale. E così, invisibile agli amministratori, un’economia parallela di intelligenza artificiale prospera, generando un ROI che le metriche tradizionali non vedono nemmeno.

Questo articolo non parla di hype. Parla della distanza siderale tra quello che le aziende credono di fare con l’AI e quello che effettivamente stanno facendo. E soprattutto, parla di come colmare quella distanza mettendo gli umani, non i modelli, al centro della strategia.

La Statistica che Dovrebbe Svegliarvi la Notte

Nel 2024, il 17% delle aziende aveva abbandonato la maggior parte delle loro iniziative AI. Nel 2025, quella percentuale è salita al 42%. In un anno. È un’accelerazione che non parla di pessimismo; parla di delusione seria.

A livello globale, l’80% dei progetti AI fallisce, secondo l’analisi della RAND Corporation, con un tasso di fallimento doppio rispetto ai progetti IT tradizionali. Le cause? Non sono misteriose. Le organizzazioni citano problemi di qualità dei dati (43%), scarsa maturità tecnica (43%), carenza di competenze (35%). Ma dietro questi numeri c’è qualcosa di più profondo: un gap organizzativo, culturale, umano.

Se gli strumenti AI stessi fossero il problema, nessuno li userebbe. Eppure il 90% dei dipendenti li usa—proprio perché funzionano quando vengono applicati a problemi reali, senza la mortificazione della bureaucrazia enterprise.

Nel frattempo, globalmente, le aziende che effettivamente implementano GenAI sono passate dal 6% nel 2023 al 30% nel 2025: un incremento di cinque volte in soli due anni. Non è un numero di fallimento; è un numero di adozione massiccia con risultati deludenti. E questo è il vero problema.

Il Contesto Italiano: Entusiasmo Precoce, Risultati Scarsi

In Italia, il quadro è affascinante e contraddittorio. Le grandi aziende mostrano curiosità: il 64% dei responsabili ritiene che l’AI cambierà il modello di business. Il 52% del top management ha già rilevato benefici tangibili in termini di riduzione dei costi. Eppure solamente il 38,2% delle aziende italiane ha avviato percorsi concreti di implementazione o sperimentazione.

C’è uno stacco netto. Le aziende sono affascinate dall’idea, ma stanno ancora timidamente sperimentando. L’Italia rimane un paese dove il 73% delle aziende ritiene che l’AI migliorerà la propria situazione economica, ma dove il divario tra consapevolezza e azione è ancora notevole. È il gap più pericoloso: quello tra aspettativa e realtà.

Gli Errori che Rendono il 95% un Numero Inevitabile

Errore 1: Pensare che la Tecnologia Sia il Problema

L’errore più insidioso è questo: lanciare un chatbot, considerarlo un progetto AI, e aspettarsi miracoli. Alle conferenze, sento frasi come: “Abbiamo implementato un tool di GenAI per il customer service”. Implementato significa cosa, esattamente? Installato? Acceso? Usato?

La verità è che il modello tecnico raramente è il collo di bottiglia. I modelli moderni—ChatGPT, Claude, Gemini—sono straordinariamente sofisticati. Quello che implode è tutto il resto: l’integrazione con i sistemi aziendali, la qualità dei dati, la governance, il change management, la fiducia degli utenti.

Un team di data scientist può costruire un modello con un punteggio F1 del 95% che, una volta messo in produzione, raccoglie polvere perché i supervisori non si fidano dell’output generato automaticamente. È un fallimento organizzativo travestito da fallimento tecnico.

Errore 2: Confondere Data Quantity con Data Quality

Le aziende credono di avere dati. In realtà, hanno dati caotici. Consistenza zero. Duplicati sparsi. Informazioni outdated sepolte in silos dipartimentali. È quello che il report del MIT chiama “messy data”.

Ecco il dato che fa male: il 50-70% del budget e della timeline di un progetto AI dovrebbe andare a data readiness—pulizia, normalizzazione, governance, qualità. Non alle modellazioni sofisticate. Non agli esperimenti. Ai dati. Eppure le organizzazioni invertono questa proporzione. Costruiscono un castello tecnico su fondamenta di sabbia e poi si chiedono perché crolla.

Errore 3: Lanciare Pilot senza Chiarire il Problema di Business

È lo schema ricorrente: una startup propone un pilot. L’organizzazione lo accetta. Tutti sperimentano per tre mesi. Poi? Silenzio. Il progetto non scala, non genera valore, scompare dalla vista.

Succede perché il pilot è iniziato dalla domanda sbagliata: “Cosa potremmo fare con l’AI?” anziché “Quale processo ci costa denaro reale e potrebbe essere trasformato?”. I vincitori iniziano sempre dall’opposto: dal dolore del business, dall’incoerenza di processo, dal waste che misuri in euro e che puoi quantificare. Solo allora speculi sulla soluzione.

Uno studio recente di Informatica ha dimostrato che le organizzazioni che investono disproportionatamente in data readiness—trascinandosi dietro la noia della governance e del monitoraggio—superano di gran lunga quelle che corrono verso i modelli.

Errore 4: Diventare Vittima della “Model Fetishism”

Questo è il vizio dell’ingegnere. Team di ML appassionatamente impegnati a ottimizzare la precisione del modello, a testare architetture sofisticate, a sfidare i benchmark—mentre intanto i compiti di integrazione rimangono in backlog eternamente.

Quando il progetto infine emerge per la revisione business, i requisiti di compliance appaiono insormontabili. Il business case rimane teorico. E i mesi di lavoro tecnico di qualità superiore diventano un catalogo di bellissime cose che non risolvono niente.

Errore 5: Ignorare la “Shadow AI Economy”

Ecco il paradosso che uccide le strategie: mentre i progetti official AI richiedono approvazioni, governance, cicli di test—i dipendenti semplicemente usano ChatGPT, Claude, Gemini personali, e il lavoro avanza.

In una azienda che intervisto, scopro che l’80% del “riassunto documenti” viene fatto con tool personali. Il sistema official esiste, è stato pagato, è stato lanciato. Ma nessuno lo usa. Perché? Perché la versione personale è più veloce, più flessibile, più intuitiva.

Questo non è un fallimento del dipendente. È un fallimento del leader di aver costruito uno strumento che non risolve il vero problema del lavoro quotidiano. La “Shadow AI” non è un nemico da combattere; è un segnale di cosa effettivamente funziona.

Perché il 5% Vince: I Pattern di Successo

Dato che ho passato anni a osservare cosa separa i vincitori dai perdenti, posso identificare con precisione i pattern che il 5% incarna.

Pattern 1: Iniziare dall’Incoerenza, Non dalla Tecnologia

I progetti AI vincenti iniziano sempre con una domanda dolorosa: “Quale processo consuma ore di lavoro manuale, genera errori sistematici, e mi costa davvero soldi?”. Potrebbe essere il triage dei sinistri in assicurazione. Potrebbe essere la categorizzazione di richieste di supporto. Potrebbe essere l’estrazione di dati da documenti PDF.

Solo dopo aver cristallizzato il dolore economico—“Questo processo ci costa €500.000 l’anno in ore di lavoro”—si specifica la soluzione. E a quel punto, l’AI non è più una domanda teorica. È una risposta necessaria a un problema concreto.

Pattern 2: Investire Massicciamente in Data Readiness

Il 5% che vince differisce dai fallitori in un punto specifico: alloca il 50-70% della timeline e del budget non al modello, ma alla fondazione dati. Significa:

- Mappare dove vivono i dati (e scoprire che nessuno sa veramente)

- Pulire, normalizzare, deduplicare

- Stabilire governance metadata robusta

- Costruire dashboard di qualità continua

- Gestire retention e compliance

È noioso. Non è sexy. Ma è ciò che distingue i sopravvissuti dai falliti. Secondo Informatica, le aziende che lo fanno riportano velocità di implementazione 3-5 volte superiore e affidabilità drammaticamente migliore.

Pattern 3: Misurare il Successo in Dollari, Non in Accuratezza

I vincitori sanno che il modello non è il cliente. Il cliente è il business. E il business misura valore in una sola cosa: risultati misurabili.

Non dicono: “Il nostro modello ha un’accuratezza del 94%”. Dicono: “Abbiamo ridotto il tempo di processing dai 3 giorni a 2 ore, liberando 8 FTE che abbiamo reindirizzato al customer relationships, generando €600.000 di valore annuale”.

La differenza è quantitativa e ontologica. Uno è una metrica tecnica. L’altro è business value reale.

Pattern 4: Costruire il Change Management Come Feature, Non Come Valvola di Emergenza

Il 95% dei progetti falliti dimentica una cosa: gli umani useranno il nuovo sistema solo se gli umani lo capiscono, vi si fidano, e vedono il valore personale.

Il 5% vincente lo sa sin dal giorno uno. E costruisce:

- Comunicazione trasparente sul perché il cambiamento sta accadendo

- Training vero, non sessioni nominali di 30 minuti

- Champions locali—persone che già credono e insegnano ai pari

- Feedback loops veloci da chi lavora effettivamente con il sistema

- Governance della fiducia, non governance del controllo

Se i supervisori di contact center non si fidano della sintesi automatica, continueranno a digitare manualmente. Sei ingegneri e tre mesi di ML non risolveranno il problema. Quello che lo risolve è un processo di change management che dice: “Ecco come funziona. Ecco perché funziona. Ecco come verifichiamo i risultati insieme”.

Pattern 5: Abbracciare l’Augmentation, Non la Sostituzione

Qui arriviamo al cuore dell’umanesimo digitale. I progetti vincenti non cercano di rimpiazzare gli umani. Cercano di potenziarli.

L’Intelligenza Aumentata significa: l’AI fa quello che l’AI fa bene (velocità, scalabilità, riconoscimento di pattern). Gli umani fanno quello che gli umani fanno bene (contesto, giudizio, empatia, creatività). Insieme, generano valore che nessuno dei due potrebbe generare da solo.

Un’azienda manifatturiera che implementa AI per la manutenzione predittiva non licenzia gli ingegneri. Fa sì che gli ingegneri, supportati dall’AI, passino da interventi reattivi (il macchinario si rompe, facciamo qualcosa) a interventi proattivi (l’AI prevede il guasto, l’ingegnere prepara il fix, il downtime scompare).

I risultati? Produttività +35%. Confidenza dei lavoratori +60%. Sensazione di sicurezza del lavoro? Aumenta, non diminuisce, perché il dipendente sa che la tecnologia lo sta potenziando.

Il Contesto della Produttività: La Curva a “J” che Nessuno Ama

C’è una verità che uccide molti progetti prima di iniziare. Quando introduci una tecnologia radicale, la produttività inizialmente cala. È la fase che scendo tutti odiano. I processi vecchi non funzionano più. I nuovi non sono ancora padroneggati. Ed ecco che arriva il CFO che dice: “Secondo voi, qualcuno mi sta ascoltando?”.

No. Qui è dove il 95% fallisce e il 5% vince. Il 95% interpreta il calo iniziale come un segnale di fallimento e abbandona il progetto. Il 5% lo interpreta come esattamente quello che è: il segno che una vera trasformazione è in corso.

La transizione verso AI in azienda non è una curva lineare verso l’alto. È una “J”: scende inizialmente, poi risale con un’esplosione di valore superiore al precedente. Ma il viaggio attraverso il basso è la parte che fa male. E la maggior parte delle organizzazioni non ha il coraggio di attraversarlo.

Italia: Dove Siamo Realmente?

L’Italia rappresenta un caso studio affascinante nel conflitto tra consapevolezza e azione. Il nostro paese è prima in Europa per lavoratori che investono nella propria formazione AI (64% contro una media europea minore). È un segnale di intelligenza, di curiosità, di fame di competenza.

Eppure, paradossalmente, le grandi aziende italiane procedono ancora con cautela. Solo il 38,2% ha avviato percorsi concreti. È comprensibile: il rischio è alto, il costo è alto, e il mercato italiano è conservatore. Ma questa cautela nasconde un rischio ancora più grande: rimanere indietro.

Perché? Perché il potenziale di trasformazione economica è enorme. Se le aziende italiane veramente implementassero AI in modo strutturato—non superficiale—il beneficio potrebbe tradursi in un incremento di produttività complessiva di 115 miliardi di euro. È il PIL della città di Roma. È denaro lasciatoSede sul tavolo a causa dell’indecisione.

Il top management italiano ha capito il messaggio (il 73% ritiene che l’AI migliorerà la situazione economica). Quello che manca è il coraggio di affrontare la trasformazione consapevolmente, preparati alle illusioni e ai fallimenti iniziali.

L’Intelligenza Artificiale come Responsabilità, Non come Tool

Qui arriviamo al punto centrale della mia visione di umanista digitale. L’AI non è uno strumento da implementare. È una responsabilità da assumere.

Nel 2023, era normale “fare qualche esperimento di GenAI”. Chatbot carini, piccoli tool per sintesi, apprendimento-e-dimenticanza veloce. Nel 2025, quella mentalità è obsoleta. Le aziende che oggi vincono sono quelle che si assumono la responsabilità di cambiare un processo intero. Non danno licenze AI ai dipendenti e dicono “buona fortuna”. Dicono: “Io mi prendo carico del triage dei sinistri da inizio a fine. Io garantisco che in 6 mesi riduci i costi del 40%. I tuoi dipendenti verificheranno i risultati, non faranno il lavoro meccanico”.

A quel punto, non stai comprando software. Stai comprando un partnership operativo. Stai comprando un BPO (Business Process Outsourcing) digitale. È una trasformazione categoriale di quello che significa “implementare AI”.

E questo cambia chi dirige il progetto. Non è il CTO che installa tool. È il Process Owner che conosce intimamente come il lavoro realmente accade, quale knowledge è codificata (le regole scritte) e quale è tacita (l’esperienza, il contesto, i workaround). Quella conoscenza tacita è dove vive il valore reale.

La Visione dell’Umanesimo Digitale nel Contesto AI

Dopo anni di ricerca e applicazione pratica, sono arrivato a una conclusione: l’umanesimo digitale non è il contrario dell’AI. È il fondamento su cui una vera implementazione di AI può prosperare.

L’umanesimo digitale significa:

1. Mettere l’intelligenza umana prima di quella artificiale. Non chiedere: “Cosa può fare l’AI?” Chiedere: “Come posso potenziare l’intelligenza umana?” L’AI è il substrato; l’umano è il fine.

2. Progettare per l’augmentation, non per la sostituzione. Ogni sistema AI deve essere costruito con l’assunzione esplicita che il suo ruolo è potenziare gli umani. Non rimuovere lavoro. Rimuovere l’elemento noioso del lavoro, liberando spazio per l’elemento umano—il giudizio, la creatività, l’empatia.

3. Costruire la governance sulla trasparenza e sulla fiducia. Non sulla paura. La governance AI dominante è ancora carica di terrore: paura dell’automazione, paura della perdita di posti, paura che l’AI “prenda il controllo”. Il vero umanesimo digitale riconosce questi timori e li trasforma in conversazioni strutturate sulla responsabilità.

4. Investire nella reskilling come priorità centrale. Se la tua strategia AI non include un piano massiccio per insegnare ai tuoi dipendenti come lavorare con l’AI (non contro di essa), non hai una strategia. Hai un esperimento.

5. Misurare il successo in termini di dignità professionale e sviluppo umano. Non solo in produttività. Un progetto AI che aumenta la produttività del 40% ma riduce la dignità professionale del dipendente non è un successo. È un fallimento mascherato da numero.

Le Competenze Che Serviranno Nel 2026 e Oltre

Se sei un leader aziendale e stai leggendo questo, ti starai chiedendo: cosa faccio adesso? Quale competenza costruisco? Chi assuno?

La risposta rifiuta la narrazione classica. Non hai bisogno di più data scientist. Hai bisogno di:

Process Owners che capiscono davvero come il lavoro accade. Persone che sanno riconoscere dove l’AI potrebbe genuinamente aiutare. Non persone che amano l’AI in astratto. Persone che amano i loro processi e vogliono potenziarli.

Change Leaders con vera empatia. Non persone che implementano cambiamenti a la gente. Persone che implementano cambiamenti con la gente, che capiscono le paure, i dubbi, e che costruiscono fiducia incrementalmente.

Data Stewards che proteggono la qualità come una missione. Non amministratori di database. Persone che capiscono che il valore dell’AI vive o muore con la qualità dei dati, e che si assumono la responsabilità personale di mantenerla.

Esperti di Ethics e Governance in stile AI. Non i vecchi compliance officer. Persone che sanno che l’etica non è un checkbox; è un processo continuo di deliberazione sulla responsabilità.

E infine, Early Adopters interni. Persone che credono davvero nella trasformazione e che hanno il coraggio di sperimentare per primi, fallire pubblicamente, imparare, e insegnare ai pari.

Il Percorso Pratico: Come Non Essere il 95%

Se devo sintetizzare in un percorso concreto come non finire tra i falliti, ecco la roadmap:

Fase 0 (Preparazione – 1 mese): Smetti di pensare in termini di “implementazione AI”. Inizia pensando in termini di “quale processo voglio trasformare?”. Mappa i processi che consumano il maggior tempo, generano il maggior numero di errori, costano il maggior importo. Quantifica il dolore in euro.

Fase 1 (Selezione – 2 settimane): Scegli UNO processo. Non tre, non dieci. Uno. Uno dove il dolore è quantificato, dove i dati esistono (anche se caotici), e dove una vittoria è misurabile e comunicabile.

Fase 2 (Preparazione dei Dati – 2-3 mesi): Investi il 60% del tuo budget e della tua timeline qui. Pulizia, normalizzazione, governance. È tedioso. È necessario. Non scorciatoje.

Fase 3 (Pilota Consapevole – 3-4 mesi): Implementa la soluzione con un gruppo scelto di utenti. Non come “esperimento”. Come “primo passo di una trasformazione che abbiamo pianificato coscientemente”. Dai feedback loop chiari. Construisci fiducia incrementale.

Fase 4 (Change Management Intenso – 2-3 mesi parallelo a Fase 3): Communication, training, champions, feedback. Questo non è un bonus. È il progetto principale. Se i dipendenti non capiscono e non si fidano, il resto è inutile.

Fase 5 (Scale e Monitor – 6-12 mesi): Estendi gradualmente. Monitora non solo l’accuratezza tecnica, ma il business value reale. E soprattutto, continua ad ascoltare i dipendenti. Il loro feedback non è un fastidio; è il tuo compass.

Il totale? 12-18 mesi per una vera trasformazione di un singolo processo. Non tre mesi di pilot che poi scompare. Non “andiamo a vedere cosa succede”. Una trasformazione consapevole, strutturata, e umana.

La Prova Finale: Parla la Shadow AI Economy

Chiudo con uno specchio rude. Nel tuo ufficio, in questo momento, c’è una “Shadow AI Economy” che prospera. Dipendenti che usano ChatGPT personali perché i sistemi ufficiali non funzionano. È una prova che l’AI funziona—solo che non nel modo che hai pianificato.

Puoi combatterla con policy rigide. Puoi proibire tool personali. Puoi costruire firewall. Oppure puoi fare qualcosa di più intelligente: puoi imparare da essa.

Impara quale tool stanno effettivamente usando. Impara quale problema stanno risolvendo. Impara perché preferiscono la soluzione personale a quella aziendale. E poi, forse, costruisci una soluzione ufficiale che risolve il problema vero.

Quello che stai vedendo nella Shadow AI Economy non è un fallimento di governance. È un segnale di dove l’AI dovrebbe veramente andare in azienda.

❓ Perché il 95% dei progetti AI fallisce e non il 90%?

Perché il MIT ha misurato specificamente il fail come “progetti che non raggiungono ROI significativo” vs “progetti che generano valore misurabile”. Il 95% non fallisce nel senso che l’AI non funziona tecnicamente. Fallisce nel senso che non genera valore economico tangibile. La differenza è cruciale: tecnicamente funziona. Economicamente no.❓ Come distinguo un processo “ready per l’AI” da uno che resterà bloccato?

Tre domande di screening: (1) È un processo ripetitivo e strutturato? Se è completamente creativo e non strutturato, l’AI sarà inefficace. (2) Ho accesso a dati sufficienti e ragionevolmente puliti per addestrare il modello? Se i dati sono un caos totale e fragmentato, dovrai spendere 6 mesi solo a prepararli. (3) Gli errori dell’AI causano danni minori rispetto ai guadagni di velocità? Se una decisione sbagliata dell’AI ti causa un danno di €10.000, ma il sistema ti risparmia €1.000 in tempo, non è un’operazione conveniente. Se rispondi sì alle tre, sei pronto.❓ Il mio team ha paura che l’AI li rimpiazzi. Come affronto questa paura?

Con onestà e trasparenza. La paura è razionale in un contesto dove l’AI è vista come automazione. Diventa irrazionale quando è vista come augmentation. Non dire “l’AI non vi sostituirà”—detto così, suona come una bugia. Dì: “L’AI farà le parti noiose del vostro lavoro. Voi farete le parti che richiedono giudizio, creazione, relazione. Se oggi passate 6 ore a digitare e 2 ore a pensare, tra un anno passerete 2 ore a verificare cosa l’AI ha fatto e 6 ore a pensare strategicamente”. Poi, *mantieni la promessa*. Se la mantieni, la paura scompare. Se la tradisci, nessun comunicato la farà tornare indietro.❓ Quanto deve costare un progetto AI per essere significativo?

Non è una domanda di budget. È una domanda di valore atteso. Un progetto AI da €100.000 che riduce il costo operativo di €500.000 annuali è un successo clamoroso. Un progetto AI da €2 milioni che genera zero ROI è un disastro. La metrica non è “quanto spendo”. È “quanto di valore economico creo rispetto a quanto spendo”. Il buon senso: se il valore atteso non è almeno 3x il costo entro 24 mesi, ripensi la priorità.❓ Chi dovrebbe guidare un progetto AI—il CTO o il responsabile del processo?

Idealmente, una partnership strutturata. Ma se devo scegliere, il responsabile del processo. Il CTO costruisce la strada; il responsabile del processo sa dove deve andare. Se il progetto è guidato da un CTO che ama la tecnologia, finisce in “model fetishism”: bellissimo dal punto di vista tecnico, inutile dal punto di vista operativo. Se è guidato dal responsabile del processo che non capisce il limite tecnico, finisce in richieste impossibili. Ma il responsabile del processo che dice “voglio ridurre il costo del mio processo del 40% in 18 mesi, ecco il processo, ecco i dati, ecco il budget—ditemi cosa è possibile”—quello arriva alla soluzione.❓ L’AI generativa (ChatGPT, Claude, Gemini) è diversa dalla “vecchia” AI per le aziende?

Radicalmente. La vecchia AI (machine learning tradizionale) era ottima per problemi ben definiti con output categorici: “qual è la categoria di questa transazione?”, “questo cliente è a rischio?”. Generava un numero. La GenAI è ottima per problemi che richiedono linguaggio naturale, spiegazioni, creazione di contenuto: “riassumi questo documento”, “suggerisci una soluzione”, “genera opzioni”. Ma entrambe incontrano lo stesso muro in azienda: dati caotici, processi mal definiti, assenza di governance reale. La tecnologia è diversa; i fallimenti organizzativi sono identici.❓ Devo costruire la mia soluzione AI in-house o comprare da un vendor?

Il dato della MIT research è netto: i progetti partnership con vendor specializzati raggiungono il 65% di successo. I progetti interamente in-house raggiungono il 33%. I progetti che cercano di “trovare una soluzione off-the-shelf generica” raggiungono il 15%. Perché? Perché il vendor specializzato ha già visto il tuo problema in 50 altre aziende. Ha pattern, framework, e know-how. Il tuo team ha talento ma inesperienza. Detto questo, il vendor deve essere scelto con cura, non basandosi su promesse, ma su referenze concrete di casi simili al tuo.❓ Come misuro il successo se il ROI tradizionale è difficile da quantificare?

Non è vero. Il ROI è sempre quantificabile. Quello che è difficile è il *tempo* per misurarlo. Esempi concreti: Processo A costa 10 persone × €50.000 = €500.000 annui. Con AI, ne servono 3. Risparmio: €350.000. Costo del progetto AI: €100.000. ROI primo anno: 250%. Processo B: “vogliamo client più felici”. Come lo misuri? Con NPS, tempo di risposta medio, tasso di churn. Prima AI: NPS 60, tempo 48 ore, churn 12%. Dopo AI: NPS 75, tempo 4 ore, churn 7%. Il cliente rimane in media 2 anni in più (€200.000 di LTV). Costo progetto: €50.000. ROI: 300%. Non è difficile. È che richiede di essere onesti su cos’è il valore per il tuo business.1️⃣ IL FALLIMENTO DEL 95% E IL MIT REPORT

📌 “L’intelligenza artificiale alla prova dei fatti: secondo il MIT il 95% dei progetti AI fallito tra enterprise”

- Fonte: EduNews24 | Data: 26 agosto 2025

- Link: https://edunews24.it/ricerca/lintelligenza-artificiale-alla-prova-dei-fatti-secondo-il-mit-il-95-dei-progetti-ai-fallito-tra-ent

- Perché leggerlo: Analisi diretta del MIT Report con le 4 cause di fallimento (overestimation, dati di scarsa qualità, difficoltà integrazione, barriere normative)

📌 “Mit: il 95% dei progetti GenAI fallisce, ecco perché”

- Fonte: inno3.it | Data: 4 settembre 2025

- Link: https://inno3.it/2025/09/05/mit-il-95-dei-progetti-genai-fallisce-ecco-perche/

- Perché leggerlo: Illustra il “GenAI Divide”—solo il 5% raggiunge la produzione effettiva

📌 “IA generativa: lo studio MIT svela il fallimento aziendale”

- Fonte: AlgoMera.it | Data: 1 settembre 2025

- Link: https://algomera.it/ia-generativa-aziende-mit-fallimento-investimenti-02-09-2025/

- Perché leggerlo: Focus diretto sul divario tra investimenti enormi e ROI tangibile

2️⃣ SHADOW AI ECONOMY

📌 “Il boom della shadow AI economy”

- Fonte: Logotel.it | Data: 25 settembre 2025

- Link: https://www.logotel.it/il-boom-della-shadow-ai-economy/

- Perché leggerlo: Approfondimento completo del fenomeno con dati dell’Osservatorio HR Innovation del Politecnico di Milano. Spiega come trasformarla in vantaggio competitivo

📌 “Shadow AI aziendale: rischi, normativa AI Act e sicurezza”

- Fonte: Eurosystem.it | Data: 31 luglio 2025

- Link: https://eurosystem.it/shadow-ai/

- Perché leggerlo: Dato critico: 90% dell’uso di AI avviene da account personali, solo il 19% delle imprese ha una policy attiva. Include tabella comparativa “AI incontrollata vs AI gestita”

📌 “Uso dell’AI in azienda: Produttività, Rischi e Shadow AI in Aumento”

- Fonte: Frareg.com | Data: 18 maggio 2025

- Link: https://www.frareg.com/it/sicurezza-sul-lavoro/uso-ai-azienda-produttivita-rischi-shadow-ai/

- Perché leggerlo: Motivi psicologici della Shadow AI (vantaggio segreto 36%, paura perdita 30%, imposter syndrome 27%). Dati: 42% dei dipendenti usa GenAI senza informare il datore

3️⃣ CHANGE MANAGEMENT E TRASFORMAZIONE ORGANIZZATIVA

📌 “Strategie efficaci di change management per l’AI adoption”

- Fonte: Logotel.it | Data: 8 maggio 2025

- Link: https://www.logotel.it/strategie-efficaci-di-change-management-per-lai-adoption/

- Perché leggerlo: Directamente: “Integrare l’AI richiede ben più che una scelta tecnologica”. Sottolinea il gap tra strategy e operatività, il disallineamento principale

📌 “Change Agent e AI: come le persone guidano la trasformazione digitale”

- Fonte: Soprasteria.it | Data: 15 luglio 2025

- Link: https://www.soprasteria.it/blog/article2/change-agent-ai-trasformazione-digitale

- Perché leggerlo: Definisce i “Change Agent” come moltiplicatori dell’innovazione. Approccio iTChange che mette le persone come motore del cambiamento, non la tecnologia

4️⃣ DATA QUALITY E DATA READINESS

📌 “AI Data Quality: come garantirla per l’intelligenza artificiale”

- Fonte: bNova.it | Data: 10 settembre 2025

- Link: https://www.bnova.it/analytics/ai-data-quality-intelligenza-artificiale/

- Perché leggerlo: “Garbage in, garbage out” applicato all’AI con rigore. Affronta completezza, coerenza, rappresentatività, distorsioni sistemiche

📌 “AI e Data Quality: il segreto dell’efficacia sta nella qualità dei dati”

- Fonte: Intesys.it | Data: 5 novembre 2025 (RECENTISSIMO)

- Link: https://www.intesys.it/journal/information-technology/data-quality-il-pilastro-invisibile-che-sostiene-lintelligenza-artificiale

- Perché leggerlo: Introduce Data Governance Council, DQ-KPIs, metadati, data ownership—i concetti concreti di data readiness

📌 “La qualità dei dati è fondamentale per l’IA, ma le aziende…”

- Fonte: DigitalWorldItalia.it | Data: 5 giugno 2024

- Link: https://www.digitalworlditalia.it/tecnologie-emergenti/intelligenza-artificiale/qualita-dati-fondamentale-per-ia-ma-le-aziende-i

- Perché leggerlo: Dato drammatico: 3 aziende su 4 non sono pronte per AI a causa di mancanza di programmi di gestione dati avanzata

5️⃣ INTELLIGENZA AUMENTATA (AUGMENTED INTELLIGENCE)

📌 “Intelligenza aumentata e analisi predittiva: le chiavi per Augmented Governance”

- Fonte: RegestaItalia.eu | Data: 10 aprile 2025

- Link: https://www.regestaitalia.eu/intelligenza-aumentata-e-analisi-predittiva-le-chiavi-per-un-nuovo-paradigma-di-augmented-governanc

- Perché leggerlo: Supera la resistenza sulla “sostituzione dell’umano”. Definisce intelligenza aumentata secondo Gartner come “partnership centrato sull’uomo”

📌 “Cos’è l’intelligenza aumentata? Esempi e vantaggi”

- Fonte: Mecalux.it | Data: 14 maggio 2025

- Link: https://www.mecalux.it/blog/intelligenza-aumentata

- Perché leggerlo: Differenzia nettamente IA (automatizzazione) da Intelligenza Aumentata (rafforza capacità umane di scegliere e agire)

6️⃣ BPO DIGITALE E AI TRANSFORMATION

📌 “AI BPO: le evoluzioni in atto e le opportunità da cogliere”

- Fonte: MicroData Group Blog | Data: 9 marzo 2025

- Link: https://blog.microdatagroup.it/ai-bpo-le-evoluzioni-in-atto-e-le-opportunit%C3%A0-da-cogliere

- Perché leggerlo: Proietta il concetto di “AI BPO” come futuro. Dati Gartner: mercato da $2.6B (2023) a $49.6B (2033), CAGR 34.3%

📌 “Business Process Outsourcing (BPO) nel 2025: trend, sfide e soluzioni strategiche”

- Fonte: Winflow.it | Data: 3 febbraio 2025

- Link: https://www.winflow.it/business-process-outsourcing-nel-2025-trend-sfide-e-soluzioni-strategiche/

- Perché leggerlo: BPO come “leva strategica per innovare”, non solo per ridurre costi. Outsourcer come “partner per continuità del business”

7️⃣ TRASFORMAZIONE AI E STRATEGIA

📌 “Trasformazione AI: l’AI per la trasformazione digitale”

- Fonte: IBM (IT) | Data: 22 maggio 2024 (aggiornato 13 settembre 2024)

- Link: https://www.ibm.com/it-it/think/topics/ai-transformation

- Perché leggerlo: Definisce chiaramente che AI Transformation NON è “replica dei processi con nuove tecnologie”, ma “creazione di modi completamente nuovi di fare business”

Da informatico a cercatore di senso