Dalla Propagazione alla Diffusione: Breve Storia di un’Evoluzione

Per comprendere la grandezza di ciò che abbiamo oggi tra le mani dobbiamo fare un passo indietro e guardare sotto il cofano di questa rivoluzione tecnologica. Fino a poco tempo fa, creare un video con l’AI era un’impresa titanica e i risultati erano spesso inquietanti. Possiamo dividere questa evoluzione in due grandi filosofie architettoniche che si sono date battaglia negli ultimi tre anni.

La prima era l’epoca della Propagazione, o approccio autoregressivo. Immaginate un pittore che deve dipingere mille quadri in sequenza per creare un’animazione: dipinge il primo, poi guarda quello appena fatto e cerca di dipingere il successivo variandolo leggermente. Il problema di questa tecnica, che dominava nei primi esperimenti con le GAN (Reti Generative Avversarie), era l’accumulo di errori. Se il pittore sbagliava un dettaglio nel terzo quadro, quell’errore si “propagava” e si ingigantiva nei successivi, trasformando un volto in un vortice di carne o un cane in un tavolo nel giro di pochi secondi. Era il regno dell’incerenza, dove il tempo era nemico della stabilità e i video sembravano sogni febbricitanti che perdevano senso man mano che procedevano.

Poi è arrivata la rivoluzione della Diffusione, la stessa tecnologia che ha dato vita a Midjourney e DALL-E, ma applicata al tempo. Qui l’approccio è radicalmente diverso perché l’AI non “predice” il fotogramma successivo, ma “scolpisce” l’intero video (o grandi blocchi di esso) partendo dal caos totale. Immaginate di avere un cubo di nebbia statica e di chiedere all’AI di rimuovere il rumore finché non emerge una sequenza nitida. Questo ha risolto il problema della qualità visiva, regalandoci immagini cristalline, ma ha introdotto una nuova sfida: la coerenza temporale. Spesso i personaggi cambiavano vestiti o fisionomia tra un secondo e l’altro perché il modello faticava a mantenere l’identità del soggetto attraverso il tempo. Siamo rimasti bloccati qui per tutto il 2024 e parte del 2025, con video bellissimi ma brevi, spesso muti e privi di una vera logica narrativa.

Kling 3.0 e l’Avvento del “Regista Virtuale”

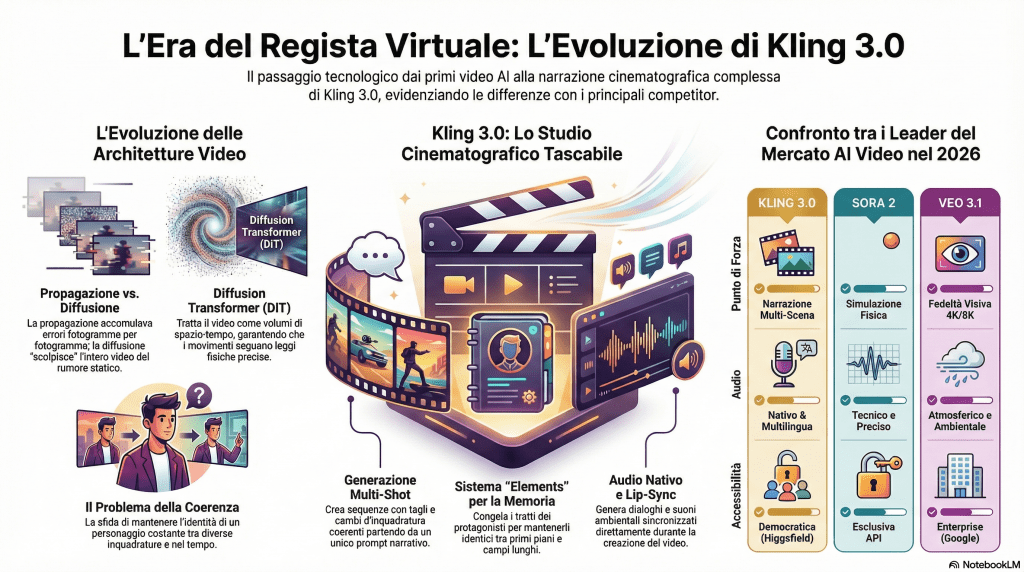

Ed eccoci al presente, a questo febbraio 2026 che segna uno spartiacque. I modelli moderni come Sora e Veo hanno introdotto l’architettura Diffusion Transformer (DiT), che tratta il video non come una sequenza di immagini piatte, ma come volumi di spaziotempo, capendo che se una palla cade deve seguire una traiettoria fisica precisa. Ma ieri è successo qualcosa di più grande con il rilascio di Kling 3.0.

Questo nuovo modello, sviluppato da Kuaishou e reso accessibile anche tramite la piattaforma Higgsfield (o “higgingsfield” come spesso viene storpiata, ma è lì che la magia accade), ha superato i limiti dei suoi predecessori introducendo il concetto di Multi-Shot Generation.

Finora, chiedere a un’AI di generare un video significava ottenere un’unica inquadratura continua. Kling 3.0 agisce invece come un vero regista: potete descrivere una scena complessa con diversi tagli, cambi di inquadratura e movimenti di macchina, e l’AI genererà un montaggio coerente mantenendo i personaggi perfettamente identici tra uno stacco e l’altro.

La vera innovazione architettonica qui risiede nel modo in cui Kling 3.0 gestisce la “memoria” degli elementi. Grazie a un sistema avanzato di gestione degli asset chiamato Elements, il modello “congela” le caratteristiche dei protagonisti e le ripropone fedelmente anche se l’inquadratura passa da un primo piano a un campo lungo, risolvendo l’annoso problema della consistenza che affliggeva la tecnica della propagazione. Inoltre, non stiamo più guardando film muti: Kling 3.0 integra la generazione nativa dell’audio, sincronizzando il movimento labiale e i suoni ambientali direttamente in fase di creazione, non come un’aggiunta posticcia.

Se volete provare questa meraviglia, la soluzione più immediata è passare attraverso Higgsfield, che ha stretto una partnership per portare questa potenza di calcolo sui dispositivi mobili e desktop, democratizzando l’accesso a quello che io definisco il primo vero “studio cinematografico tascabile”. La qualità arriva fino al 4K, con durate che possono estendersi ben oltre i canonici pochi secondi, permettendo finalmente una narrazione articolata e non solo clip dimostrative.

Le Architetture del Tempo: Capire la Tecnica per Apprezzare l’Arte

Per comprendere davvero perché siamo tutti così eccitati per Kling 3.0, dobbiamo sporcarci un po’ le mani con la tecnica. Ma niente paura, useremo metafore semplici, perché la tecnologia, quando è sufficientemente avanzata, non deve essere magica, ma comprensibile.

Propagazione vs. Diffusione: La Battaglia delle Filosofie

Immaginate due artisti incaricati di disegnare un film d’animazione su un blocco di carta.

L’artista della Propagazione (Autoregressiva) lavora con i paraocchi temporali. Disegna la prima pagina, poi la gira e usa quella appena fatta come unico riferimento per disegnare la successiva. “Ok, qui la mano era in alto, nella prossima la metto un po’ più giù”.

- Il vantaggio: È un metodo logico e sequenziale, perfetto per capire “cosa succede dopo”.

- Il difetto fatale: È come il “gioco del telefono senza fili”. Se a pagina 10 disegna un dito un po’ storto, a pagina 20 quel dito sarà diventato un tentacolo. Gli errori si propagano e si accumulano. Più il video è lungo, più diventa un incubo allucinogeno dove la coerenza si disgrega.

L’artista della Diffusione, invece, lavora come uno scultore che vede il blocco di marmo intero (il video completo) fin dall’inizio. Parte da un blocco di rumore statico (come la “neve” delle vecchie TV) e inizia a scalpellare via il caos contemporaneamente in tutti i punti.

- Il vantaggio: La qualità visiva è sbalorditiva. Ogni fotogramma è nitido e dettagliato perché non dipende solo da quello prima, ma da una comprensione globale dell’immagine.

- La sfida: Mantenere la coerenza temporale è difficilissimo. Se l’artista scolpisce il fotogramma 1 e il fotogramma 100 separatamente, rischia che il protagonista cambi faccia nel mezzo. Qui entrano in gioco i nuovi Diffusion Transformers (come in Sora e Kling), che applicano l’attenzione non solo allo spazio (i pixel dell’immagine) ma anche al tempo, garantendo che lo “scultore” sappia che quel viso al secondo 10 è lo stesso del secondo 1.

La Triade dei Titani: Kling 3.0 vs Sora 2 vs Veo 3.1

Ed ecco il confronto che tutti aspettavano. Siamo nel 2026 e la competizione è feroce, ma le differenze sono nette. Non stiamo più parlando solo di “chi fa il video più bello”, ma di chi offre gli strumenti migliori per raccontare una storia.

Il Verdetto dell’Umanista Digitale

Mentre Sora 2 simula perfettamente come cade una mela e Veo 3.1 la riprende in 8K, Kling 3.0 ti racconta perché quella mela è caduta e chi l’ha lanciata. È il passaggio dalla tecnologia alla narrazione. Se volete fare esperimenti di fisica, usate Sora. Se volete girare un film, Kling è la vostra nuova cinepresa.

Conclusione

Siamo di fronte a un momento “Gutenberg” per il video. La barriera tecnica tra l’avere un’idea visiva e il poterla realizzare è crollata definitivamente ieri con l’arrivo di Kling 3.0. Da umanista digitale, vi invito a non vedere questo come la fine della creatività umana, ma come l’inizio di una nuova era in cui la nostra immaginazione è l’unico vero limite. Non serve più una troupe, serve solo una visione.

Approfondimenti: L’Arte del Video AI

Qual è la differenza tra Propagazione e Diffusione?

Perché Kling 3.0 è una rivoluzione rispetto a Sora?

Come posso provare Kling 3.0?

L’audio nei video AI è aggiunto dopo?

📚 La Biblioteca del Video AI

Da informatico a cercatore di senso

Unisciti al mio mondo di conoscenza e iscriviti al mio canale WhatsApp.

Sarai parte di una comunità appassionata, sempre aggiornata con i miei pensieri e le mie idee più emozionanti.

Non perderti l’opportunità di essere ispirato ogni giorno, iscriviti ora e condividi questa straordinaria avventura con me!

Nota di trasparenza sull’uso dell’AI nel blog

In questo spazio digitale, dedicato alla comprensione critica dell’innovazione tecnologica, desidero condividere con chiarezza due aspetti importanti del lavoro che porto avanti.

Immagini generate con l’AI

La quasi totalità delle immagini presenti nel blog è generata tramite strumenti di intelligenza artificiale. Le utilizzo sia come supporto visivo sia come modo per sperimentare nuove forme di comunicazione creativa, coerenti con i temi trattati.

Un blog nato dalla scrittura… e trasformato dalla velocità dell’AI

Scrivere è sempre stata una mia passione. Dopo anni di appunti, riflessioni e sperimentazioni, tre anni fa è nato questo blog. Fin da subito, però, ho dovuto confrontarmi con una sfida evidente: l’incredibile accelerazione dell’evoluzione scientifica legata all’intelligenza artificiale rende complesso mantenere aggiornato un progetto di divulgazione che ambisce alla qualità e alla precisione.

Per questo, in coerenza con la mia missione di promuovere consapevolezza, oggi più che mai un elemento vitale, ho scelto di farmi affiancare da piattaforme di AI in molte fasi del lavoro editoriale. In particolare, l’AI mi supporta in:

- ricerca e verifica preliminare delle notizie

- organizzazione e strutturazione degli articoli

- creazione di sezioni HTML per FAQ e link alle fonti

- ideazione di infografiche

- esplorazione di titoli efficaci e pertinenti

L’obiettivo non è delegare il pensiero, ma amplificare la capacità di analisi e di sintesi, così da offrire contenuti sempre più chiari, accurati e utili.