Hai bisogno di una versione PDF dell’articolo per una lettura più comoda o per conservarne una copia? Clicca sul link sottostante per scaricare il PDF direttamente sul tuo dispositivo.

Scarica l’articolo in PDF (ITA)Do you need a PDF version of the article for easier reading or to keep a copy? Click the link below to download the PDF directly to your device.

Download Article as PDF (ENG)La Limitazione degli LLM

La Questione dei Dati

Il Consumo Energetico

Dalla Lingua ai Concetti: Un Cambiamento di Paradigma

L’Architettura del Sonar Embedding

Esempi Pratici: Come Funziona?

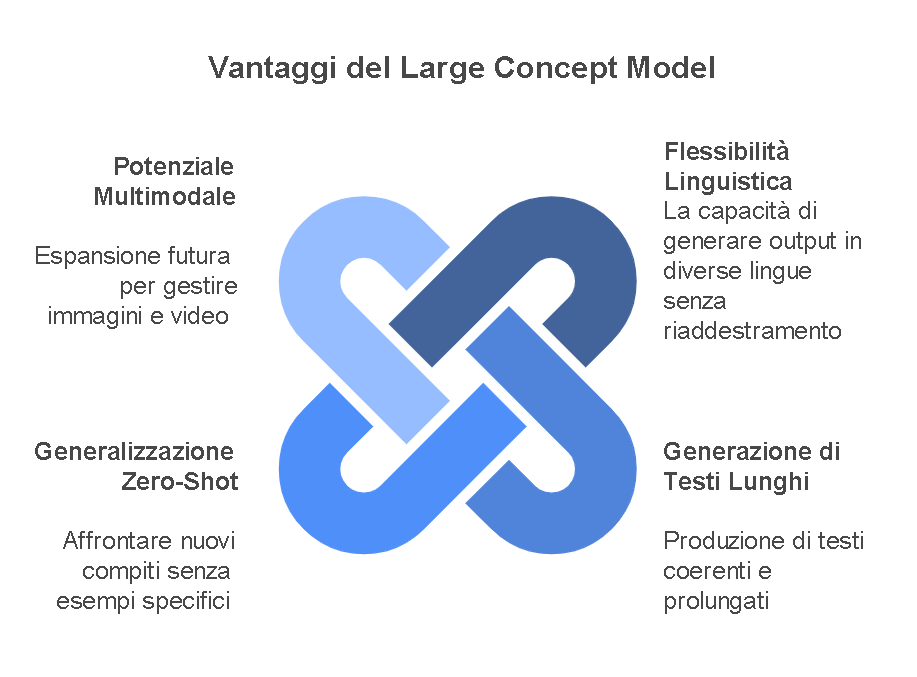

Vantaggi del Large Concept Model

Conclusioni: Un Nuovo Orizzonte per l’Intelligenza Artificiale

Recap

- 📚 Introduzione di modelli concettuali di grandi dimensioni

- Meta introduce una nuova architettura chiamata Large Concept Models (LCM), spostando l’attenzione dai tradizionali Large Language Models (LLM).

- I nuovi modelli elaborano le informazioni a un livello di astrazione più elevato, andando oltre i singoli token (parti di parole).

- 💡 Comprensione concettuale vs. token

- Gli attuali LLM analizzano gli input a livello di token, mentre gli esseri umani comprendono i concetti in modo olistico.

- Esempio: quando si prepara un discorso, ci si concentra sui temi chiave piuttosto che memorizzare ogni parola.

- 🌐 Agnostico del linguaggio e delle modalità

- I concetti nei LCM sono indipendenti dalla lingua e dalla modalità, il che significa che possono rappresentare la stessa idea in diverse lingue e formati (testo, audio).

- Ciò consente agli LCM di mantenere il significato semantico indipendentemente dallo stile di input.

- 🎤 Tecniche di incorporamento

- Viene introdotto il modello Sonar embedding, che supporta sia input testuali che audio in 200 lingue.

- Crea una rappresentazione vettoriale dei concetti, facilitando la trasformazione delle idee in uno spazio semantico comune.

- 📈 Prestazioni e scalabilità

- I test iniziali mostrano che gli LCM superano gli LLM tradizionali, anche con meno parametri (1,6 miliardi rispetto ai modelli più grandi).

- Gli LCM sono in grado di generalizzazione zero-shot, applicando efficacemente i concetti appresi a nuovi compiti senza esempi precedenti.

- 🔄 Funzionalità multimodali

- L’intenzione è quella di espandere gli LCM per gestire vari tipi di dati, tra cui immagini e video, migliorando le loro capacità multimodali.

- Gli sviluppi futuri potrebbero includere modalità aggiuntive senza la necessità di riqualificare l’intero modello.

- 📑 Ricerca e Sviluppo

- Il documento di ricerca delinea la fattibilità degli LCM e fornisce codice e modelli disponibili su GitHub.

- Lo studio indica un potenziale punto di saturazione per gli attuali LLM, suggerendo la necessità di approcci

Large Concept Models (LCM)

Il futuro dell’intelligenza artificiale

Cosa sono i Large Concept Models?

▼

Concetti Base

- Elaborazione basata su concetti

- Superamento dei limiti degli LLM

- Approccio più intuitivo

- Architettura innovativa

🧠 Modelli che pensano per concetti invece che per token

Quali vantaggi offrono rispetto agli LLM?

▼

Vantaggi

- Minor consumo energetico

- Flessibilità linguistica

- Generazione testi più coerenti

- Generalizzazione zero-shot

⚡ Più efficienti e versatili dei modelli tradizionali

Come funziona il Sonar Embedding?

▼

Tecnologia

- Supporto per 200 lingue

- Elaborazione testo e audio

- Vettorizzazione semantica

- Preservazione del significato

🌐 Trasforma input multimodali in rappresentazioni vettoriali

Quali sono le applicazioni pratiche?

▼

Applicazioni

- Presentazioni multilingua

- Articoli scientifici

- Comunicazione cross-modale

- Sintesi concettuale

💡 Ideali per comunicazione complessa e multilingue

Quale futuro per i LCM?

▼

Futuro

- Espansione multimodale

- Integrazione con immagini e video

- Miglioramento prestazioni

- Nuove applicazioni

🚀 Un nuovo paradigma per l’intelligenza artificiale

Video in Italiano

Video in Inglese

Da informatico a cercatore di senso