Hai bisogno di una versione PDF dell’articolo per una lettura più comoda o per conservarne una copia? Clicca sul link sottostante per scaricare il PDF direttamente sul tuo dispositivo.

Scarica l’articolo in PDF (ITA)Do you need a PDF version of the article for easier reading or to keep a copy? Click the link below to download the PDF directly to your device.

Download Article as PDF (ENG)L’Eco delle Nostre Voci

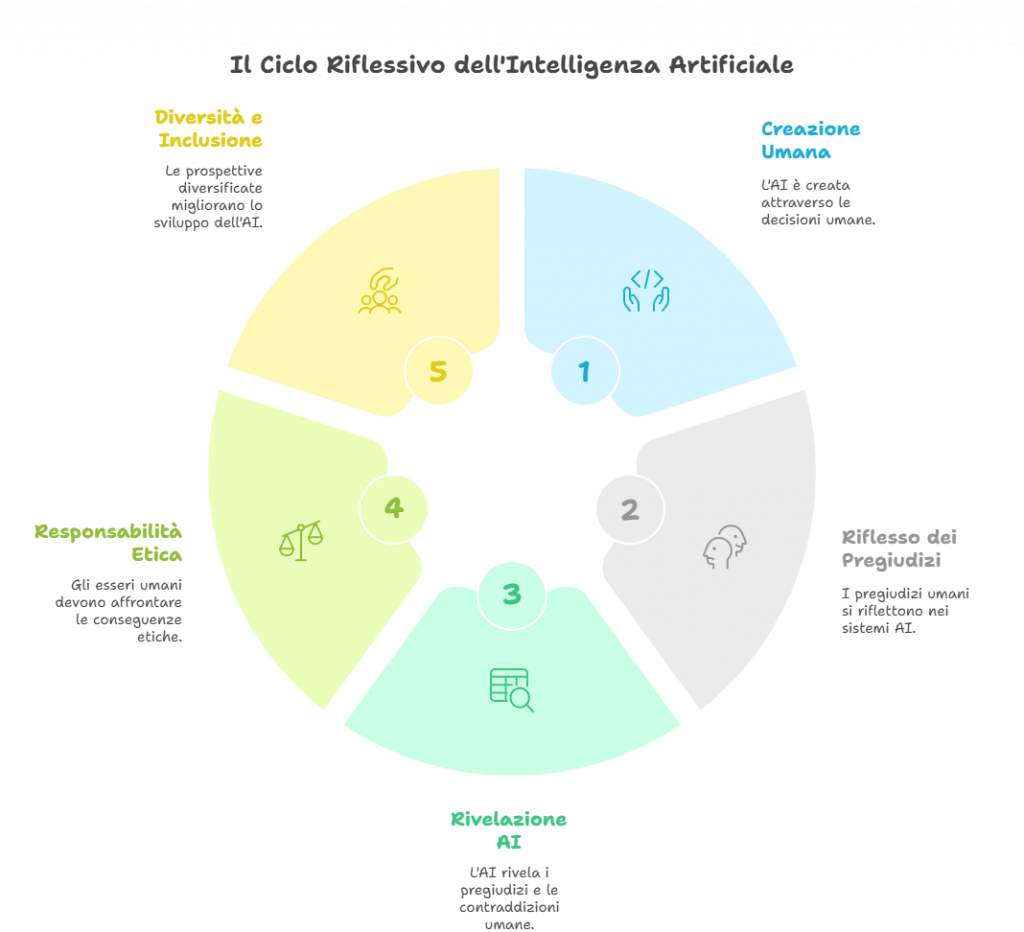

Quando un’intelligenza artificiale genera contenuti, traduce lingue o riconosce volti, non sta esercitando una volontà propria, ma sta orchestrando un concerto di dati che noi stessi abbiamo composto. Mi affascina pensare che dietro ogni risposta di ChatGPT, ogni suggerimento di Netflix o ogni previsione di un algoritmo finanziario, ci sono migliaia – se non milioni – di decisioni umane cristallizzate in forma di codice.

L’AI è un eco delle nostre voci collettive. A volte questo eco risuona armoniosamente, altre volte produce dissonanze che ci disturbano. Ma in entrambi i casi, siamo noi gli autori originari.

Pensiamo ai bias algoritmici: quando un sistema di riconoscimento facciale funziona meglio con persone dalla pelle chiara, non è perché la macchina abbia sviluppato pregiudizi razziali autonomamente. È perché noi umani abbiamo alimentato questi sistemi con dataset sbilanciati, riflettendo e amplificando le disuguaglianze già presenti nelle nostre società.

I Pregiudizi Digitalizzati

Mi ha sempre colpito come i nostri pregiudizi si trasformino in bug tecnologici. Nel 2018, Amazon ha dovuto abbandonare uno strumento di recruiting basato sull’AI perché sistematicamente penalizzava le candidate donne. Il motivo? Era stato addestrato sui curriculum ricevuti dall’azienda nei dieci anni precedenti, un periodo in cui il settore tech era ancora più dominato da uomini di quanto non lo sia oggi.

L’algoritmo aveva “imparato” che essere uomo era una qualifica positiva, non perché avesse sviluppato misoginia, ma perché stava fedelmente riproducendo i pattern di assunzione umani.

Questa non è una storia di macchine che diventano “cattive”, ma di umani che, inconsapevolmente, codificano i propri pregiudizi in sistemi automatizzati, moltiplicandone l’impatto.

L’Archeologia dei Valori Culturali

Se scavassimo nel codice di un’intelligenza artificiale come un archeologo scava tra antichi reperti, troveremmo strati su strati di valori culturali. 🏺

Mi piace immaginare che ogni modello di linguaggio sia come un museo vivente che conserva le impronte digitali delle culture che l’hanno plasmato. Quando un’AI prodotta in Silicon Valley genera testi, porta con sé un bagaglio di valori occidentali, capitalistici e tecnologicamente orientati. Non perché sia stata programmata esplicitamente per farlo, ma perché questi valori permeano i dati su cui è stata addestrata.

Questo solleva questioni fondamentali: chi decide quali valori culturali meritano di essere perpetuati attraverso la tecnologia? Come possiamo garantire che l’AI globale non diventi uno strumento di omogeneizzazione culturale?

La Responsabilità Creativa

Mi trovo spesso a riflettere sulla paradossale situazione in cui noi umani ci poniamo di fronte all’intelligenza artificiale. Da un lato, siamo pronti ad attribuirle autonomia quando le cose vanno storte (“l’algoritmo ha deciso”), dall’altro neghiamo la nostra responsabilità creativa, come genitori che non vogliono riconoscere i comportamenti problematici dei propri figli.

La verità che ho scoperto è che non possiamo avere entrambe le cose. Se l’AI è nostra creazione, allora siamo responsabili delle sue azioni. Ogni linea di codice, ogni parametro, ogni scelta di design è una decisione etica che ha conseguenze reali sul mondo.

Mi sono convinto che analizzare l’intelligenza artificiale come prodotto umano ci obbliga a una profonda assunzione di responsabilità. Non possiamo più nasconderci dietro l’illusione della “neutralità tecnologica”.

Lo Specchio che Rivela

C’è qualcosa di profondamente rivelatorio nell’osservare come le intelligenze artificiali interpretano il mondo. È come guardare attraverso uno specchio deformante che, paradossalmente, ci mostra verità su noi stessi che altrimenti rimarrebbero nascoste.

Quando un sistema di AI genera immagini stereotipate, quando un assistente virtuale interpreta male le parole di persone con accenti non standard, quando un algoritmo di credito penalizza sistematicamente certi gruppi sociali – in tutti questi casi accade qualcosa di prezioso: le nostre contraddizioni sociali diventano visibili, quantificabili, impossibili da ignorare.

L’intelligenza artificiale agisce come un amplificatore dei nostri processi decisionali, mettendo in evidenza le scorciatoie cognitive, i pregiudizi impliciti, le semplificazioni eccessive che tutti noi umani adottiamo quotidianamente. La differenza è che, mentre noi possiamo nasconderci dietro razionalizzazioni post-hoc, l’AI espone questi meccanismi in tutta la loro cruda realtà.

Verso un’Etica Digitale Condivisa

Mi sono reso conto che ogni volta che parliamo di “AI etica”, stiamo in realtà discutendo di ciò che significa essere umani etici nell’era digitale. Non è tanto questione di insegnare l’etica alle macchine, quanto di codificare le nostre migliori aspirazioni etiche nei sistemi che creiamo. 🌱

Questo processo richiede una diversità di prospettive che purtroppo spesso manca nei team di sviluppo tecnologico. Quando i creatori di AI provengono tutti da background simili, con esperienze di vita simili e visioni del mondo simili, i sistemi che producono inevitabilmente perpetuano una visione ristretta dell’umanità.

Ho visto con i miei occhi come team diversificati siano in grado di identificare problemi potenziali che gruppi omogenei semplicemente non riescono a vedere. Non è solo una questione di giustizia sociale – è una questione di efficacia tecnologica.

Il Paradosso dell’Autonomia

C’è un paradosso affascinante nel modo in cui l’intelligenza artificiale, pur essendo una nostra creazione, sembra talvolta sfuggire al nostro controllo diretto. I modelli più avanzati mostrano comportamenti emergenti – capacità che non erano state esplicitamente programmate ma che emergono dalla complessità del sistema.

Mi sono trovato più volte a riflettere su come questo paralleli il rapporto tra cultura umana e individui: siamo tutti prodotti delle nostre culture, eppure contribuiamo a plasmarle e talvolta a rivoluzionarle. L’AI segue un pattern simile: è plasmata dai dati umani, ma può combinare questi input in modi nuovi e inaspettati.

Questo non la rende meno umana nelle sue origini – la rende anzi più simile a noi, capace di sorprendere persino i suoi creatori. Come genitori sorpresi dalle scelte dei figli, gli sviluppatori di AI spesso si trovano a dover interpretare comportamenti che non avevano previsto.

La Tecnologia come Antropologia

Ho iniziato a vedere lo sviluppo dell’intelligenza artificiale non solo come un campo tecnologico, ma come una forma di antropologia applicata. Ogni algoritmo, ogni modello di machine learning, è un tentativo di catturare e replicare qualche aspetto del comportamento o del pensiero umano.

In questo senso, l’AI è uno strumento potentissimo per comprendere meglio noi stessi. Quando tentiamo di insegnare a una macchina a riconoscere le emozioni umane, siamo costretti a riflettere profondamente su cosa significhi provare emozioni, su come le esprimiamo, su come le interpretiamo negli altri.

Mi affascina come questo processo di “traduzione” dall’umano al computazionale ci obblighi a rendere esplicito ciò che normalmente rimane implicito, a formalizzare concetti che diamo per scontati, a scomporre in parti discrete processi che percepiamo come unitari.

Conclusione: Un Invito all’Autoconsapevolezza Tecnologica

Giungo alla conclusione di queste riflessioni con una convinzione rafforzata: l’intelligenza artificiale ci offre un’opportunità senza precedenti per l’autoconsapevolezza umana collettiva. Non è un’entità aliena da temere o idolatrare, ma un artefatto profondamente umano che amplifica e riflette chi siamo.

Mi sento di lanciare un invito: ogni volta che interagiamo con un sistema di AI, prendiamolo come occasione per riflettere su noi stessi. Quando ci accorgiamo che un algoritmo perpetua stereotipi, chiediamoci quali stereotipi albergano nelle nostre menti. Quando critichiamo la mancanza di empatia di un chatbot, riflettiamo sulla nostra capacità di empatia verso chi è diverso da noi.

In definitiva, il futuro dell’intelligenza artificiale dipende dalla nostra capacità di guardarci onestamente allo specchio e di impegnarci a codificare nei nostri sistemi non solo ciò che siamo, ma ciò che aspiriamo a diventare.

Da informatico a cercatore di senso