L’AI non Pensa, Agisce: Perché la Vera Rivoluzione è Capire l’Agency

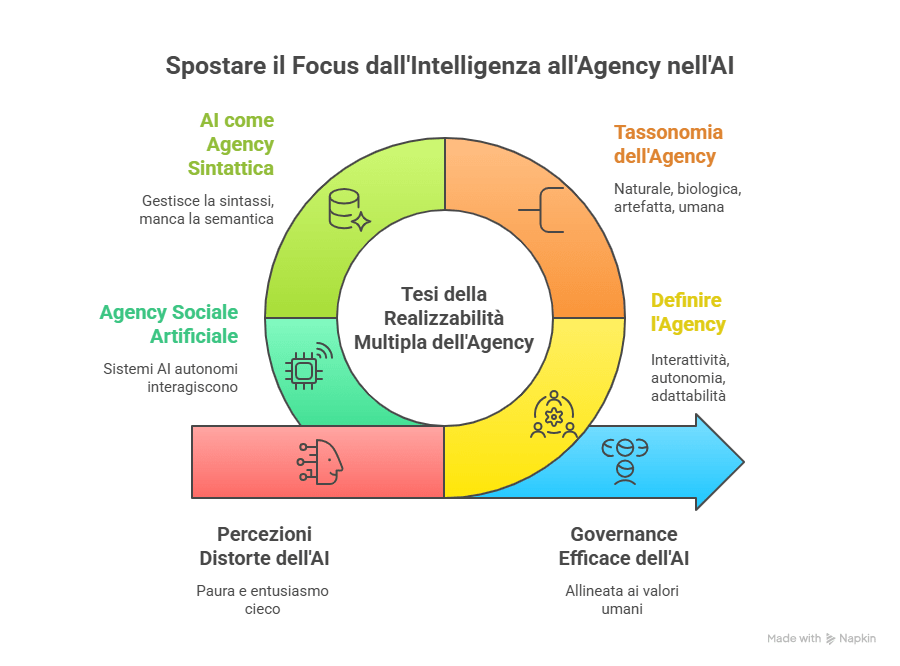

Da anni, nel mio lavoro di ingegnere informatico e, soprattutto, di umanista digitale, mi scontro con un muro. Un muro fatto di percezioni distorte. Da un lato, incontro la paura paralizzante dell’AI “senziente”, quella che ci ruberà il lavoro, ci dominerà, ci estinguerà. Dall’altro, vedo l’entusiasmo cieco per l’IA “super-intelligente”, una sorta di divinità tecnologica che risolverà ogni nostro problema.

Entrambe le posizioni, a mio avviso, nascono da un equivoco colossale. Ci stiamo ponendo la domanda sbagliata.

Ci affanniamo a chiedere: “Ma i Large Language Models capiscono davvero? Sono intelligenti? Sono coscienti?” Questa ossessione per l’intelligenza è un vicolo cieco. È un feticcio che ci porta a commettere l’errore più vecchio del mondo: l’antropomorfismo . Misuriamo tutto con il nostro metro, cercando disperatamente un riflesso di noi stessi in quegli algoritmi.

È una trappola che, come divulgatore, ho il dovere di smontare. La mia missione è trovare l’equilibrio: togliere la paura ingiustificata e, al contempo, moderare gli entusiasmi eccessivi. Per farlo, serve un cambio di paradigma.

Recentemente, mi sono immerso in un saggio illuminante del filosofo Luciano Floridi, “Artificial Intelligence as a New Form of Agency (not Intelligence)” , e ho trovato la chiave di volta che cercavo. Floridi ci offre una scelta netta: o continuiamo a espandere la nostra concezione di intelligenza per farci stare dentro, a forza, le macchine (la tesi ARI – Artificial Realisability of Intelligence), oppure, e questa è la mossa geniale, espandiamo la nostra comprensione di agency (la capacità di agire) per includere forme artificiali che non richiedono affatto cognizione, intelligenza o stati mentali .

Io sposo con convinzione la seconda via: la Tesi della Realizzabilità Multipla dell’Agency (MRA) .

Il Problema del Feticcio “Intelligenza”

Perché è così importante questo spostamento di focus? Perché, come sostiene Floridi, la tesi MRA è favorita dalla scienza, dal senso comune e persino dal rasoio di Ockham . È semplicemente la spiegazione più efficiente e accurata.

Continuare a parlare di “intelligenza” artificiale ci costringe a paragoni fuorvianti con l’intelligenza umana . Questo non solo è sbagliato, ma è anche pericoloso. Alimenta paure irrazionali (la macchina che “si risveglia”) e aspettative irrealistiche (la macchina che “ci capisce”).

Vedere l’AI come Agenzia Artificiale (AA), invece, ci libera . Ci permette di smettere di chiederci cosa pensa o prova, e di iniziare a chiederci cosa fa, come lo fa e, soprattutto, quali scopi (imposti da noi) persegue.

Ma Cos’è, Esattamente, l'”Agency”?

Se l’AI non è intelligenza, ma agency, dobbiamo definire cosa intendiamo con questo termine. Floridi, utilizzando il suo “Metodo dei Livelli di Astrazione” (un approccio rigoroso per analizzare sistemi complessi ), identifica tre criteri fondamentali per riconoscere un agente .

- Interattività: La capacità di un agente di interagire con il suo ambiente, ovvero di agire su di esso e, a sua volta, di subirne l’azione .

- Autonomia: La capacità di avviare cambiamenti di stato (azioni) in modo indipendente da una causalità esterna diretta . Non significa indipendenza assoluta, ma capacità di azione auto-iniziata.

- Adattabilità: La capacità di modificare il proprio comportamento in base agli input, ai dati o all’esperienza .

Notate qualcosa? In questa definizione non si fa menzione di coscienza, intelligenza, comprensione o intenzionalità. E qui casca l’asino. L’agency è un concetto molto più ampio dell’intelligenza.

Un Mondo Pieno di Agenti (Noi compresi)

Per costruire la sua tesi, Floridi ci accompagna in una affascinante tassonomia delle varie forme di agency che ci circondano. Questa progressione mi ha aiutato a collocare l’AI nel posto che le spetta.

- Agency Naturale (Es. un fiume): Un fiume è un agente? Certo. Ha interattività: erode le rive, trasporta sedimenti, modella la valle . Ma non ha autonomia (è mosso dalla gravità) né adattabilità (non impara) . È la forma più elementare di agency.

- Agency Biologica (Es. un cane): Qui compaiono tutti e tre i criteri. Un cane interagisce (con noi, con l’ambiente), ha autonomia (cerca cibo, decide di giocare) e adattabilità (impara comandi, si adatta alle abitudini della famiglia) .

- Agency Artefatta (Es. un termostato smart): Questo è un passo cruciale. Un termostato smart interagisce (legge la temperatura), ha autonomia (decide di accendere la caldaia) e ha adattabilità (impara le nostre abitudini per ottimizzare i consumi) . Ma c’è una differenza fondamentale: il suo scopo (riscaldare e risparmiare) è imposto dall’esterno, dal suo progettista umano .

- Agency Umana Individuale (Noi): Siamo la forma di agency naturale più avanzata . Ai tre criteri di base aggiungiamo livelli di complessità unici: coscienza, autopercezione, pensiero astratto, linguaggio simbolico, pianificazione a lungo termine e, soprattutto, agency morale . Noi non solo abbiamo scopi, ma possiamo scegliere i nostri scopi. Siamo responsabili delle nostre azioni .

Ecco l’AI: L’Agente Sintattico

Ora, armati di questa tassonomia, dove collochiamo l’Intelligenza Artificiale, come un LLM (ad esempio, GPT-4)?

Floridi la definisce una forma di agency nuova e distinta .

L’AI è un agente. Ha un’interattività complessa (dialoga con noi), un’autonomia (genera testo in modo indipendente) e un’adattabilità strabiliante, basata sull’apprendimento da quantità immense di dati .

MA (e questo è il punto che cerco di spiegare ogni giorno):

- Manca di Scopi Propri: Come il termostato, i suoi scopi sono computazionali e definiti dall’uomo . Non può “scegliere di scegliere” .

- Manca di Comprensione: La sua adattabilità è data-driven, non basata sulla comprensione del mondo. È riconoscimento di pattern statistici, non comprensione semantica .

- Manca di Coscienza e Intenzionalità: Non ha stati mentali, intelligenza (nel senso umano) o consapevolezza .

Floridi usa una definizione che trovo perfetta: l’AI è una “forma sintattica di agency” . Gestisce magnificamente la sintassi (le regole, la struttura, i pattern) ma è priva di semantica (il significato, il contesto, l’intenzione).

Capite cosa significa questo? Significa che l’AI non è un “cervello elettronico” da temere o adorare. È un agente incredibilmente potente, un esecutore scalabile e veloce , ma rimane uno strumento. Uno strumento che agisce senza capire.

Questo ridimensiona l’hype (non è un dio) e demolisce la paura (non è un demone).

Il Futuro: L’Agency Sociale Artificiale (Agentic AI)

Il saggio di Floridi non si ferma qui. Guarda al prossimo passo: l’Agency Sociale Artificiale (o Agentic AI) .

Non parliamo più di un singolo AI, ma di sistemi di agenti AI autonomi che interagiscono e si coordinano tra loro per raggiungere obiettivi complessi, con una supervisione umana minima .

Pensate a un team di agenti AI: uno pianifica un viaggio, un altro prenota i voli, un altro l’hotel, e un quarto agente monitora il traffico e modifica le prenotazioni in tempo reale, comunicando con gli altri agenti .

Qui, la mia missione di equilibrio diventa ancora più cruciale.

- L’opportunità (moderare la paura): Possiamo automatizzare processi di una complessità prima impensabile, liberando risorse umane per compiti strategici e creativi .

- Il rischio (moderare l’entusiasmo): Questi sistemi pongono sfide enormi di controllo, coordinamento e, soprattutto, responsabilità . Se un sistema di Agentic AI commette un errore catastrofico, di chi è la colpa? . Come gestiamo i bias che possono essere rinforzati e propagati a velocità inaudita? . Come evitiamo una dipendenza eccessiva che atrofizza le nostre capacità umane? .

Conclusione: L’Umano al Centro dell’Agency

Abbracciare la tesi di Floridi (la MRA) non è un mero esercizio filosofico . È il fondamento pratico per una governance efficace dell’AI.

Se smettiamo di antropomorfizzare l’AI , possiamo smettere di cercare di replicare l’intelligenza umana (un obiettivo che Floridi definisce un fallimento annunciato ). Possiamo, invece, concentrarci sullo sviluppo delle capacità agentiche uniche dell’AI: la sua precisione, la sua scalabilità, la sua riproducibilità .

Come umanista digitale, vedo questo come il nostro vero compito. Il futuro non è la creazione di una mente artificiale che ci sostituisca. Il futuro è la progettazione di agenti artificiali potenti che, guidati dalla nostra agency morale (l’unica vera intelligenza che conta), ci aiutino a risolvere problemi complessi, rimanendo allineati ai valori umani e ai bisogni della società e dell’ambiente .

L’AI non è intelligente. Ma agisce. Sta a noi, con la nostra di intelligenza, assicurarci che agisca bene.

Domande Frequenti (FAQ) sull’Agency dell’AI

Qual è la differenza chiave tra “Intelligenza” e “Agency” nell’AI?

La “Intelligenza” (come la intendiamo noi umani) implica comprensione, coscienza, intenzionalità e stati mentali. L'”Agency” (Agenzia), invece, è semplicemente la capacità di un sistema di agire, interagire con il suo ambiente, avere un certo grado di autonomia e adattare il proprio comportamento per raggiungere uno scopo. L’AI eccelle nell’agency (fa cose) senza possedere intelligenza (non capisce cosa fa).

Perché è importante vedere l’AI come “Agency” e non “Intelligence”?

Vederla come “agency” ci libera da due errori. Primo, l’antropomorfismo : smettiamo di proiettare paure (l’AI che “si risveglia”) o speranze (l’AI che “ci capisce”) umane sulla macchina. Secondo, ci permette di focalizzarci sulle cose giuste: non “come pensa”, ma “cosa fa”, “come la controlliamo” e “di chi è la responsabilità”. È un approccio più pratico e sicuro per la governance.

Se l’AI non è “intelligente”, significa che non è pericolosa?

Assolutamente no. Questo è un punto cruciale. Un agente può essere estremamente potente e potenzialmente pericoloso anche senza essere intelligente. Un fiume (un agente naturale) può distruggere una città con un’inondazione. Un’AI, come agente, può compiere azioni su larga scala (es. propagare disinformazione ) con enorme efficacia, pur senza “capire” o “volere” il danno. Il pericolo non deriva dalla sua *coscienza* (inesistente ), ma dalla sua *capacità di agire* e dagli scopi (o errori) che le abbiamo dato noi.

Cosa si intende con “Agentic AI” o Agency Sociale Artificiale?

Si riferisce al prossimo passo: non più un singolo modello AI, ma sistemi composti da *molti* agenti AI autonomi che interagiscono, comunicano e si coordinano tra loro per raggiungere un obiettivo complesso, spesso con una supervisione umana minima. Pensa a un team di bot che pianificano un’intera catena logistica in autonomia.

Qual è il ruolo dell’umano, se l’AI è un agente “sintattico”?

Il nostro ruolo diventa ancora più centrale. Se l’AI è un agente “sintattico” (segue le regole) ma privo di “semantica” (non capisce il significato ), noi diventiamo l’unica fonte di semantica, etica e scopo. L’umano è colui che *sceglie gli scopi* , che definisce i valori, e che si assume la responsabilità morale finale per le azioni di questi potenti agenti.

Da informatico a cercatore di senso