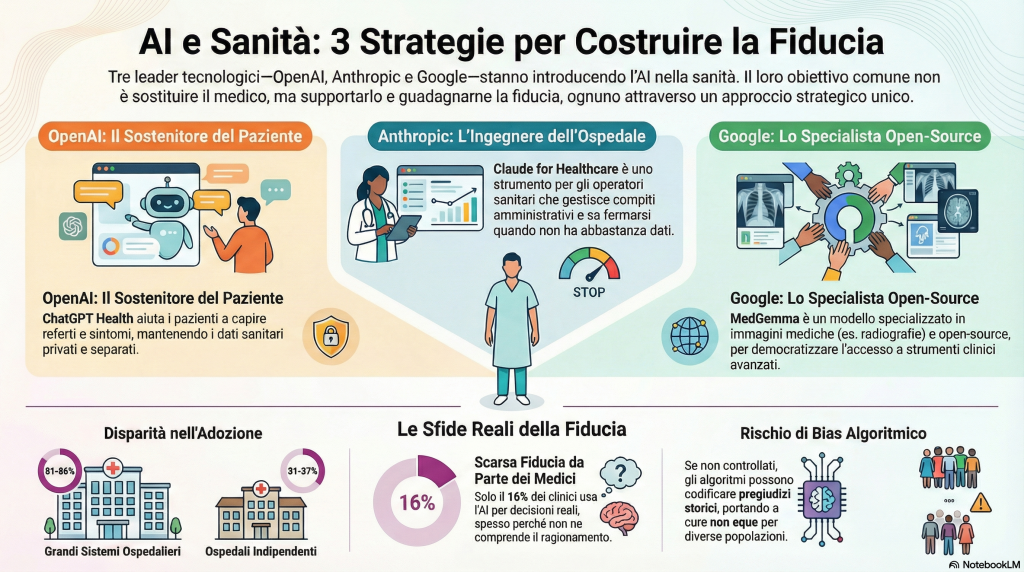

La Divergenza Strategica: Tre Visioni della Sanità Digitale

Quello che noto, come ingegnere e umanista digitale, è che le tre aziende hanno compreso una verità fondamentale: in medicina, la taglia unica non esiste. Così come un medico generico non può sostituire uno specialista, e uno specialista non può gestire da solo un ospedale, l’AI in sanità non può avere un’unica forma.

OpenAI: Il Sostenitore del Paziente

Iniziamo con ChatGPT Health, che OpenAI ha lanciato il 6 gennaio 2026. Quello che affascina è il positioning esplicito: questo non è uno strumento medico professionale. Non fa diagnosi, non prescrive, non prende decisioni cliniche. È deliberatamente un’esperienza consumer, disegnata per i cittadini, i pazienti, le persone che escono dalla visita medica e non capiscono cosa abbia detto il dottore.

ChatGPT Health promette di farti capire i tuoi sintomi (non diagnosticarli), preparare le domande per il medico, interpretare gli esami, comprendere il linguaggio medico complicato. Il tono è importante qui: non è autoritativo, è supportivo. È educativo, quasi terapeutico, nel senso che riconosce che una parte enorme dell’ansia medica nasce dall’incertezza linguistica.

Cosa la rende innovativa? La possibilità di connettere dati personali. Puoi collegare le tue cartelle cliniche digitali, le app di monitoraggio come Apple Health o MyFitnessPal, e avere conversazioni che sono effettivamente contestuali. Non ti pone domande generiche: sa il tuo storico clinico. Questo è significativo perché riconosce che la medicina moderna è data-driven, e il dato più importante è il tuo, nella tua mano, nella tua esperienza quotidiana.

Lo sviluppo dietro le quinte è impressionante: OpenAI ha lavorato con oltre 260 medici di 60 paesi per raccogliere più di 600.000 feedback su come una IA dovrebbe parlare di salute. Eppure, la loro scelta strategica più coraggiosa è di partire da un’area separata, isolata dal resto di ChatGPT. Le tue conversazioni di salute non si mescolano con le altre. I tuoi dati di salute non fluiscono negli algoritmi di training generali. È un’affermazione di principio: la salute è diversa.

Dato rilevante: OpenAI riferisce che 230 milioni di persone chiedono ogni settimana a ChatGPT domande di salute e benessere. Il problema non è scegliere se gli utenti parlano con l’AI di salute – stanno già facendo – il problema è rendere questo comportamento più sicuro, più trasparente, più informato.

Anthropic: L’Ingegnere dell’Ospedale

Claude for Healthcare, lanciato da Anthropic il 7 gennaio 2026, è il polo opposto. Qui non stiamo guardando ai pazienti – stiamo guardando all’operatore sanitario, all’ospedale, alla casa farmaceutica, al laboratorio.

Claude è stato costruito per operare dentro l’infrastruttura sanitaria: sintesi di documenti clinici massicci, analisi di ricerca biomedica, supporto ai trial clinici, drug discovery accelerato, gestione dei compiti amministrativi che divorano il tempo dei medici – come le prior authorizations e gli appeal di claims.

Quello che caratterizza Claude è ciò che Anthropic chiama il modello “prudente”: l’IA non solo evita di dare risposte troppo sicure dove c’è ambiguità, ma sa fermarsi. Sa quando non sa. Questo è cruciante in medicina, dove la mancanza di umiltà può uccidere. Un modello che dice “non ho abbastanza informazioni” è già un modello diverso da uno che indovina.

La struttura aziendale lo riflette: Claude for Healthcare è HIPAA-ready, il che significa pronto per ospedali e sistemi sanitari regolati. Non è consumer-facing. È infrastruttura.

E già vediamo partner importanti: Sanofi usa Claude quotidianamente nel suo team di innovazione. Veeva, che gestisce dati farmaceutici, ha costruito un sistema agentico dove Claude dialoga con i dataset clinici. Broad Institute usa Claude per esplorare scienze biologiche a scale che fino a ieri erano impossibili.

Google: Lo Specialista della Visione

MedGemma di Google è una storia diversa ancora. Annunciato a luglio 2025, è il primo modello AI medico di livello clinico ad essere veramente open-source.

Google ha capito qualcosa di importante: certi problemi medici sono così specializzati che modelli generici faranno sempre cilecca. Prendere Gemini e spingerlo a fare imaging medico è come usare un coltello da burro per operare chirurgicamente. Meglio creare strumenti dedicati.

MedGemma esiste in due versioni: una multimodale con 4 miliardi di parametri che capisce sia testo che immagini mediche (radiografie torace, immagini dermatologiche, sezioni istologiche), e una version pura textual con 27 miliardi di parametri che raggiunge l’87,7% di accuratezza su MedQA, il benchmark per le domande mediche specialistiche.

Cosa significa? Significa che il modello di Google può analizzare una radiografia del torace, identificare un pneumotorace, descrivere l’edema polmonare. Può guardare una lesione della pelle e riconoscere un carcinoma basocellulare. Può osservare una sezione istologica e identificare un tumore maligno al seno.

Ma il valore vero è nell’accessibilità: essendo open-source, cliniche in India, laboratori di ricerca in Africa, startup biotech in Europa possono prenderlo e adattarlo ai propri sistemi. Tap Health, in India, lo sta già usando per riassumere note mediche e generare raccomandazioni di trattamento allineate alle linee guida locali.

Questo è, per me, il contributo più potente al paradigma dell’umanesimo digitale: democratizzare strumenti clinici sofisticati verso chi ne ha più bisogno, non verso i mercati già saturi.

La Mappa dell’Adozione: Dove Siamo Veramente

Prima di addentrarci negli aspetti etici e nelle sfide, dobbiamo capire la realtà numerica del terreno. Perché le intenzioni sono belle, ma i fatti sono duri.

AI Adoption Rates Across Healthcare Segments (2024-2025)

Nel 2024, il 71% degli ospedali acuti USA usava AI predittivi integrati direttamente nelle loro cartelle cliniche elettroniche – un salto dal 66% dell’anno precedente. Questo suggerisce che l’adozione di base è già avvenuta: gli ospedali grandi stanno usando AI. Il problema? Non sono ospedali piccoli: solo il 53-59% degli ospedali piccoli (sotto 100 letti) usa AI. I grandi sistemi ospedalieri, quelli affiliati a reti multi-ospedaliere, raggiungono il 81-86% di utilizzo, mentre gli ospedali veramente indipendenti restano al 31-37%.

Questo è un segnale d’allarme per chiunque creda nell’equità sanitaria. L’AI sta creando due sistemi di sanità paralleli: uno dove la tecnologia intelligente aiuta i migliori ospedali a servire meglio i loro pazienti, e uno dove i piccoli ospedali, spesso nelle aree rurali, restano indietro.

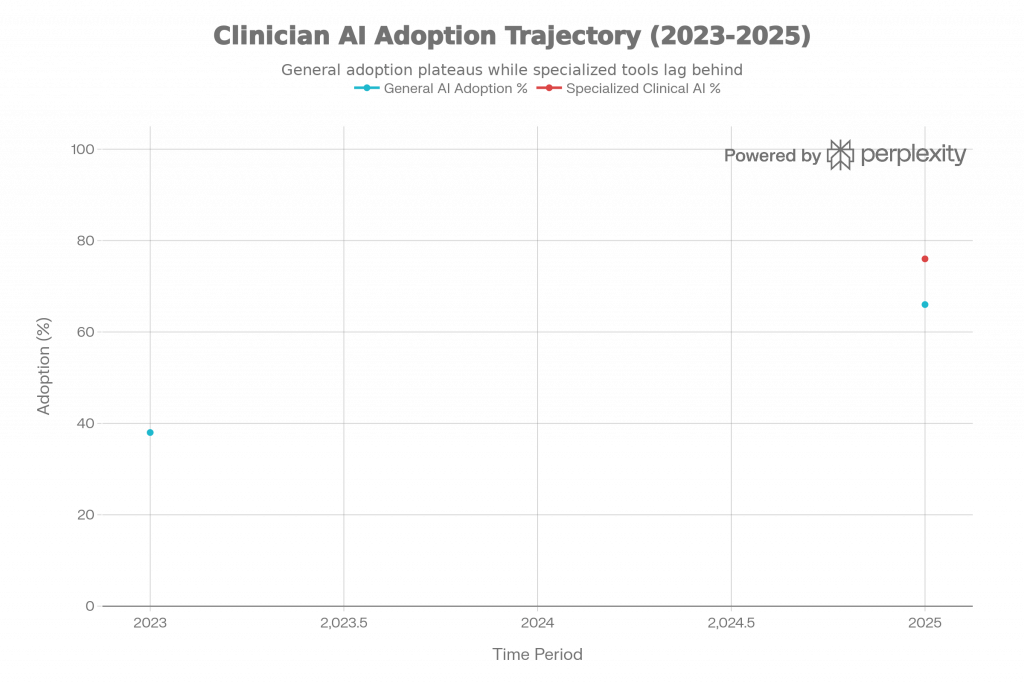

Tra gli operatori sanitari, il quadro è più frammentato. Il 48% dei clinici ha usato almeno uno strumento AI per il lavoro – una crescita drammatica dal 26% dell’anno precedente. Ma nota bene: il 97% di chi usa AI usa strumenti generici come ChatGPT, mentre solo il 76% ha mai usato AI specializzato per medicina. Questo significa che i medici stanno improvvisando – stanno prendendo strumenti costruiti per il resto del mondo e adattandoli alla medicina.

Più preoccupante ancora: solo il 16% dei clinici usa AI per decisioni cliniche effettive. Eppure il 48% vuole farlo ma non lo fa. Perché? Fiducia. Comprensione regolamentare. Paura di responsabilità. Training insufficiente.

Clinician AI Adoption Trajectory (2023-2025): From Early Adoption to Mainstream Use

Il Paradosso della Fiducia: Conosci le Risposte, ma Non Conosci il Ragionamento

Qui arriviamo al cuore della questione. L’adozione di AI in medicina non è un problema tecnico. È un problema di fiducia, e la fiducia è costruita su trasparenza, responsabilità e umiltà.

Uno studio recente ha scoperto che il 34% dei radiologi ignora o bypassa i consigli di AI, anche quando corretti, semplicemente perché non capiscono come l’AI è arrivata a quella conclusione. Un’altra ricerca ha dimostrato che quando a clinici viene fornita un’spiegazione errata di una decisione AI, la loro accuratezza diagnostica crolla dal 92,8% al 23,6% – un effetto definito “automation bias”. Hanno iniziato a fidarsi della macchina piuttosto che del loro giudizio.

Il fatto è questo: un modello AI che dice “è il 94.5% accurato” non ti dice nulla se, nella tua popolazione, quell’accuratezza crolla al 75% perché gli algoritmi sono stati addestrati principalmente su immagini di pazienti europei. Se il tuo paziente è di pelle scura e il melanoma detection è stato addestrato su foto di pelle chiara, gli errori aumentano statisticamente.

Questo non è un dettaglio tecnico. Questo è una questione di equità medica. C’è stato un caso famoso dove gli algoritmi di valutazione del rischio ospedaliero assegnavano risk score più bassi ai pazienti neri rispetto ai bianchi, purché il modello usasse i costi sanitari precedenti come proxy per la severità della malattia. Il risultato? I pazienti neri non venivano indirizzati verso i programmi di cura intensiva di cui avevano bisogno. Quando i ricercatori hanno ricalibrato l’algoritmo per usare indicatori di salute diretti invece di costi, l’iscrizione di pazienti neri ad alto rischio è salita dal 17,7% al 46,5%.

Questo è quello che accade quando fiducia e trasparenza non sono costruite correttamente: i bias storici vengono codificati in silicio.

Come i Tre Approcci Risolvono il Problema della Fiducia

Ecco dove vediamo le strategie divergenti diventare significative:

OpenAI: Fiducia attraverso Trasparenza del Paziente

ChatGPT Health risolve il problema della fiducia ricordando che il paziente è il proprietario dei propri dati. Se connetti le tue cartelle cliniche a ChatGPT Health, sai esattamente quali informazioni stai condividendo e come vengono usate. Le conversazioni sulla salute restano separate. Non alimentano i modelli di training. Eri tu a controllare cosa ChatGPT vede.

Questo è, nella mia visione umanista digitale, il riconoscimento che il potere informativo deve rimanere con la persona. L’AI è uno strumento di empowerment solo quando la persona capisce e controlla come è usata.

OpenAI ha anche deliberatamente scelto di non certificare ChatGPT Health come uno strumento medico professionale. Questo suona strano – perché non vantare il valore clinico? – ma è brillante dal punto di vista della responsabilità. Dice: “Non siamo medici. Non stiamo praticando medicina. Stiamo aiutando una persona a capire”. E questo posizionamento riduce drammaticamente il rischio legale e la responsabilità eccessiva.

Anthropic: Fiducia attraverso Prudenza Ragionata

Claude for Healthcare risolve il problema della fiducia attraverso ciò che potremmo chiamare “fiducia negativa”: il modello sa di non fidarsi di se stesso in certi momenti. Dice “non ho abbastanza informazioni” piuttosto che spingersi oltre l’incertezza.

Inoltre, Claude è stato costruito con quello che Anthropic chiama “constitutional AI” – una serie di principi che guidano come il modello ragiona. Per la medicina, questo significa ragionamento passo-dopo-passo, spiegazione del “come” oltre che del “cosa”, integrazione con flussi clinici regolati.

C’è un dettaglio importante: Anthropic ha insistito sul fatto che i dati di salute degli utenti non vengono mai usati per addestrare il modello. Punto. Questo è una promessa di fiducia: sei protetto dal machine learning predatorio.

Google: Fiducia attraverso Specializzazione

MedGemma risolve il problema della fiducia attraverso l’umiltà della specializzazione. Non cerca di essere all’altezza di tutto. Non è un medico generalista, è un radiologo, un dermatologo, un patologo. Quando usi uno strumento specializzato, sai che è stato ottimizzato per quel compito.

E rendendo il modello open-source, Google sta dicendo: “Ispeziona questo, verifica le decisioni, integralo nei tuoi processi, non dipendere dalla nostra autorità”. È una forma di fiducia distribuita, dove il controllo rimane presso le istituzioni locali.

Il Paradosso della Relazione Medico-Paziente

Mi fermo qui per sottolineare qualcosa che i giornalisti spesso tralasciano: l’arrivo dell’AI in medicina sta trasformando la relazione medico-paziente in modo sottile e profondo.

Fino a ieri, era una relazione diadica: paziente e medico. Due persone, uno scambio di informazioni, una decisione. Oggi sta diventando triadica: paziente, AI e medico.

Non è necessariamente male. Uno studio recente ha scoperto che i pazienti che usano ChatGPT prima di una visita medica arrivano alla consultazione meglio preparati, pongono domande più intelligenti, si sentono più empowered nel negoziare il proprio trattamento. I medici notano che questi pazienti comprendono meglio le loro condizioni. E talvolta, raramente, il paziente porta un suggerimento dall’AI che il medico non aveva considerato.

Ma c’è un rischio: la fiducia cieca nel chatbot. Un caso recente di una paziente che è stata dimessa da un ospedale “contro il consiglio medico” perché il relativo di fiducia preferiva il piano di trattamento di ChatGPT a quello dei medici. Questo è l’opposto di ciò che vogliamo.

Il vero equilibrio, credo, stia nella relazione mediata ma onesta: l’AI è uno strumento che il paziente e il medico usano insieme. Non è un esperto indipendente. È uno specchio che riflette le informazioni disponibili, che aiuta a porre domande, che riduce il caos informativo.

I Numeri Della Crisi: Dove l’AI Fa Ancora Errori

Devo essere onesto sui limiti. L’entusiasmo intorno all’AI in medicina spesso maschera una realtà scomoda: gli algoritmi faticano ancora enormemente.

Una meta-analisi di 83 studi sulla performance diagnostica di AI ha rivelato un’accuratezza diagnostica complessiva del 52,1% – non significativamente migliore di quella di medici non esperti, e significativamente peggiore di quella di esperti. Quando le immagini mediche sono di qualità scadente – artefatti, bassa risoluzione – gli algoritmi spesso falliscono. Nel diabetic retinopathy screening, fino al 20% delle immagini fundus sono illeggibili dagli algoritmi, richiedendo revisione manuale.

Il dropout di performance dal laboratorio al mondo reale è drammatico: algoritmi che raggiungono il 94.5% di accuratezza in condizioni di laboratorio spesso precipitano al 65-75% in ospedali reali.

Perché? Distribuzioni dei dati diverse, qualità dell’imaging variabile, pazienti che non rispecchiano i dataset di addestramento, integrazione tecnica insufficiente nei flussi clinici reali.

Il dato che dovrebbe spaventare chiunque crede nel sogno dell’AI autosufficiente: quando clinici ricevono spiegazioni scadenti dalle macchine, iniziano a fidarsi meno di se stessi e più della macchina, riducendo paradossalmente la loro accuratezza.

Il Carico Normativo: Cosa Sta Accadendo a Livello Politico

Nel dicembre 2025, EMA e FDA hanno pubblicato 10 principi condivisi per l’uso dell’AI nel ciclo di vita dei farmaci. È un segnale importante: anche i regolatori capiscono che l’AI è arrivata e devono fornire framework chiari.

La FDA ha pubblicato linee guida per l’uso dell’AI nelle decisioni regolatorie. L’Europa, attraverso l’AI Act, ha stabilito che i sistemi AI usati in medicina sono “high-risk” e richiedono documentazione estensiva, audit, explainability.

Questo è buono – significa che non è il far west – ma è anche lento. Molte organizzazioni stanno muovendosi più velocemente che i quadri normativi possono inseguire. Questo crea una zona grigia dove innovazione e responsabilità giuridica sono in tensione.

Perché la Sanità è il Banco di Prova Definitivo

Qui arriviamo all’insight strategico finale: la medicina è il campo di battaglia su cui l’AI deciderà se sarà una tecnologia di cui possiamo fidarci, o solo un’altra forma di automazione che concentra il potere.

Se i modelli di AI riusciranno a guadagnare fiducia in medicina, dove gli errori hanno conseguenze letterali sulla vita umana, avranno provato qualcosa di profondo. Avranno dimostrato che è possibile costruire sistemi automatizzati che sono trasparenti, responsabili, equi e orientati verso il bene collettivo.

Se falliranno, se gli errori di bias continueranno, se la responsabilità resterà ambigua, allora avremo insegnato una lezione terribile: che l’AI è troppo potente per essere controllata dalle istituzioni pubbliche, e probabilmente finirà in mani private che la orienteranno secondo i propri interessi.

Questo è il motivo per cui il settore sanitario avanza più lentamente e silenziosamente rispetto alla consumer AI. Non perché i progressi siano minori – sono enormi. Ma perché i rischi e le responsabilità sono incommensurabili.

Cosa Significa per Te, Oggi

Se stai leggendo questo come paziente: ChatGPT Health potrebbe aiutarti a capire i tuoi referti medici, a prepararti meglio per le visite, a ridurre l’ansia nell’ignoranza. Ma non sostituisce un medico. Usalo come strumento di empowerment informativo, non come fonte di verità medica.

Se stai leggendo come medico: Claude for Healthcare e MedGemma rappresentano l’opportunità di recuperare tempo dalle attività amministrative e dirigerlo verso il paziente. Ma richiede addestramento, cautela, e il mantenimento della tua autorità clinica. Tu resti responsabile. L’AI è uno strumento, non un collega.

Se stai leggendo come ricercatore biomedico: MedGemma open-source significa che hai accesso a uno strumento di prim’ordine per analizzare dati clinici, generare ipotesi, accelerare drug discovery. Il vincolo non è più il costo o l’accesso proprietario. È la tua capacità di pensare in modo critico a come usarlo responsabilmente.

Conclusione: La Medicina Intelligente, Umana, e Cauta

Siamo a un punto di inflessione. Non è il momento dell’IA che “sostituisce i medici” – quella narrativa è finita, fortunatamente. È il momento dell’IA che supporta, che riduce il carico amministrativo, che democratizza l’accesso all’informazione medica specializzata, che aiuta i pazienti a comprendere se stessi.

Ma questo richiede che manteniamo costante pressione verso la trasparenza, l’equità, la responsabilità.

Le tre aziende che abbiamo analizzato – OpenAI con il suo focus sul paziente, Anthropic con la sua infrastruttura clinica cauta, Google con la sua specializzazione open-source – hanno riconosciuto che la fiducia non è un dato di fatto, è qualcosa che si costruisce attraverso umiltà, trasparenza e dedizione al bene del paziente.

Se riusciranno a mantenerlo, avremo una rivoluzione sanitaria vera. Se cederanno alla pressione commerciale di spingersi oltre la loro capacità, avremo un disastro.

L’umanesimo digitale significa che la tecnologia serve l’umano, non il contrario. In medicina, questo significato diventa letterale e urgente.

🔬 Cosa fa ChatGPT Health che un semplice chatbot non fa?

ChatGPT Health è diverso da una conversazione generica perché: (1) integra i tuoi dati personali di salute (cartelle cliniche, app di monitoraggio), (2) le conversazioni sono isolate e private, non fluiscono nei dati di training, (3) è stato sviluppato con 260+ medici di 60 paesi che hanno fornito 600.000+ feedback, (4) ha un tono deliberatamente educativo e di supporto, non diagnostico o prescrittivo. Non è uno strumento medico certificato – è uno strumento di comprensione personale.⚕️ Claude for Healthcare è già usato negli ospedali?

Sì, già oggi. Partner come Sanofi usano Claude quotidianamente per l’innovazione medica. Veeva l’ha integrato nei flussi di dati clinici e regolatori. Broad Institute usa Claude per la ricerca biologica a scale nuove. È costruito con compliance HIPAA completo, il che significa è pronto per ospedali e sistemi sanitari regolati. Ma l’adozione rimarrà limitata ai grandi sistemi per alcuni anni ancora a causa dei costi e dei requisiti di integrazione.🖼️ MedGemma può davvero riconoscere malattie dalle immagini mediche?

Sì, ma con limitazioni importanti. MedGemma 4B (multimodale) può analizzare radiografie del torace e identificare condizioni come pneumotorace o edema polmonare, può guardare lesioni della pelle e riconoscere carcinomi basocellulari, può analizzare sezioni istologiche. Raggiunge l’87,7% di accuratezza su benchmark medici standard (MedQA). Ma il valore reale è nell’accessibilità: essendo open-source, cliniche in paesi a basso reddito possono usarlo senza pagare licenze alle aziende tech.🚨 Quali sono i principali rischi dell’AI in medicina oggi?

I principali rischi sono: (1) Bias negli algoritmi – quando i modelli sono addestrati su dati non rappresentativi, faticano su minoranze e popolazioni sottorappresentate, (2) Opacità e mancanza di spiegabilità – molti algoritmi non possono spiegare perché hanno preso una decisione, (3) Fiducia cieca – clinici che ignorano il loro giudizio e seguono la macchina, (4) Responsabilità ambigua – non è chiaro chi è responsabile se l’AI commette un errore, (5) Disuguaglianze nel deployment – gli ospedali ricchi adottano AI, quelli poveri rimangono indietro.📊 Quanti medici usano AI per le decisioni cliniche?

Solo il 16% dei clinici usa AI per decisioni cliniche effettive. Ma il 48% vuole usarla e non lo fa. Il 97% di chi usa AI usa strumenti generici come ChatGPT, mentre solo il 76% ha usato specializzato AI medico. Questo suggerisce che i medici stanno improvvisando – adattando strumenti non-medici alla medicina. L’adozione di AI specializzato per medicina è ancora agli inizi, principalmente per questioni di fiducia, training insufficiente, e chiarimento normativo.💡 Il paziente dovrebbe fidarsi di ChatGPT Health come di un medico?

No. ChatGPT Health non è un medico e non ha la qualifica medica di uno. Dovrebbe essere usato come uno strumento di empowerment informativo: ti aiuta a capire i tuoi referti, a prepararti meglio per le visite, a ridurre l’ansia nell’ignoranza. Ma non diagnostica, non prescrive, non prende decisioni cliniche. La relazione con il tuo medico rimane il fondamento. ChatGPT Health è uno strato informativo sopra quella relazione, non un sostituto.🌍 L’AI in medicina aiuterà la sanità in paesi a basso reddito?

Potenzialmente sì, ma non automaticamente. MedGemma open-source democratizza l’accesso a strumenti di imaging diagnostico e analisi clinica. Aziende come Tap Health in India lo stanno già usando per riassumere cartelle cliniche e generare raccomandazioni di trattamento. Ma il vero beneficio dipenderà da: (1) infrastrutture dati locali, (2) training clinico su come usare questi strumenti, (3) adattamento dei modelli ai contesti locali, (4) decisioni politiche di rendere questi strumenti accessibili piuttosto che privati.Fonti per approfondire

Una selezione ragionata di risorse per esplorare il ruolo di ChatGPT Health, Claude e MedGemma in sanità, con particolare attenzione a contributi in lingua italiana e al tema della fiducia nell’intelligenza artificiale.

ChatGPT Health e OpenAI in sanità

- Ti presentiamo ChatGPT Salute (OpenAI, pagina ufficiale) Presentazione dell’area dedicata alla salute, ruolo di supporto e non sostitutivo del medico, integrazione con cartelle cliniche e app di benessere. [web:1]

- OpenAI per il settore sanitario Panoramica sulle applicazioni cliniche e infrastrutturali di ChatGPT in ambito sanitario, con focus su flussi di lavoro, ricerca e sicurezza. [web:8]

- ChatGPT Health, la nuova area dedicata alla salute (Dica33) Articolo divulgativo in italiano sulle funzionalità pratiche di ChatGPT Health per utenti e professionisti. [web:51]

- ChatGPT Health: l’assistente AI dedicato alla salute (Informatori.it) Focus su integrazione dei dati clinici, privacy e confini d’uso non diagnostico dell’assistente. [web:49]

- ChatGPT Health? Curare non è solo calcolare (Avvenire) Riflessione etica sul rapporto tra cura, calcolo algoritmico ed empatia nel contesto di ChatGPT Health. [web:53]

Claude for Healthcare e l’ecosistema Anthropic

- Advancing Claude in healthcare and the life sciences (Anthropic, pagina ufficiale) Descrizione dell’offerta Claude per ospedali, assicurazioni e life sciences: sintesi documentale, trial clinici, drug discovery. [web:6]

- Claude for Healthcare: l’IA di Anthropic sfida OpenAI (Roberto Serra) Analisi in italiano sul posizionamento di Claude in sanità, prestazioni del modello Opus 4.5 e casi d’uso aziendali. [web:50]

- Anche Claude entra in sanità: l’IA accelera cure e trial (Oss in Reparto) Panoramica sulle applicazioni di Claude per autorizzazioni, cartelle cliniche, trial clinici e interazione con autorità regolatorie. [web:52]

- Anthropic lancia Claude for Healthcare (Ninja Marketing) Articolo che riassume le funzionalità sanitarie di Claude, con focus su privacy, sicurezza e connector ai database clinici. [web:56]

MedGemma, Google DeepMind e modelli medici verticali

- MedGemma: i modelli AI di Google in ambito medico (DataMasters) Approfondimento tecnico in italiano su versioni del modello, performance su MedQA, analisi di immagini e casi d’uso clinici. [web:12]

- MedGemma: l’IA open source di Google trasforma la medicina (Acta Non Verba) Articolo divulgativo su potenzialità, limiti clinici, impatto su ricerca, diagnostica e flussi di lavoro ospedalieri. [web:7]

- MedGemma: l’IA di Google DeepMind al servizio della medicina del futuro Focus su capacità multimodali, imaging medico e prospettive per la medicina di precisione. [web:14]

- MedGemma: la rivoluzione dell’AI medica è appena iniziata (LinkedIn Pulse) Commento di taglio professionale sul ruolo di MedGemma dopo Med-PaLM e Med-Gemini, con riflessioni su open source e ricerca. [web:55]

Fiducia, etica e regolamentazione dell’AI in sanità

- Building trust in healthcare AI – Future Health Index 2025 Report internazionale su fiducia, adozione e barriere percepite dagli operatori sanitari rispetto all’AI. [web:17]

- Piano di lavoro delle autorità regolatorie europee per dati e intelligenza artificiale (AIFA, EMA/HMA) Documento quadro europeo su governance di dati e AI nel settore dei farmaci e della regolazione sanitaria. [web:27]

- Farmaci: la FDA propone linee guida sull’uso dell’AI nello sviluppo dei medicinali Sintesi in italiano delle prime linee guida FDA su AI, sperimentazione e valutazione dei farmaci. [web:24]

- Toward Fairness, Accountability, Transparency, and Ethics in AI for Health (JMIR) Riferimento accademico sui principi di equità, accountability e trasparenza nell’uso dell’AI in sanità. [web:40]

Da informatico a cercatore di senso

Unisciti al mio mondo di conoscenza e iscriviti al mio canale WhatsApp.

Sarai parte di una comunità appassionata, sempre aggiornata con i miei pensieri e le mie idee più emozionanti.

Non perderti l’opportunità di essere ispirato ogni giorno, iscriviti ora e condividi questa straordinaria avventura con me!

Nota di trasparenza sull’uso dell’AI nel blog

In questo spazio digitale, dedicato alla comprensione critica dell’innovazione tecnologica, desidero condividere con chiarezza due aspetti importanti del lavoro che porto avanti.

Immagini generate con l’AI

La quasi totalità delle immagini presenti nel blog è generata tramite strumenti di intelligenza artificiale. Le utilizzo sia come supporto visivo sia come modo per sperimentare nuove forme di comunicazione creativa, coerenti con i temi trattati.

Un blog nato dalla scrittura… e trasformato dalla velocità dell’AI

Scrivere è sempre stata una mia passione. Dopo anni di appunti, riflessioni e sperimentazioni, tre anni fa è nato questo blog. Fin da subito, però, ho dovuto confrontarmi con una sfida evidente: l’incredibile accelerazione dell’evoluzione scientifica legata all’intelligenza artificiale rende complesso mantenere aggiornato un progetto di divulgazione che ambisce alla qualità e alla precisione.

Per questo, in coerenza con la mia missione di promuovere consapevolezza, oggi più che mai un elemento vitale, ho scelto di farmi affiancare da piattaforme di AI in molte fasi del lavoro editoriale. In particolare, l’AI mi supporta in:

- ricerca e verifica preliminare delle notizie

- organizzazione e strutturazione degli articoli

- creazione di sezioni HTML per FAQ e link alle fonti

- ideazione di infografiche

- esplorazione di titoli efficaci e pertinenti

L’obiettivo non è delegare il pensiero, ma amplificare la capacità di analisi e di sintesi, così da offrire contenuti sempre più chiari, accurati e utili.