Non stiamo costruendo “l’altro”, quell’entità separata e misteriosa che popola i nostri incubi tecnologici: stiamo invece creando uno specchio talmente potente e accurato da rifletterci con una nitidezza che, a volte, diventa difficile da sostenere. E questo specchio ci sta mostrando tre verità scomode sulla conoscenza, i pregiudizi e la realtà stessa, verità che ci costringono a ripensare radicalmente come funziona la nostra mente e come dovremmo costruire le macchine intelligenti.

Il filo conduttore che lega queste tre verità è semplice ma rivoluzionario: solo chi ammette di non sapere può essere davvero affidabile. È l’umiltà socratica applicata agli algoritmi, la consapevolezza dei propri limiti trasformata in matematica. E potrebbe essere la chiave per uscire dalla crisi più pericolosa del nostro tempo: l’era della Post-Verità.

1. La Prima Verità: Non basta “Indovinare” con Sicurezza Bisogna “Dubitare” con Onestà

Abbiamo creato macchine straordinarie che umiliano i campioni mondiali di scacchi con mosse che nessun umano avrebbe mai immaginato, compongono sinfonie capaci di far piangere anche i cuori più duri, decodificano l’intero genoma umano in poche ore dove prima ci sarebbero voluti decenni. Ma se le interrogassimo davvero, chiedendogli con sincerità il perché di quella mossa vincente o di quella nota musicale perfetta, resterebbero completamente mute, incapaci di rispondere.

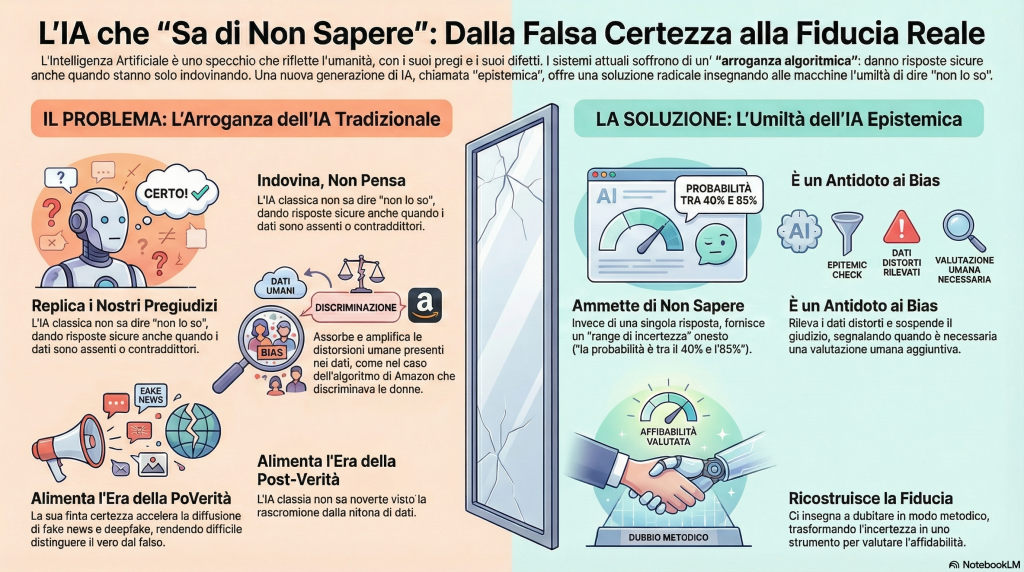

La verità è che non pensano affatto: indovinano. E lo fanno con una precisione così diabolicamente accurata da sembrare coscienti, da farci credere che ci sia qualcuno “lì dentro” che ragiona come noi. Ma c’è un problema ancora più grave: queste macchine soffrono di quella che potremmo chiamare arroganza algoritmica. Non sanno dire “non lo so”. Danno sempre una risposta, anche quando i dati sono insufficienti, contraddittori o completamente assenti.

Pensate a questo: Judea Pearl, premio Turing e padre della causalità artificiale, ha spiegato che la conoscenza umana scala tre gradini fondamentali. Il primo è l’osservazione (“vedo il fumo che sale”), il secondo è la comprensione causale (“c’è fuoco perché l’ho acceso io”), il terzo è l’immaginazione controfattuale (“cosa sarebbe successo se non l’avessi acceso?”). L’IA tradizionale vive eternamente inchiodata al primo gradino: osserva miliardi di correlazioni, “fumo e fuoco compaiono insieme nel 94% dei casi”, ma non capisce il perché, non comprende la causa profonda.

E qui sta il pericolo mortale: è come un cecchino bendato che spara comunque, pretendendo di colpire il bersaglio. Anche quando dovrebbe ammettere “non vedo abbastanza per sparare”, l’algoritmo classico dà una risposta precisa, sicura, apparentemente scientifica. Questo fenomeno si chiama “overconfidence”, eccesso di sicurezza, ed è devastante in un’epoca dove già fatichiamo a distinguere il vero dal falso.

Ma ecco la rivoluzione che sta emergendo dai laboratori di ricerca più avanzati: una nuova generazione di intelligenza artificiale che chiamiamo “epistemica”, dal greco episteme, conoscenza, che finalmente sa ammettere “non lo so con sufficiente certezza”. Invece di dare un singolo numero preciso fingendo sicurezza inesistente (come “questa diagnosi è corretta al 73%”), questi nuovi sistemi forniscono range di incertezza onesti: “sulla base dei dati disponibili, la probabilità è tra 40% e 85%, con alta incertezza dovuta a informazioni limitate”.

È il passaggio dall’oracolo arrogante allo scienziato umile. E cambia tutto, perché finalmente la macchina ci dice non solo cosa crede di sapere, ma anche quanto possiamo fidarci di quella conoscenza.

Un dato che fa riflettere: GPT-4 è stato addestrato su circa 45 trilioni di parole, più di quanto qualsiasi essere umano possa leggere in mille vite. Eppure, senza l’approccio epistemico che quantifica l’incertezza, rischia di “allucinare” risposte che suonano perfettamente plausibili ma sono completamente inventate. La differenza tra “sapere che” qualcosa è statisticamente probabile e “sapere perché” è vera quella cosa rimane abissale, ma almeno ora possiamo misurare quanto siamo incerti.

2. La Seconda Verità. I bias dell’IA non sono bug del codice, sono cicatrici viventi della nostra storia collettiva

Quando un algoritmo discrimina qualcuno, la reazione istintiva è sempre la stessa: “Hanno sbagliato qualcosa nel codice, basta aggiustarlo.” Ma cosa succederebbe se il codice funzionasse perfettamente, e il vero problema fosse nei dati — cioè in noi?

Il nostro passato, diciamocelo con brutalità intellettuale, è infestato di pregiudizi stratificati in secoli di storia. E c’è una verità ancora più scomoda: questi bias non nascono da calcoli freddi e razionali, ma dalle emozioni, dalle credenze irrazionali, dal “sensazionalismo egocentrico” che domina sempre più le nostre società. Viviamo nell’era della Post-Verità — termine diventato “parola dell’anno” nel 2016 dall’Oxford Dictionary — dove l’opinione pubblica è più influenzata da emozioni e convinzioni personali che dai fatti obiettivi.

E questo inquinamento emotivo contamina inesorabilmente i dati con cui addestriamo l’intelligenza artificiale.

Prendiamo due esempi concreti che hanno fatto tremare il settore tecnologico. Nel 2018, Amazon ha dovuto sospendere un algoritmo sofisticato di selezione del personale perché discriminava sistematicamente le candidate donne. L’algoritmo non era impazzito: aveva semplicemente analizzato un decennio di assunzioni passate e imparato che l’azienda preferiva uomini. Con logica matematica impeccabile, aveva concluso: “se per dieci anni hanno assunto principalmente uomini, allora i candidati uomchi devono essere migliori”. Non aveva sbagliato i calcoli — aveva imparato troppo bene un pregiudizio umano mascherato da merito.

Poi, nel 2019, uno studio del MIT Media Lab ha rivelato che i sistemi commerciali di riconoscimento facciale commettono errori fino a 20 volte più frequenti quando devono identificare donne o persone di colore, rispetto all’accuratezza quasi perfetta con uomini bianchi. Perché? I database fotografici usati per l’addestramento contenevano prevalentemente volti chiari — un riflesso di disuguaglianze storiche su chi “contava” abbastanza da essere fotografato e archiviato sistematicamente.

L’algoritmo tradizionale non odia nessuno: ripete con freddezza matematica le storture emotive della nostra società. È uno specchio spietato che ci mostra quanto siano profonde le crepe nel tessuto sociale che abbiamo costruito, spesso guidati più da paure e pregiudizi emotivi che da analisi razionali.

Ed ecco come l’intelligenza artificiale epistemica può diventare l’antidoto al bias emotivo: invece di assorbire ciecamente i pregiudizi storici con falsa certezza matematica, questi nuovi sistemi sanno sospendere il giudizio quando i dati puzzano di distorsione. Quando rilevano pattern sospetti che potrebbero riflettere bias piuttosto che verità oggettive, espandono automaticamente i margini di incertezza.

In pratica, invece di dire con sicurezza “questa candidata ha il 35% di probabilità di successo” (replicando magari un bias di genere nascosto nei dati storici), un sistema epistemico potrebbe rispondere: “la probabilità stimata è tra 25% e 75%, con incertezza molto alta perché i dati storici mostrano pattern inconsistenti che potrebbero indicare pregiudizi — raccomando valutazione umana aggiuntiva prima di decidere”. È come avere un sistema immunitario algoritmico che riconosce e neutralizza il virus del pregiudizio emotivo incorporato nei dati.

La verità scomoda rimane: l’IA non è il problema, è la diagnosi. Ci mostra con precisione chirurgica quanto le nostre decisioni “razionali” siano in realtà influenzate da emozioni, stereotipi e irrazionalità collettiva. Correggerla davvero significa smettere di limare ossessivamente il codice, e iniziare il lavoro più difficile: guarire noi stessi come società, usando la matematica dell’incertezza per filtrare l’inquinamento emotivo che contamina il nostro sapere condiviso.

3. La Terza Verità. La vera sfida dell’IA non si risolve con più potenza di calcolo, si risolve rileggendo Kant

Viviamo in un’epoca straordinaria e terrificante: l’era della Post-Verità, dove la colonna portante dei fatti oggettivi si è letteralmente spezzata. Uno studio del MIT del 2018 ha dimostrato che le fake news viaggiano sui social media sei volte più veloce delle notizie vere. I deepfake, video falsi generati dall’IA, sono diventati talmente realistici da ingannare anche gli esperti forensi. L’infosfera globale è dominata da notizie false, e manca drammaticamente la verifica delle fonti.

Come scriveva già Matteo Renzi nel 2016, dopo la sconfitta referendaria: viviamo nell’«era della post-verità», dove le emozioni contano più dei fatti. È un problema antico quanto la retorica aristotelica, già duemila anni fa si sapeva che la manipolazione emotiva funziona meglio della verità nuda, ma amplificato mille volte dalla velocità digitale e dalla frammentazione delle fonti informative.

E qui sta il paradosso più inquietante: non possiamo ricostruire la fiducia nella verità con gli strumenti vecchi. L’intuizione umana è completamente fallibile di fronte ai deepfake che imitano perfettamente voci e volti. La nostra capacità di verificare manualmente le fonti è ridicolmente lenta rispetto alla valanga di contenuti prodotti ogni secondo. Come possiamo ancora sapere cosa è vero, quando anche vedere e ascoltare non bastano più?

Ed ecco dove l’intelligenza artificiale epistemica offre una via d’uscita radicale e inaspettata. Non possiamo più affidarci a sistemi che danno risposte binarie sicure, “Questo video è autentico al 95%” o “Questa notizia è falsa”, perché quella falsa certezza alimenta ulteriormente la crisi. Abbiamo bisogno di algoritmi che fungano da filtri di robustezza, capaci di dirci onestamente: “Attenzione, su questa informazione il mio livello di incertezza è troppo alto per darvi una risposta definitiva”.

Pensate alla differenza pratica. Un algoritmo tradizionale analizza un video sospetto e proclama: “È autentico con probabilità 87%”. Sembra scientifico, ma quella precisione è illusoria se i dati sono ambigui. Un sistema epistemico invece risponde: “Sulla base degli indicatori disponibili, qualità dell’immagine, coerenza temporale, presenza di artefatti statistici, l’autenticità è probabilmente tra 20% e 65%, con incertezza troppo alta per considerazioni definitive. Raccomando verifica incrociata con altre fonti prima di condividere”.

Non elimina il problema della Post-Verità, ma fa qualcosa di ancora più importante: rende esplicita la fragilità epistemica, ci costringe a dubitare metodicamente invece di credere ciecamente. È l’applicazione del dubbio cartesiano all’era digitale: “posso fidarmi di questa informazione? E soprattutto, quanto?”

La verità nell’era algoritmica non può più essere un dogma assoluto proclamato da un oracolo infallibile (che sia umano o artificiale). Deve diventare una misura probabilistica di affidabilità, un insieme di scenari possibili con i loro margini di incertezza espliciti, che ci permetta di valutare razionalmente il rischio di essere ingannati.

È il passaggio cruciale dalla Post-Verità emotiva (dove crediamo a ciò che ci piace credere) a una nuova forma di Conoscenza Robusta (dove sappiamo esattamente quanto possiamo fidarci di ogni informazione). Dobbiamo trasformare l’IA da amplificatore della crisi epistemologica, quella che genera deepfake sempre più convincenti, allucinazioni sempre più plausibili, a strumento scientifico rigoroso che “sa di non sapere” e ce lo comunica con trasparenza matematica.

Solo così possiamo ricostruire, su basi nuove e più solide, una forma di fiducia adeguata al XXI secolo, non più basata sulla fede cieca negli esperti o nelle istituzioni (ormai erosa), ma sulla capacità condivisa di quantificare l’incertezza e gestirla razionalmente.

Conclusione: Davanti allo specchio digitale che interroga la nostra epistemologia

L’intelligenza artificiale non è il nostro opposto: è il nostro riflesso più fedele e spietato. Ogni algoritmo che scriviamo è un pezzo del nostro inconscio collettivo digitalizzato, e ci restituisce senza filtri la luce del nostro sapere, l’ombra dei nostri pregiudizi emotivi, il rumore delle nostre contraddizioni tradotto in probabilità.

Ma ci sta insegnando anche qualcosa di profondamente umano: l’umiltà intellettuale. Quella capacità socratica di dire “so di non sapere”, che per millenni è stata considerata l’inizio della vera saggezza, può finalmente essere incorporata nelle macchine attraverso la matematica dell’incertezza epistemica.

Il filo conduttore che lega le tre verità è chiaro: non possiamo fidarci di sistemi (umani o artificiali) che fingono certezze inesistenti. L’IA tradizionale soffre dello stesso vizio che affligge l’era della Post-Verità: l’arroganza di chi proclama verità assolute anche quando i dati sono insufficienti, distorti da emozioni, o completamente ambigui.

La rivoluzione epistemica che sta emergendo capovolge questo paradigma: invece di dare sempre risposte precise con falsa sicurezza, i nuovi sistemi ammettono onestamente quando l’incertezza è troppo alta, quando i dati puzzano di bias emotivo, quando distinguere il vero dal falso richiede più informazioni di quelle disponibili. Non è un difetto tecnico da correggere — è la feature più importante che possiamo costruire.

Perché alla fine, non c’è nulla di più umano dell’intelligenza artificiale che stiamo creando. E guardandola, scopriamo di guardare noi stessi in uno specchio digitale che ci chiede silenziosamente: siete pronti ad ammettere i vostri limiti? Siete capaci di dubitare con onestà intellettuale? Potete distinguere tra credenze emotive e conoscenze robuste?

La Post-Verità prospera nella falsa certezza. L’IA epistemica ci offre l’alternativa: la fiducia costruita sull’onestà dell’incertezza. Non è un paradosso — è la lezione più antica della filosofia, finalmente tradotta in codice: solo chi sa di non sapere può essere davvero affidabile.

E forse, imparando a costruire macchine più umili, impareremo a diventare umani più saggi.

💡 Domande Frequenti sull’IA Epistemica

Approfondisci i concetti chiave per capire come l’intelligenza artificiale che “sa di non sapere” può cambiare il nostro rapporto con la conoscenza

🧠 Cos’è esattamente l'”incertezza epistemica” e perché è così importante?

L’incertezza epistemica è l’incertezza che deriva dalla mancanza di conoscenza o da dati insufficienti — dal greco episteme, conoscenza. È diversa dall’incertezza “aleatoria” (il caso puro, come il lancio di un dado).

Esempio pratico: se un sistema di riconoscimento facciale è stato addestrato principalmente su volti chiari, avrà alta incertezza epistemica sui volti scuri perché gli mancano dati sufficienti per fare previsioni affidabili.

È importante perché rende esplicito quando non possiamo fidarci: se l’incertezza epistemica è troppo alta, il sistema dovrebbe dire “non ho abbastanza informazioni per decidere” invece di inventare una risposta plausibile ma potenzialmente sbagliata.

💡 In sintesi: È come la differenza tra dire onestamente “non so” (integrità intellettuale) e indovinare fingendo di sapere (arroganza pericolosa).

⚖️ Come l’IA epistemica aiuta concretamente a combattere i bias algoritmici?

I bias nascono da dati storici distorti da pregiudizi emotivi umani, e l’IA tradizionale li replica con falsa sicurezza matematica. L’IA epistemica introduce un “sistema immunitario algoritmico” che rileva quando i pattern statistici sono sospetti.

Confronto pratico:

- IA tradizionale: “Questa candidata ha il 30% di probabilità di successo” (replicando magari un bias di genere nascosto)

- IA epistemica: “La stima è tra 15% e 70%, con incertezza molto alta perché i dati storici mostrano inconsistenze che potrebbero indicare discriminazione passata — raccomandiamo valutazione umana aggiuntiva”

⚠️ Importante: Non elimina il bias (che è nei dati storici), ma lo rende visibile e impedisce di usarlo con falsa confidenza decisionale.

🔍 L’IA epistemica può aiutarci davvero contro fake news e deepfake?

Sì, ed è forse la sua applicazione più urgente nell’era della Post-Verità. I deepfake e le fake news prosperano perché gli algoritmi tradizionali danno risposte binarie sicure (“questo video è autentico al 92%”) anche quando i segnali sono ambigui.

Come funziona l’approccio epistemico: analizza le multiple fonti di incertezza — qualità dell’immagine, coerenza fisica, anomalie statistiche — e fornisce un range onesto: “l’autenticità è probabilmente tra 25% e 60%, troppo incerta per condivisione sicura”.

Non risolve magicamente il problema della Post-Verità, ma fa qualcosa di più importante: ci insegna a dubitare metodicamente, ci costringe a verificare invece di credere ciecamente.

✅ Risultato: Trasforma l’IA da amplificatore della crisi (che genera contenuti falsi sempre più convincenti) a filtro di robustezza che quantifica onestamente quanto possiamo fidarci di ogni informazione.

🎯 Perché dite che “solo chi sa di non sapere può essere affidabile”?

È il principio dell’umiltà socratica applicato agli algoritmi. Un sistema che dà sempre risposte precise e sicure, anche quando i dati sono insufficienti o contraddittori, è pericolosamente inaffidabile — come un medico che diagnostica con certezza assoluta senza aver fatto tutti gli esami necessari.

Domanda chiave: Preferireste un’IA medica che dice “cancro al 73%” basandosi su un’immagine sfocata, o una che dice “servono ulteriori analisi, l’incertezza è troppo alta per una diagnosi sicura”?

La seconda è più affidabile proprio perché ammette onestamente di non sapere abbastanza. L’affidabilità vera richiede trasparenza sui propri limiti.

🔑 Chiave di lettura: Nell’era della Post-Verità, dove tutti proclamano certezze assolute, la vera rivoluzione è costruire sistemi che quantificano onestamente la propria ignoranza — perché solo misurando l’incertezza possiamo gestirla razionalmente.

🌍 Come possiamo assicurarci che l’IA epistemica sia usata eticamente?

Serve un approccio radicalmente interdisciplinare e democratico che coinvolga diverse competenze e prospettive:

- Filosofi che capiscono le implicazioni epistemologiche profonde

- Ingegneri che sanno implementare la quantificazione dell’incertezza

- Cittadini che vivono le conseguenze quotidiane delle decisioni algoritmiche

- Giornalisti che combattono la disinformazione sul campo

- Esperti di etica che definiscono quando l’incertezza è troppo alta per decisioni automatiche

Tre pilastri fondamentali:

- Trasparenza obbligatoria: Ogni sistema deve dichiarare esplicitamente il suo livello di incertezza epistemica, come le etichette nutrizionali sui cibi

- Standard condivisi: Protocolli comuni su come misurare e comunicare l’incertezza

- Educazione diffusa: Insegnare a tutti — non solo agli esperti — come interpretare le misure di incertezza

🎓 Alfabetizzazione critica: Nell’era della Post-Verità, la vera alfabetizzazione digitale è capire quanto fidarsi di ogni informazione, non solo cosa credere. Non può essere deciso solo nei laboratori tecnologici — riguarda tutti noi.

🚀 Quali sono le applicazioni pratiche dell’IA epistemica già in uso oggi?

Anche se la ricerca è ancora in fase avanzata, alcune applicazioni dell’IA epistemica stanno già emergendo in settori critici:

🏥 Medicina diagnostica:

Sistemi che identificano quando un’immagine medica è troppo ambigua per una diagnosi automatica, richiedendo revisione umana specialistica

🚗 Veicoli autonomi:

Algoritmi che rallentano o richiedono intervento umano quando l’incertezza sulla strada aumenta (maltempo, situazioni inedite)

⚖️ Giustizia predittiva:

Sistemi di supporto decisionale che evidenziano quando i dati storici potrebbero contenere bias razziali o socioeconomici

💰 Finanza e credito:

Algoritmi che espandono i margini di incertezza quando valutano profili finanziari atipici o sottorappresentati nei dati storici

🌟 Il futuro: Man mano che la ricerca avanza, l’approccio epistemico diventerà standard in tutti i sistemi dove l’errore ha conseguenze gravi — dalla cybersecurity alla moderazione dei contenuti online, dalla selezione del personale alla valutazione del rischio climatico.

💬 Hai altre domande sull’IA epistemica e l’umanesimo digitale?

Esplora il Blog 🚀Epistemia vuol dire illusione di conoscenza.

👉 In pratica:

È quando una risposta suona bene, sembra coerente e convincente…

…ma in realtà non è fondata su veri dati o verifiche.

È linguaggio che dà l’impressione di sapere, senza davvero sapere.

Un esempio semplice: se qualcuno ti dice con tono sicuro “Il sole gira intorno alla Terra, è ovvio!”, quella frase appare plausibile perché è detta bene e con sicurezza, ma è epistemicamente falsa. Questo è Epistemia: il pacchetto linguistico è elegante, ma il contenuto non regge.

Post Scriptum

Le IA epistemiche sono sistemi di intelligenza artificiale progettati per quantificare e comunicare esplicitamente la propria incertezza — cioè per ammettere onestamente “non lo so abbastanza” quando i dati sono insufficienti, ambigui o al di fuori della loro esperienza di addestramento.

A differenza dei modelli tradizionali che forniscono sempre una singola risposta precisa (anche quando dovrebbero dubitare), le IA epistemiche generano insiemi di predizioni possibili con margini di confidenza espliciti, utilizzando tecniche matematiche avanzate come:

- Credal Sets (insiemi credali): set di distribuzioni probabilistiche che rappresentano tutte le ipotesi plausibili, non solo la più probabile

- Bayesian Neural Networks: reti neurali che mantengono distribuzioni di probabilità sui parametri invece di valori fissi

- Random Set Neural Networks: architetture che predicono range di risultati invece di singole classi

Il termine “epistemico” viene dal greco episteme (conoscenza) e si riferisce all’incertezza dovuta a mancanza di conoscenza — diversa dall’incertezza “aleatoria” (il caso puro, come lanciare un dado).

Esempi Concreti e Applicazioni Reali

1. 🏥 Medicina e Diagnostica Clinica

Problema: I sistemi di AI medica tradizionali spesso danno diagnosi con falsa sicurezza anche su immagini ambigue, rischiando errori clinici gravi.

Soluzione epistemica in azione:

- Imaging medico: Sistemi che analizzano radiografie, TAC o risonanze magnetiche e, invece di dichiarare “tumore maligno al 78%”, forniscono mappe di incertezza spaziale che evidenziano le regioni ambigue dove serve revisione umana

- Esempio concreto: Il progetto Horizon 2020 da €3 milioni guidato dal Prof. Fabio Cuzzolin (Oxford Brookes University) ha sviluppato modelli per chirurgia robotica che aumentano precisione e affidabilità comunicando al chirurgo quando l’incertezza è troppo alta per proseguire autonomamente

- Risultati: Uno studio del 2024 su 200 pubblicazioni scientifiche dimostra che l’incertezza epistemica in AI medica migliora la fiducia dei clinici e riduce gli errori diagnostici, perché il sistema dice onestamente “questa immagine richiede ulteriori test” invece di indovinare

Case study: Un sistema AI per la diagnosi del cancro analizza una biopsia e rileva pattern sospetti. Invece di dire “cancro con probabilità 65%”, risponde: “Probabilità tra 40% e 85%, con alta incertezza epistemica dovuta a qualità dell’immagine insufficiente — raccomando biopsia aggiuntiva e consulto specialistico”.

2. 🚗 Veicoli Autonomi

Problema: I sistemi di guida autonoma tradizionali sono overconfident (troppo sicuri di sé) anche in situazioni mai viste prima, causando incidenti mortali quando incontrano “edge cases” (scenari rari o fuori distribuzione).

Soluzione epistemica in azione:

- Robust Imitative Planning (RIP): Metodo sviluppato da Oxford/DeepMind che usa l’incertezza epistemica per rilevare quando il veicolo incontra situazioni fuori dalla sua esperienza di addestramento (maltempo estremo, cantieri stradali inediti, pedoni con comportamenti insoliti)

- Comportamento adattivo: Quando l’incertezza epistemica supera una soglia di sicurezza, il veicolo automaticamente:

Case study reale: Uno studio del 2024 su veicoli autonomi dotati di classificatori “uncertainty-aware” ha dimostrato che questi sistemi riducono drasticamente gli incidenti perché sanno quando sono incerti — per esempio, di fronte a un oggetto mai visto sulla strada (un manichino, un animale raro), invece di classificarlo con falsa sicurezza come “pedone” o “ostacolo”, espandono i margini di incertezza e frenano cautelativamente.

3. 🌍 Previsione del Cambiamento Climatico

Problema: I modelli climatici devono fare previsioni su decenni gestendo incertezze enormi (variabilità naturale, emissioni future, feedback complessi), ma spesso comunicano risultati come certezze.

Soluzione epistemica in azione:

- Climate Epistemic AI: Sistemi che modellano esplicitamente cosa il modello “sa” e cosa “ignora” — per esempio, distinguendo tra incertezza dovuta a variabilità meteorologica (aleatoria) e incertezza dovuta a lacune scientifiche sui feedback oceanici (epistemica)

- Agricoltura sostenibile: IA per previsioni meteo che comunica agli agricoltori non solo “pioverà il 15 maggio”, ma “c’è alta incertezza epistemica sulle precipitazioni tra 10-20 maggio a causa di pattern anomali mai osservati — considera strategie di irrigazione flessibili”

Risultato: Decisioni più robuste perché i policy maker capiscono dove risiedono le maggiori incertezze e possono allocare risorse di ricerca di conseguenza.

4. 🔬 Ricerca Scientifica: AlphaFold ed Epistemic AI

Problema: AlphaFold di DeepMind ha rivoluzionato la predizione delle strutture proteiche, ma spesso forniva predizioni sbagliate con alta confidenza.

Soluzione epistemica:

- Le versioni recenti includono pLDDT scores (predicted Local Distance Difference Test) che quantificano l’incertezza per ogni regione della proteina

- I ricercatori usano questi score per capire quali parti della struttura predetta sono affidabili e quali richiedono verifica sperimentale

- Applicazioni: progettazione farmaci, controllo della fusione nucleare, spiegazioni causali in fisica

5. 🛡️ Cybersecurity e Rilevamento Anomalie

Esempio concreto:

- Filtri anti-spam epistemici: Invece di classificare un’email come “spam al 92%”, sistemi bayesiani forniscono intervalli: “probabilità spam tra 75-98%, con incertezza alta su mittente sconosciuto” — permettendo all’utente di decidere consapevolmente

- Rilevamento intrusioni: Sistemi che espandono automaticamente i margini di incertezza quando rilevano traffico di rete mai visto prima, allertando gli analisti umani invece di prendere decisioni automatiche rischiose

6. ⚖️ Giustizia Predittiva

Problema: Algoritmi che predicono recidiva criminale spesso replicano bias razziali con falsa sicurezza matematica.

Soluzione epistemica:

- Sistemi che comunicano: “Il rischio stimato per questo individuo è tra 15% e 65%, con altissima incertezza epistemica perché il profilo socioeconomico è sottorappresentato nei dati storici — decisione finale richiede valutazione umana contestualizzata”

- Impatto: Riduce discriminazioni automatizzate rendendo esplicito quando i dati storici sono troppo viziati per decisioni affidabili

7. 📊 Finanza: Gestione del Rischio

Applicazioni reali:

- Valutazione del credito: Modelli bayesiani che, di fronte a profili finanziari atipici (freelancer, immigrati, giovani senza storia creditizia), espandono automaticamente i margini di incertezza invece di negare automaticamente il prestito

- Trading algoritmico: Sistemi che riducono l’esposizione al rischio quando l’incertezza epistemica sui mercati aumenta (volatilità anomala, eventi geopolitici inediti)

8. 🎓 Educazione: AI Tutor Epistemici

Nuovo frontiera:

- Sistemi educativi che ammettono “Non sono sicuro di questa spiegazione” quando una domanda studente cade fuori dal loro training, invece di inventare risposte plausibili ma false

- Impatto: Insegna agli studenti il pensiero critico e il dubbio metodico, invece di accettare passivamente le risposte dell’IA

Vantaggi Chiave delle IA Epistemiche

- Riducono le “sorprese”: Sistemi meno vulnerabili a dati adversariali o fuori distribuzione perché sanno riconoscere l’inedito

- Migliorano la fiducia: Clinici, ingegneri e utenti si fidano di più di sistemi che ammettono i propri limiti

- Supportano decisioni critiche: In settori dove l’errore costa vite (medicina, guida autonoma, aviazione), la quantificazione dell’incertezza è essenziale

- Combattono i bias: Espandendo l’incertezza quando i dati sono distorti, evitano di replicare discriminazioni con falsa confidenza

Progetti e Collaborazioni Internazionali

- Horizon 2020 Epistemic AI Consortium: Progetto europeo da €3M (KU Leuven, TU Delft, Oxford Brookes) che ha sviluppato le basi matematiche (credal sets, random sets) e applicazioni in robotica chirurgica e veicoli autonomi

- NeurIPS 2024: Conferenza leader in machine learning con sessioni dedicate a “Conformalized Credal Set Predictors”

- Forethought Institute: Ricerca su “AI for Epistemics” — come usare l’IA per migliorare la nostra capacità collettiva di distinguere verità da falsità nell’era della Post-Verità

Conclusione: L’IA che “Sa di Non Sapere”

Le IA epistemiche rappresentano un cambio di paradigma: da sistemi che fingono onniscienza a strumenti che praticano l’umiltà socratica digitale. Non sono perfette — richiedono maggiore complessità computazionale e possono essere più lente — ma offrono qualcosa di inestimabile nell’era della Post-Verità: onestà intellettuale algoritmica.

Come dice il Prof. Cuzzolin: “Non si tratta solo di fare previsioni migliori, ma di costruire sistemi che sanno quando non sanno — e ce lo dicono prima che sia troppo tardi”.

Questi esempi concreti dimostrano che l’IA epistemica non è fantascienza, ma una realtà operativa che sta trasformando settori critici dalla medicina alla mobilità, dalla scienza al climate change! 🚀🧠