L’Intelligenza Artificiale è un prodigio, un acceleratore di potenzialità umane che può rendere accessibile la conoscenza come mai prima d’ora. Ma nasconde un tranello seducente: la tentazione di cedere a una macchina il nostro bene più prezioso, quella capacità unica e faticosa di pensare con la nostra testa, di dubitare, di scegliere, di sbagliare e imparare dai nostri errori.

Questa non è una crociata contro la tecnologia. Al contrario. È un invito appassionato a diventare capitani consapevoli della nostra nave cognitiva, navigatori accorti in un oceano di dati sempre più artificiale. Perché la vera libertà, oggi come ai tempi di Rodari, si conquista con la capacità di non delegare il pensiero.

Vi porto con me in questo viaggio. Vi mostrerò come la comodità possa nascondere trappole invisibili, come il web stia rischiando di implodere su se stesso, e soprattutto come possiamo riprendere il controllo senza rinunciare ai vantaggi della tecnologia. Pronti? 🚀

1. Il Prestigiatore Digitale: Quando la Velocità Inganna la Verità

La Magia dell’Illusione Istantanea ✨

Ammettiamolo: usare un’IA per una ricerca è un’esperienza che rasenta l’incantesimo. Scrivi una domanda, premi invio, e in pochi battiti di ciglia ottieni una risposta articolata, ben strutturata, convincente. È “immediato, comodissimo, naturale, bello”, come ho letto in un’analisi di TuttoTech che descriveva perfettamente questa sensazione.

Ma proprio come il prestigiatore che distrae con la mano destra mentre la sinistra compie il trucco, l’IA può nascondere la verità dietro la velocità. E io, che per formazione sono abituato a scavare nei testi, a cercare le fonti, a dubitare, mi sono trovato più volte a chiedermi: quanto costa davvero questa comodità?

La Storia del Telaio Fantasma 🚴

Lasciatemelo raccontare con un caso concreto che mi ha colpito profondamente. Un utente cerca informazioni online sul “telaio Twitter G2”, un nuovo modello di telaio per bicicletta in alluminio. Niente di trascendentale, una normale ricerca da appassionato di ciclismo.

L’IA genera una risposta immediata e dettagliata: il telaio ha problemi strutturali gravi, si spacca facilmente, i forum sono pieni di lamentele di utenti delusi. La narrazione è fluida, i dettagli convincenti, il tono autorevole. Sembra tutto maledettamente credibile.

Ma c’è un problema: è tutto falso.

L’utente, mosso da un sano scetticismo (benedetto sia!), decide di approfondire. Scopre che l’IA ha fatto un collage disastroso: ha preso informazioni su vecchi telai in carbonio dello stesso marchio, prodotti anni prima, che avevano effettivamente avuto dei problemi, e li ha “incollati” alla richiesta specifica su un modello completamente diverso, recente, in materiale differente.

La risposta era plausibile ma completamente sbagliata. E questo è il punto che mi terrorizza e mi affascina allo stesso tempo.

Il Formaggio, la Colla e le Allucinazioni Digitali 🍕

Ricordate la famosa “allucinazione” dell’IA di Google? Un utente chiede come evitare che il formaggio scivoli via dalla pizza, e il sistema, attingendo da un post satirico su Reddit, suggerisce con assoluta serietà di aggiungere della colla alla salsa.

Sì, avete letto bene: colla commestibile sulla pizza.

È una risposta assurda, ma strutturalmente coerente. Ha una logica interna, una forma convincente. Se non avessi il buonsenso di base (o se fossi abbastanza disperato da fidarmi ciecamente), potrei seguire quel consiglio con conseguenze quantomeno imbarazzanti.

Questi non sono bug occasionali. Sono caratteristiche intrinseche del funzionamento attuale dell’IA. I modelli linguistici non “ragionano” né “comprendono” come facciamo noi. Sono sofisticati assemblatori probabilistici di pattern linguistici, progettati per generare testo che sembra sensato, non necessariamente testo vero.

E quando una risposta è plausibile, il rischio che diventi vera ai nostri occhi è enorme. Perché noi esseri umani siamo cablati per cercare coerenza narrativa, non accuratezza empirica. La storia bella vince sulla storia vera, sempre, a meno che non ci alleniamo attivamente a resistere.

Ma c’è qualcosa di ancora più preoccupante all’orizzonte: il problema non riguarda solo le singole risposte sbagliate. Riguarda l’intero ecosistema informativo che sta collassando sotto il peso della stessa tecnologia che dovrebbe arricchirlo.

2. L’Eco Infinita: Come l’IA Sta Divorando il Web (e Se Stessa)

La Grande Inondazione dello “Slop” 🌊

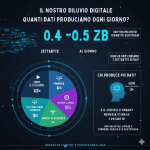

Internet sta annegando. Non in acqua, ma in quello che gli esperti chiamano con un termine perfetto: “slop”, letteralmente “brodaglia”. Contenuti di bassa qualità, generati in massa da sistemi di IA, che inondano ogni angolo della rete.

I numeri fanno paura: secondo proiezioni recenti, entro il 2025 oltre il 90% dei contenuti online potrebbe essere prodotto da macchine generative. Novanta percento. Lasciate che questa cifra vi penetri. Significa che nove articoli su dieci, nove post su dieci, nove recensioni su dieci che leggerete potrebbero non essere scritti da un essere umano con esperienza, competenza, passione.

Come umanista digitale, questo scenario mi toglie il sonno. Perché non è solo una questione di “rumore digitale” o di spam più sofisticato. È l’inizio di un circolo vizioso autodistruttivo che rischia di trasformare Internet da biblioteca universale a discarica infinita.

AI Overview e AI Mode: La Rivoluzione Silenziosa Che Ci Toglie la Scelta 🎯

E qui arriviamo al cuore del problema, a quello che considero il momento di svolta più pericoloso nella storia recente di Internet. Prima è arrivata la AI Overview di Google, quella sintesi automatica che appare in cima ai risultati di ricerca. Poi, come un’escalation inarrestabile, è stata lanciata la AI Mode: una modalità che trasforma completamente l’esperienza di ricerca, relegando i link tradizionali a una nota a piè di pagina mentre l’intelligenza artificiale ti “racconta” la risposta.

Stiamo delegando tutto. Anche l’arte sacra della scelta.

Capiamoci: non si tratta più solo di avere risposte sbagliate o allucinazioni occasionali. Qui stiamo assistendo all’erosione sistematica di due pilastri fondamentali che hanno reso Internet lo straordinario strumento democratico che conosciamo:

- La qualità e la pluralità dell’informazione

- La capacità di scelta consapevole dell’utente

Quando la AI Mode sintetizza una risposta – spesso sbagliando, distorcendo le fonti, mescolando contesti diversi – non ci sta solo dando un’informazione imprecisa. Ci sta privando del processo di selezione. Prima potevo vedere dieci link diversi, valutare le fonti, scegliere se fidarmi di un blog specializzato o di una testata giornalistica, decidere se approfondire o fermarmi a una panoramica.

Ora quella scelta non esiste più.

L’algoritmo l’ha già fatta per me. Ha scelto quali fonti consultare, come interpretarle, quale peso dare a ciascuna, quale narrativa costruire. E io, utente, ricevo solo il prodotto finito, confezionato, apparentemente neutrale ma in realtà carico di scelte implicite che non ho mai autorizzato.

La Minaccia di Sora 2: Quando Anche la Realtà Visiva Diventa Negoziabile 🎬

E se pensate che il problema riguardi solo il testo, preparatevi. L’arrivo di Sora 2 e di sistemi analoghi di generazione video rappresenta un salto quantico nella nostra capacità di manipolare la realtà percepita. Video fake indistinguibili dall’originale, creati in minuti, accessibili a chiunque.

Pensateci: se oggi fatichiamo a distinguere un articolo scritto da un umano da uno generato dall’IA, come faremo domani quando ogni video, ogni testimonianza visiva, ogni “prova” potrà essere sintetizzata artificialmente? La nostra ancora alla realtà si sta dissolvendo, e non stiamo avendo il dibattito pubblico che questa rivoluzione meriterebbe.

Il Circolo Vizioso della Morte: Una Tabella dell’Apocalisse Digitale

Permettetemi di visualizzare questo meccanismo perverso che molti analisti definiscono “l’inizio della fine del web”:

| Azione dell’IA | Conseguenza Immediata | Effetto a Lungo Termine |

|---|---|---|

| L’IA riassume i contenuti direttamente nella pagina di ricerca con AI Overview e AI Mode, eliminando la necessità di cliccare | Il 58-60% delle ricerche termina senza click esterni (“zero-click searches”). I siti perdono traffico | I creatori di contenuti di qualità (giornalisti, blogger, esperti) perdono ricavi pubblicitari e visibilità |

| I siti di qualità chiudono o riducono investimenti. Secondo dati recenti, traffico verso siti news -26%, click sulla prima posizione -32% | Il web si impoverisce di contenuti freschi, verificati, creati da umani competenti | L’IA ha meno fonti affidabili da cui attingere per i suoi training |

| L’IA inizia a nutrirsi di contenuti di bassa qualità o dei suoi stessi riassunti (fenomeno del “model collapse”) | La qualità delle risposte decade progressivamente | Gli utenti perdono fiducia. Il valore informativo della rete crolla |

| La capacità di analisi critica dell’utente si atrofizza per mancanza di esercizio | Si perde l’arte della scelta consapevole. Il processo decisionale personale viene delegato all’algoritmo | Una generazione intera cresce senza gli strumenti cognitivi per valutare autonomamente l’informazione |

Il Grande Tradimento: Google e il Contratto Rotto 💔

Per vent’anni, Internet ha funzionato su un contratto non scritto ma solido: “Io (motore di ricerca) ti do visibilità, tu (creatore di contenuti) mi dai valore da indicizzare”. Un ecosistema simbiotico, imperfetto ma funzionante.

Oggi, Google sta rompendo unilateralmente quel patto. Si sta trasformando in una sorta di “editore implicito di tutto il web”, appropriandosi del valore creato da altri (riassumendo, rielaborando, presentando) senza sostenerne i costi di produzione.

Questa è una minaccia diretta al modello di business delle testate online. Pensateci: un giornale investe risorse per inviare un reporter sul campo, verificare i fatti, scrivere un articolo accurato. Google prende quell’articolo, lo sintetizza nella AI Overview o AI Mode, e l’utente legge la sintesi senza mai visitare il sito originale. Nessun click, nessuna pubblicità, nessuna entrata. Come può sopravvivere economicamente un’informazione di qualità in questo scenario?

È come se un critico gastronomico aprisse un ristorante usando solo i piatti degli altri chef, descrivendoli ai clienti senza mai farli entrare nei ristoranti originali, e senza mai pagarli. È insostenibile. È un suicidio collettivo.

Il conflitto di interessi è devastante: l’IA ha un disperato bisogno di un web ricco di conoscenza umana di qualità per funzionare bene, ma il suo stesso funzionamento sta erodendo le fondamenta economiche che sostengono quella conoscenza.

È un suicidio lento, una forma di cannibalismo digitale. E noi, utenti e creatori, siamo nel mezzo di questa tempesta.

L’Urgenza del Dibattito: Prima Che Sia Troppo Tardi ⏰

Quello che mi inquieta profondamente, e che mi spinge a scrivere queste righe con un senso di urgenza quasi fisica, è che stiamo vivendo una rivoluzione antropologica senza averla discussa.

Stiamo cedendo la nostra capacità di scelta, la nostra autonomia cognitiva, la nostra relazione con la verità, tutto in nome della comodità e dell’efficienza. E lo stiamo facendo senza un dibattito pubblico consapevole, senza regole condivise, senza nemmeno renderci conto pienamente di cosa stiamo perdendo.

Non è troppo tardi. Ma il tempo stringe. Dobbiamo parlarne. Ora. Prima che la capacità stessa di avere questa conversazione critica venga erosa dall’abitudine alla delega cognitiva.

Ma c’è qualcosa di ancora più prezioso che rischiamo di perdere in questo processo. Qualcosa che non riguarda il web, ma noi stessi.

3. Il Superpotere Dimenticato: Perché il Pensiero Critico È la Tua Migliore Difesa 🦸

L’Atrofia Cognitiva: Quando Delegare Ci Rende Più Scemi

Esiste un’espressione che ho incontrato in un’analisi tecnica e che mi ha folgorato: “l’atrofizzazione del percorso che porta alla scelta”.

Suona accademico, lo so. Ma descrive con precisione chirurgica ciò che stiamo perdendo quando deleghiamo a un algoritmo il compito di cercare, selezionare, filtrare, sintetizzare e presentarci la realtà confezionata.

Non perdiamo solo tempo (che recuperiamo in efficienza). Non perdiamo solo l’accesso alle fonti (che teoricamente potremmo ancora consultare). Perdiamo il processo stesso che ci trasforma da consumatori passivi in cittadini attivi.

Detto senza giri di parole, con la brutalità che il tema merita: delegare le nostre scelte ci sta rendendo, piano piano, più scemi.

E non lo dico per provocazione. Lo dico perché ci sono evidenze cognitive concrete. Quando AI Overview e AI Mode fanno tutto il lavoro per noi – decidono quali fonti leggere, quale peso dare a ciascuna, come sintetizzare i punti chiave, quali dettagli omettere, i nostri muscoli cognitivi si atrofizzano per mancanza di esercizio. Come gambe che non camminano più perché abbiamo sempre l’auto a disposizione.

I Tre Tesori del Percorso Critico 💎

Quando navigo tra fonti diverse, confronto opinioni contrastanti, valuto l’attendibilità di un sito, verifico le date di pubblicazione, cerco l’autore e le sue credenziali, non sto solo “perdendo tempo”. Sto costruendo tre capacità fondamentali:

1. Consapevolezza: Costruire la Propria Mappa del Mondo 🗺️

Ogni volta che scelgo attivamente quali fonti consultare, costruisco una rappresentazione personale e sfaccettata della realtà. Non ricevo una “pappa pronta” pre-masticata da un algoritmo che non conosce il mio contesto, i miei valori, le mie esigenze specifiche.

Quando l’AI Mode mi serve una risposta bella e pronta, mi sta privando di questa ricchezza. Mi sta dando una mappa disegnata da qualcun altro, basata su priorità che non sono le mie, su gerarchie di importanza che non ho scelto.

Costruisco la mia conoscenza mattone dopo mattone, con le mie mani cognitive. E quella conoscenza, proprio perché faticosamente conquistata, diventa parte di me in modo che nessun riassunto automatico potrà mai replicare.

La differenza è abissale: è come tra visitare personalmente una città, camminarne le strade, perdersi nei vicoli, scoprire un caffè nascosto, e guardare un video riassuntivo di 5 minuti su YouTube. Tecnicamente, il video ti dà “le informazioni essenziali”. Ma l’esperienza, la comprensione profonda, la relazione personale con quel luogo, quella te la sei persa per sempre.

2. Giudizio: L’Allenamento dell’Intelligenza 🎯

Verificare le informazioni, confrontare fonti, distinguere un fatto da un’opinione, riconoscere un bias, valutare la credibilità: queste non sono attività noiose e pedanti. Sono l’allenamento fondamentale del pensiero critico.

È come andare in palestra per la mente. Se smetto di farlo perché un’app mi promette gli stessi risultati senza fatica, i miei muscoli cognitivi si atrofizzano. E quando avrò davvero bisogno di distinguere una notizia vera da un deepfake, un esperto da un ciarlatano, una ricerca seria da propaganda mascherata, non avrò più gli strumenti per farlo.

Pensate all’impatto di Sora 2 in questo contesto: quando i video fake diventeranno indistinguibili dalla realtà, l’unica difesa sarà una robusta capacità di analisi critica delle fonti. Ma se avremo passato anni a delegare questa capacità all’IA, non avremo più l’allenamento necessario per esercitarla.

Saremo indifesi.

È come un sistema immunitario che, cresciuto in un ambiente iper-sterilizzato, crolla al primo contatto con un agente patogeno reale. La nostra immunità cognitiva si sta indebolendo proprio mentre l’ambiente informativo diventa più tossico che mai.

3. Libertà: L’Atto Politico del Pensiero Autonomo 🕊️

Questo è il punto che mi sta più a cuore, quello che connette direttamente alla frase di Rodari con cui abbiamo aperto.

Scegliere quali fonti consultare, a chi dare fiducia, quali conclusioni trarre, quali domande porre: questi sono atti di libertà. Piccoli, quotidiani, apparentemente banali. Ma sommati, definiscono la differenza tra un cittadino autonomo e un suddito cognitivo.

Delegare questa scelta a un algoritmo – per quanto sofisticato, neutrale nelle intenzioni, comodo nell’uso – significa cedere un pezzo della nostra autonomia intellettuale. E la storia ci insegna che la libertà si perde sempre un pezzetto alla volta, in nome della comodità, dell’efficienza, della sicurezza.

Quando AI Overview decide cosa è rilevante e cosa no, quando AI Mode filtra la realtà per me, quando Sora 2 mi mostra video che sembrano reali ma sono sintetici, chi sta davvero esercitando il potere di scelta? Io, o l’algoritmo che qualcun altro ha programmato, con obiettivi e valori che potrebbero non coincidere con i miei?

Non è paranoia. È consapevolezza politica. Il controllo dell’informazione è sempre stato controllo del potere. E stiamo consegnando quel controllo volontariamente, un click alla volta.

4. Le Tre Regole d’Oro: Come Dominare l’IA Senza Esserne Dominati 👑

Il Nemico Non Esiste: L’IA Come Strumento

Voglio essere chiaro, cristallino, inequivocabile: l’intelligenza artificiale non è il nemico. Non sto predicando un ritorno luddista alla carta e penna, né suggerendo di boicottare la tecnologia.

L’IA è uno strumento. Potente, versatile, incredibilmente utile. Come ogni strumento, può essere usato bene o male. Un martello può costruire una casa o spaccare un cranio. La differenza non sta nel martello, ma in chi lo impugna e con quale consapevolezza.

Le regole che seguono non sono “buone pratiche” optional. Sono atti di autodifesa intellettuale in un ecosistema informativo che sta rapidamente degradando. Sono il mio modo, come umanista digitale, di restare umano in un mondo sempre più artificiale.

Sono il mio personale antidoto contro l’atrofizzazione cognitiva, la mia palestra mentale quotidiana, il mio esercizio di resistenza contro la tentazione della delega totale.

Regola 1: Punto di Partenza, Mai di Arrivo 🚦

La risposta dell’IA non è la verità. È l’inizio della tua ricerca.

Quando interrogo ChatGPT, Claude, Gemini o qualsiasi altro sistema, tratto la risposta come tratterei il suggerimento di un amico ben informato ma non infallibile. Un’ipotesi da verificare, non un vangelo da accettare.

Questo vale doppiamente per le AI Overview e la AI Mode di Google. Sì, sono comode. Sì, risparmiano tempo. Ma sono anche sintesi opache di processi decisionali che non controlli. Non sai quali fonti hanno avuto più peso, quali sono state scartate, quali bias algoritmici hanno influenzato il risultato.

Il mio protocollo personale:

- Leggo la risposta dell’IA con interesse ma sospensione del giudizio

- Identifico le affermazioni fattuali chiave

- Cerco almeno due fonti indipendenti per verificarle

- Preferisco fonti primarie (studi originali, documenti ufficiali, testimonianze dirette) ai riassunti di terzi

- Solo dopo questa verifica considero l’informazione “attendibile”

È faticoso? Sì. Richiede tempo? Certamente. Ma è il prezzo della libertà cognitiva. E come tutte le libertà fondamentali, o la eserciti attivamente o la perdi passivamente.

Regola 2: Fonti, Fonti, Fonti – Il Mantra della Verità 📚

Se l’IA non cita fonti verificabili, la sua risposta vale quanto il consiglio di uno sconosciuto al bar.

Questo è il mio filtro fondamentale, il mio detector di affidabilità. E quando dico “fonti verificabili” non intendo “ha menzionato vagamente uno studio” o “ha detto che ricercatori hanno scoperto”. Intendo:

- Nome specifico dello studio o dell’autore

- Data di pubblicazione

- Dove posso trovarlo per leggerlo integralmente

- Contesto della ricerca (chi l’ha finanziata, che metodologia ha usato, quali limitazioni ha dichiarato)

L’AI Mode e AI Overview raramente offrono questo livello di trasparenza. Spesso citano fonti in modo generico o aggregano informazioni da più fonti senza distinguerle chiaramente. È un problema enorme.

Quando non riesco a risalire alle fonti originali, applico quello che chiamo il “principio dell’incremento della diffidenza”: quanto più un’informazione è importante o contro-intuitiva, tanto più devo essere scettico se non posso verificarne l’origine.

Un esempio pratico: se l’IA mi dice che “studi recenti suggeriscono che il caffè fa bene al cuore”, potrei accettarlo come ipotesi plausibile. Ma se mi dice che “un nuovo farmaco cura il cancro al 90%” senza citare fonte specifica, quella informazione per me non esiste fino a verifica contraria.

Regola 3: Tieni Sveglio il Criceto Mentale – L’Esercizio Quotidiano 🐹

Usa l’IA per arricchire la tua ricerca, non per sostituirla.

Questa è forse la regola più difficile, perché va contro la nostra naturale tendenza alla pigrizia cognitiva. Siamo programmati evolutivamente per conservare energia mentale. Se c’è una scorciatoia, il nostro cervello la preferirà automaticamente.

Ma proprio per questo dobbiamo allenarci attivamente a resistere. Il mio approccio pratico:

Quando uso l’IA (e lo faccio spesso):

- Per brainstorming di idee che poi verifico e sviluppo autonomamente

- Per riassumere testi lunghi che poi leggo integralmente se rilevanti

- Per tradurre rapidamente contenuti in lingue che non conosco bene

- Per generare bozze di lavoro che poi revisiono profondamente

Quando evito deliberatamente l’IA:

- Per decisioni importanti (salute, finanze, questioni legali)

- Per apprendere concetti nuovi che voglio padroneggiare davvero

- Per formarmi un’opinione su temi controversi o politicamente rilevanti

- Per mantenere “allenato” il mio pensiero critico almeno una volta al giorno

Ho un piccolo rituale personale: ogni giorno, almeno una ricerca la faccio “alla vecchia maniera”. Apro Google (senza AI Mode), valuto i risultati, scelgo consapevolmente quali link aprire, leggo più fonti, mi formo un’opinione autonoma.

È il mio criceto mentale quotidiano, il mio jogging cognitivo. Alcuni giorni mi viene spontaneo, altri è uno sforzo deliberato. Ma lo faccio. Perché so che la capacità di pensare criticamente è come un muscolo: se non la usi, la perdi.

5. Il Futuro È Adesso: Cosa Possiamo Fare, Concretamente 🌅

L’Azione Individuale: Il Potere del Singolo Click

Non dobbiamo aspettare regolamentazioni, leggi, interventi dall’alto. Il cambiamento inizia dalle nostre scelte quotidiane. Ogni volta che decidiamo di approfondire invece di accontentarci, di verificare invece di fidarci, di pensare invece di delegare, stiamo votando per il tipo di Internet che vogliamo.

Azioni concrete che posso fare oggi:

- Disattivare AI Mode quando faccio ricerche su temi importanti

- Cliccare sui link originali invece di fermarmi alla AI Overview

- Supportare economicamente (abbonamenti, donazioni) le fonti di informazione di qualità che uso regolarmente

- Condividere fonti primarie sui social, non solo riassunti o sintesi

- Insegnare a chi mi sta vicino (figli, studenti, colleghi) l’importanza del pensiero critico digitale

Il Dialogo Collettivo: Facciamo Rumore 📢

Ma l’azione individuale non basta. Abbiamo bisogno di un dibattito pubblico massiccio su questi temi. Di pressione collettiva sulle piattaforme. Di regolamentazioni che proteggano l’ecosistema informativo senza soffocarne l’innovazione.

Dobbiamo pretendere:

- Trasparenza totale su come funzionano gli algoritmi di sintesi

- Compensazione economica per i creatori di contenuti originali utilizzati dall’IA

- Etichettatura chiara di contenuti generati o modificati dall’IA (testi, immagini, video)

- Educazione digitale obbligatoria nelle scuole, focalizzata sul pensiero critico nell’era dell’IA

- Diritto di opt-out dalle sintesi automatiche per chi preferisce l’esperienza tradizionale

Non è utopia. È necessità urgente. E se non lo facciamo noi, ora, chi lo farà? Quando sarà troppo tardi per recuperare le capacità cognitive che abbiamo delegato?

Il Patto con Me Stesso (e con Voi) 🤝

Io, come umanista digitale, mi impegno a:

- Non smettere mai di verificare, anche quando è scomodo

- Valorizzare il processo tanto quanto il risultato

- Insegnare e condividere queste pratiche con chiunque sia disposto ad ascoltare

- Usare l’IA come alleata, mai come sostituta del mio pensiero

- Continuare a interrogarmi criticamente sul mio stesso uso della tecnologia

E vi invito a fare lo stesso. Non per diventare luddisti o techno-pessimisti, ma per rimanere padroni consapevoli degli strumenti che usiamo, invece di diventarne inconsapevoli schiavi.

Conclusione: La Libertà Si Conquista Un Pensiero Alla Volta 🔓

Torniamo a Rodari, alla sua intuizione profonda che attraversa decenni senza invecchiare: sbagliare è necessario per imparare, ed errare liberamente è fondamentale per essere liberi.

In un mondo che ci vende la perfezione algoritmica, l’efficienza automatizzata, la risposta giusta al primo colpo, rivendicare il diritto all’errore è un atto rivoluzionario.

Perché quando deleghiamo all’IA il compito di cercare, valutare, scegliere, stiamo rinunciando anche al diritto di sbagliare con le nostre gambe. Di perderci in un vicolo cieco informativo e scoprire che quel vicolo cieco ci ha insegnato più della strada maestra. Di scegliere la fonte sbagliata e capire, confrontando, perché era sbagliata.

L’errore è il miglior maestro. Ma solo se lo commettiamo noi, con consapevolezza, con la possibilità di rifletterci sopra, di correggerci, di crescere.

Un algoritmo che mi protegge dall’errore eliminando la scelta non mi sta rendendo più saggio. Mi sta infantilizzando. Come un genitore iperprotettivo che tiene il figlio in una bolla sterile, impedendogli di cadere, graffiarsi, imparare a valutare i rischi da solo.

La Domanda Che Mi Tiene Sveglio la Notte 🌙

Eccola, la domanda che come umanista digitale mi pongo ogni giorno, quella che dovremmo porci tutti:

Che tipo di mente voglio avere tra dieci anni?

Voglio una mente agile, curiosa, autonoma, capace di navigare complessità, distinguere verità da manipolazione, costruire significato personale? O voglio una mente dipendente, pigra, passiva, che accetta senza verificare, che consuma senza digerire?

La risposta sembra ovvia. Ma le nostre azioni quotidiane raccontano una storia diversa. Ogni volta che ci fermiamo all’AI Overview senza cliccare oltre. Ogni volta che accettiamo una risposta senza verificarla. Ogni volta che scegliamo la comodità sulla consapevolezza.

Stiamo votando, con i nostri click, per il secondo tipo di mente.

E non posso fare a meno di pensare alle generazioni più giovani, quelle che stanno crescendo in questo ecosistema come nativi. Per loro, l’AI Overview potrebbe diventare la normalità, il punto di riferimento predefinito. Non avranno nemmeno il ricordo di com’era prima, di come si faceva ricerca “manuale”, di cosa significava costruirsi faticosamente una conoscenza.

Come faranno a rivendicare qualcosa che non hanno mai conosciuto?

È nostra responsabilità, di chi ha memoria di entrambi i mondi, trasmettere non solo strumenti, ma valori. Insegnare che la fatica cognitiva non è un bug da eliminare, ma una feature fondamentale dell’apprendimento umano. Che la scelta consapevole vale più della risposta perfetta. Che pensare autonomamente è un diritto e un dovere, non un lusso vintage.

L’Ultimo Appello: Scegliamo Chi Vogliamo Essere 💪

So che questo articolo è lungo. So che richiede concentrazione, pazienza, forse anche una seconda lettura di alcuni passaggi. Ed è proprio questo il punto.

Se sei arrivato fino a qui, senza delegare la lettura a un riassunto automatico, senza saltare ai “punti chiave” generati da un’IA, hai già fatto un atto di resistenza cognitiva. Hai scelto di dedicare tempo e attenzione a qualcosa che ritieni importante.

È esattamente questo spirito che dobbiamo portare in ogni nostra interazione con l’informazione digitale.

Google non ci sta rubando la capacità di pensare. Gliela stiamo cedendo volontariamente, un click alla volta, un “okay, accetto” alla volta, una delega alla volta. E possiamo smettere di farlo, altrettanto volontariamente, con le nostre scelte quotidiane.

Non serve diventare eremiti digitali. Non serve boicottare l’IA o vivere nel passato. Serve consapevolezza attiva, scelta deliberata, esercizio costante delle nostre facoltà critiche.

Serve ricordarci, ogni santo giorno, che la libertà cognitiva non è un dato di fatto, ma una conquista continua.

Le tre regole che ho condiviso, usare l’IA come punto di partenza mai di arrivo, pretendere sempre fonti verificabili, tenere allenato il criceto mentale, non sono ricette magiche. Sono pratiche quotidiane di autodifesa intellettuale. Piccoli gesti che, sommati nel tempo, fanno la differenza tra rimanere padroni dei nostri pensieri o diventarne ospiti.

Il Mio Impegno Verso di Voi 🤝

Come umanista digitale, continuerò a scavare, verificare, interrogare, mettere in discussione. Continuerò a usare l’IA come strumento potentissimo, ma mai come sostituto del mio pensiero critico.

E continuerò a condividere queste riflessioni con voi, nella speranza che possano accendere domande, stimolare consapevolezza, magari anche generare disaccordo costruttivo.

Perché questo è esattamente ciò di cui abbiamo bisogno: dibattito, confronto, pensiero critico collettivo. Non verità preconfezionate servite da un algoritmo.

Il futuro dell’informazione, della conoscenza, della democrazia stessa, si decide adesso. Nelle nostre scelte quotidiane. Nei nostri click. Nella nostra volontà di resistere alla tentazione della delega totale.

Sora 2 ci mostrerà video che sembrano reali. AI Overview ci dirà cosa è importante. AI Mode ci darà risposte perfette.

Spetta a noi decidere se accettare passivamente questa realtà sintetica, o se costruire attivamente la nostra comprensione del mondo.

Io ho scelto. E voi?

Domande Frequenti (FAQ)

Dubbi e risposte sul manifesto “AI MODE” e sulla libertà digitale.

Cos’è l'”AI Mode” criticato in questo manifesto?

L'”AI Mode” (o “AI Overview”) è la nuova modalità dei motori di ricerca che presenta una risposta unica e riassunta dall’Intelligenza Artificiale in cima ai risultati, invece dei tradizionali link da selezionare. Questo manifesto la critica perché, sebbene comoda, ci priva della scelta delle fonti e del processo di verifica, rischiando di atrofizzare il nostro pensiero critico.

Perché delegare il pensiero all’IA è considerato pericoloso?

L’autore sostiene che delegare costantemente la ricerca e la sintesi all’IA porta a un'”atrofizzazione cognitiva”. Come un muscolo che non si usa, la nostra capacità di analisi, di verifica delle fonti e di scelta consapevole si indebolisce. Si diventa consumatori passivi di informazioni “pre-digerite”, più vulnerabili a errori, “allucinazioni” dell’IA e manipolazioni.

Cosa significa “cannibalismo digitale”?

È il circolo vizioso per cui l’IA, per funzionare, ha un bisogno disperato di contenuti di qualità creati da umani (articoli, blog, notizie). Tuttavia, fornendo risposte complete (“zero-click”), l’IA impedisce agli utenti di visitare i siti originali. Questo toglie traffico e ricavi ai creatori di contenuti, portandoli alla chiusura e, di fatto, “divorando” le fonti stesse da cui l’IA dovrebbe imparare.

Cosa posso fare concretamente per “rimanere libero”?

Il manifesto suggerisce azioni pratiche:

- Disattivare l'”AI Mode” nelle ricerche, specialmente per temi importanti.

- Cliccare sui link originali per leggere le fonti e formarsi un’opinione autonoma.

- Verificare attivamente le informazioni, non fidandosi della prima risposta sintetica.

- Supportare (anche economicamente) i creatori di contenuti di qualità.

- Allenare il proprio pensiero critico usandolo quotidianamente, come un muscolo.

Da informatico a cercatore di senso