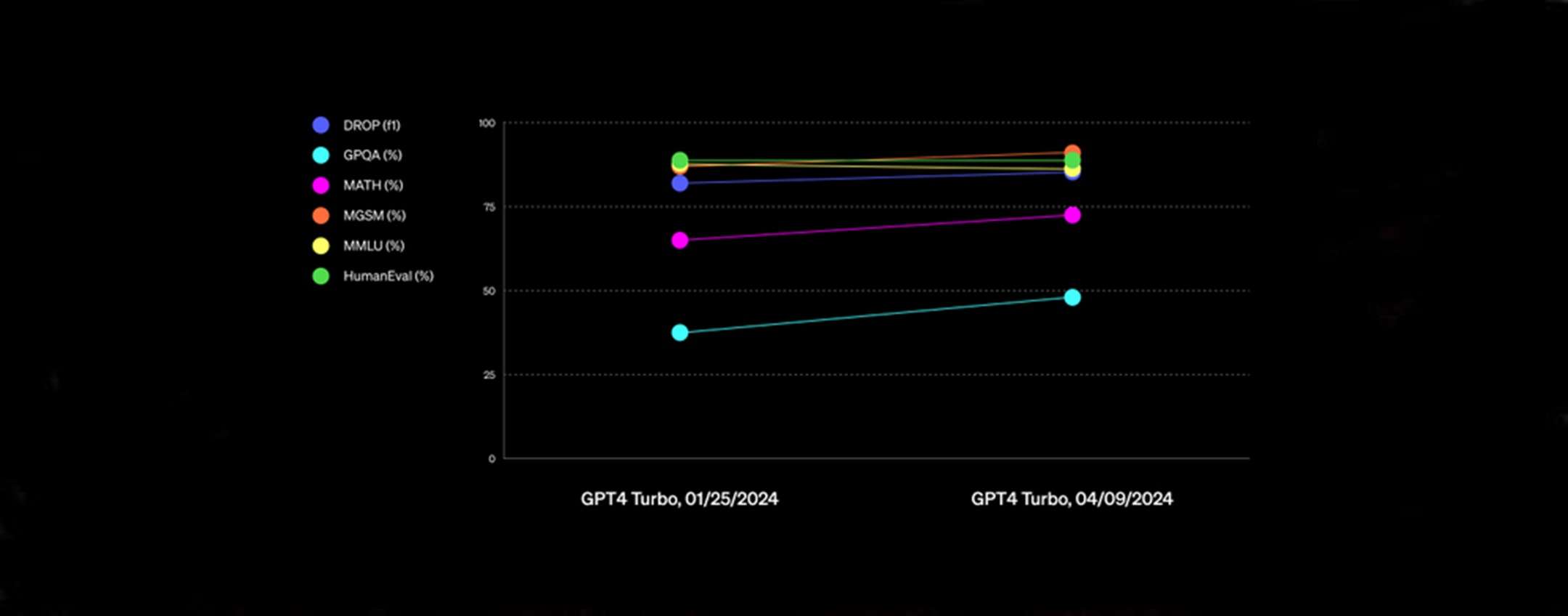

OpenAI ha lanciato un importante aggiornamento per ChatGPT, portando l’esperienza conversazionale a un livello superiore. Gli utenti dei piani premium, inclusi ChatGPT Plus, Team o Enterprise, ora possono accedere a una versione potenziata del GPT-4 Turbo, che non solo migliora la qualità delle conversazioni ma estende anche le capacità del chatbot in aree come la scrittura, la matematica, il ragionamento logico e la codifica.

Una novità saliente di questo aggiornamento è l’ampliamento della base di conoscenze di ChatGPT. Mentre la precedente versione attingeva a dati fino ad aprile 2023, la nuova iterazione “gpt-4-turbo-2024-04-09” è stata addestrata con informazioni disponibili fino a dicembre 2023, consentendo a ChatGPT di offrire risposte più precise e aggiornate.

OpenAI ha inoltre implementato un linguaggio più colloquiale, rendendo le risposte di ChatGPT più dirette e meno verbose. Questi miglioramenti promettono di rendere le interazioni con il chatbot più naturali e coinvolgenti, migliorando significativamente l’esperienza utente.

Nonostante questi progressi, OpenAI si trova al centro di controversie. Recentemente è emersa una proposta di Microsoft di utilizzare DALL-E, un altro modello di OpenAI, come strumento di guerra per l’esercito americano, sollevando questioni etiche sull’uso dell’intelligenza artificiale in contesti militari. Inoltre, la compagnia ha licenziato due ricercatori per una presunta fuga di informazioni, suggerendo tensioni interne e lotte di potere che sollevano dubbi sulla stabilità e la direzione futura dell’azienda.

GPT-4 Turbo: Nuovi Orizzonti nella Complessità Conversazionale

OpenAI ha recentemente introdotto GPT-4 Turbo, un’iterazione ancora più avanzata del già potente GPT-4. Una delle caratteristiche più impressionanti di questa nuova versione è la sua aumentata capacità di elaborazione: GPT-4 Turbo può ora interpretare fino a 128k token, equivalenti a circa 96.000 parole per prompt, espandendo drasticamente la sua abilità di analizzare e gestire i dati. Questo rappresenta un notevole salto qualitativo rispetto al limite precedente di 32.000 token. Nonostante l’estensione della capacità di elaborazione, l’output massimo permesse dall’algoritmo rimane fissato a 4.000 token, mantenendo così un equilibrio tra comprensione approfondita e risposta sintetica.

Riferimenti