Hai bisogno di una versione PDF dell’articolo per una lettura più comoda o per conservarne una copia? Clicca sul link sottostante per scaricare il PDF direttamente sul tuo dispositivo.

Scarica l’articolo in PDF (ITA)Do you need a PDF version of the article for easier reading or to keep a copy? Click the link below to download the PDF directly to your device.

Download Article as PDF (ENG)La Voce Che Conosci Bene: Un Rischio Nascosto

Introduzione

Immagina di ricevere una chiamata: dall’altra parte, riconosci immediatamente la voce di tua madre, un figlio, un amico o un collega. Ti chiedono aiuto, parlano di un’emergenza e ti chiedono soldi. Ma aspetta un attimo, potrebbe non essere davvero quella persona! I truffatori stanno utilizzando l’intelligenza artificiale per clonare le voci, ingannandoti e spingendoti a cadere in una trappola ben congegnata. Questo tipo di truffa vocale è in aumento e diventa sempre più sofisticata.

Le Tecniche Utilizzate dai Truffatori

I truffatori oggi non si limitano più alle email di phishing o ai messaggi di testo sospetti. Sono passati a metodi più sofisticati e tecnologicamente avanzati come i deepfake vocali.

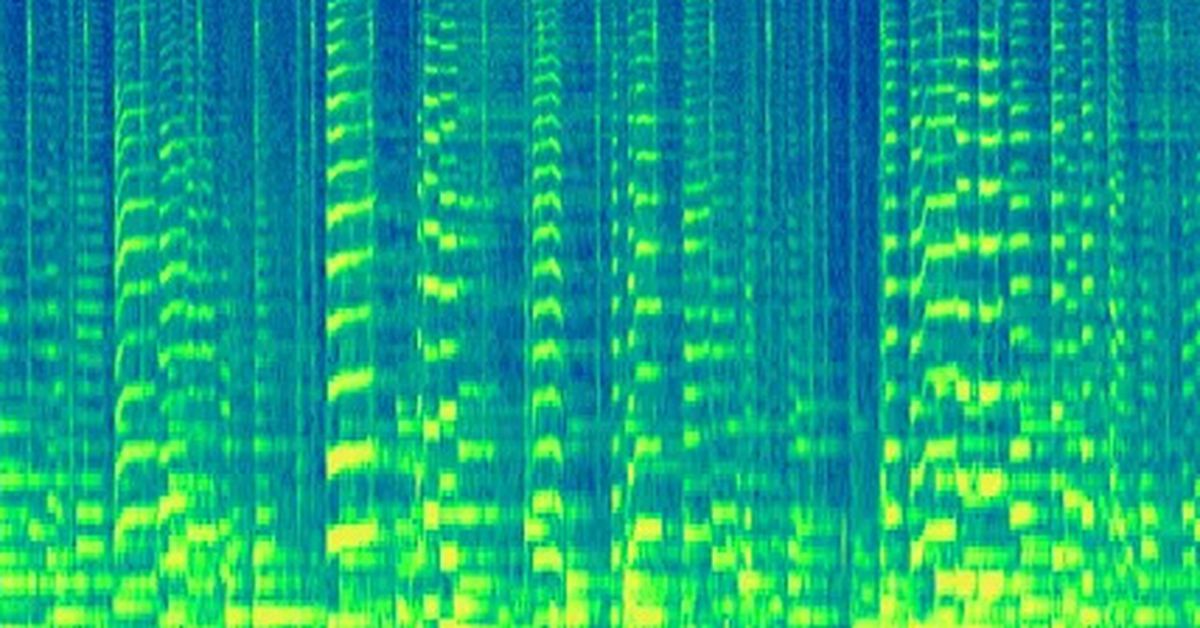

Grazie a strumenti online facilmente accessibili, possono replicare la voce di qualcuno in modo incredibilmente fedele. Secondo un recente allarme lanciato dalla Starling Bank, i truffatori possono generare una copia digitale della voce di una persona usando solo tre secondi di audio, spesso estrapolati da video pubblicati sui social media.

Secondo i dati della Federal Trade Commission, nel 2022 sono state oltre 36.000 le segnalazioni di persone truffate negli Stati Uniti da qualcuno che finge di essere un amico o un familiare. L’inganno funziona meglio al telefono e infatti sono stati 5.100 i casi di truffa via chiamata, e i criminali sono riusciti a estorcere 11 milioni di dollari.

Un’analisi condotta dalla Starling Bank con Mortar Research quest’anno ha rilevato che su oltre 3.000 adulti, più di un quarto ha dichiarato di essere stato preso di mira da una truffa di clonazione vocale tramite IA negli ultimi 12 mesi.

Sul mercato sono disponibili già diversi strumenti di sintesi vocale AI. ElevenLabs, per esempio è stata fondata nel 2022, e presenta sia una versione gratuita, sia a pagamento (può variare dai 5 ai 330 dollari al mese). L’azienda è già stata criticata. A gennaio su 4Chan, un utente ha pubblicato una clip di Emma Watson che legge un passaggio di Mein Kampf realizzato con l’app.

- Dati della Federal Trade Commission (FTC) nel 2022:

- Oltre 36.000 segnalazioni di truffe negli Stati Uniti.

- Truffatori si spacciano per amici o familiari.

- 5.100 casi di truffa via chiamata.

- Estorsione totale di 11 milioni di dollari.

- Analisi della Starling Bank con Mortar Research:

- Su oltre 3.000 adulti, più di un quarto ha subito tentativi di clonazione vocale tramite IA nell’ultimo anno.

- Strumenti di sintesi vocale AI disponibili:

- ElevenLabs:

- Fondata nel 2022.

- Offre versioni gratuite e a pagamento (da 5 a 330 dollari al mese).

- Critiche ricevute per l’uso improprio della tecnologia.

- Esempio controverso: clip di Emma Watson letta con l’app pubblicata su 4Chan.

- ElevenLabs:

Lisa Grahame, responsabile della sicurezza informatica presso Starling Bank, avverte: “Le persone pubblicano regolarmente online contenuti che contengono registrazioni della loro voce, inconsapevoli che ciò li rende più vulnerabili ai truffatori”. Questo significa che ogni post, video o messaggio vocale che condividi potrebbe essere utilizzato contro di te.

Hany Farid, professore di digital forensics presso l’Università della California a Berkeley, spiega che solo pochi anni fa era necessario avere molto più materiale audio per clonare la voce di una persona. Oggi, con un semplice video su Facebook o TikTok, i truffatori possono creare un deepfake vocale in pochi secondi.

Quanto materiale serve all’AI per clonare la voce

I moderni sistemi AI riescono a clonare la voce partendo da campioni audio di pochissimi secondi. Ne è un esempio lampante lo strumento Voice Engine di OpenAI – l’azienda che sviluppa ChatGPT – recentemente finita nell’occhio del ciclone a causa della presunta clonazione vocale dell’attrice Scarlett Johansson fatta senza permesso, che è in grado di clonare la voce in appena 15 secondi (vista la sua potenziale pericolosità, il tool al momento non è ancora stato rilasciato pubblicamente).

Segnali di Allarme

Come puoi riconoscere una truffa vocale prima di cadere nella rete? Ecco alcuni segnali di allarme:

- Richieste di denaro improvvise: Se ricevi una chiamata in cui ti viene chiesto denaro, soprattutto in situazioni di emergenza, sii sospettoso.

- Dettagli vaghi: I truffatori potrebbero evitare di fornire dettagli specifici. Se la persona al telefono sembra evitare domande dirette, è un campanello d’allarme.

- Cambio di tono: Anche se la voce sembra familiare, potrebbe esserci un leggero cambiamento nel tono o nella cadenza.

Come Proteggersi

Non possiamo fermare i truffatori dal tentare, ma possiamo sicuramente rendere la loro vita più difficile. La risposta? Combattere la tecnologia con la tecnologia. Ning Zhang, un brillante ingegnere informatico della McKelvey School of Engineering, ha sviluppato uno strumento promettente chiamato AntiFake anche se non costituisce la panacea di tutti i mali.

Presentato durante una conferenza sulla sicurezza informatica tenutasi a Copenaghen, questo strumento utilizza una tecnica di intelligenza artificiale per confondere leggermente il segnale audio, rendendolo difficile da clonare pur mantenendo la qualità per l’orecchio umano.

Comunque è bene tener presente che proteggere te stesso da una truffa vocale richiede alcune precauzioni pratiche:

- Verifica l’identità: Chiama direttamente la persona o usa un altro mezzo di comunicazione per confermare la storia.

- Limita la tua presenza online: Fai attenzione a quali contenuti vocali condividi sui social media. Ogni audio può essere potenzialmente utilizzato per creare un deepfake.

- Non fornire mai informazioni personali: Evita di condividere dati sensibili al telefono.

- Usa applicazioni di blocco delle chiamate: Queste app possono identificare e bloccare le chiamate da numeri sospetti.

- Resta informato: Tenerti aggiornato sulle nuove tecniche di truffa può aiutarti a riconoscerle prima che sia troppo tardi. Econopoly – ilSole24ORE offre ottimi approfondimenti su come le truffe stanno evolvendo.

Domande Frequenti

Cosa devo fare se sospetto di essere vittima di una truffa vocale?

Contatta immediatamente la persona di cui hai riconosciuto la voce con un diverso mezzo di comunicazione. Se confermi che si tratta di una truffa, segnala l’accaduto alle autorità competenti.

Quali sono alcune delle piattaforme più a rischio per il furto di audio?

Le piattaforme di social media come Facebook, Instagram, TikTok e YouTube sono particolarmente a rischio, poiché gli utenti tendono a condividere molte registrazioni vocali.

Possono i truffatori clonare la voce di chiunque?

Sì, se riescono ad ottenere un campione audio di pochi secondi, possono teoricamente clonare la voce di chiunque.

Conclusione

La tecnologia avanza a passi da gigante, e con essa anche le tecniche dei truffatori. È essenziale restare informati e prendere precauzioni per proteggere noi stessi e i nostri cari da queste minacce sempre più diffuse. Ricorda sempre di verificare prima di agire, soprattutto quando si tratta di richieste di denaro.

Video in Italiano

Video in Inglese

Da informatico a cercatore di senso