La posta in gioco si è alzata enormemente, superando la semplice questione dell’accesso alla tecnologia per toccare l’architettura profonda delle esperienze formative.

La Rivoluzione Silenziosa dei Grandi Modelli Linguistici (LLM)

L’ingresso massivo dei Large Language Models (LLM) nei contesti educativi e sociali ha introdotto una mediazione algoritmica di un tipo completamente nuovo. L’AI non si limita più a classificare o predire; ora genera contenuti, feedback, spiegazioni e interi stili comunicativi. Questo cambiamento radicale ha rotto la tradizionale asimmetria tra strumento e soggetto: il sistema non solo risponde, ma co-costruisce attivamente il contesto cognitivo in tempo reale. Per un bambino, ciò si traduce in un ambiente adattivo che impara dalle sue interazioni e modella progressivamente le sue traiettorie di senso.

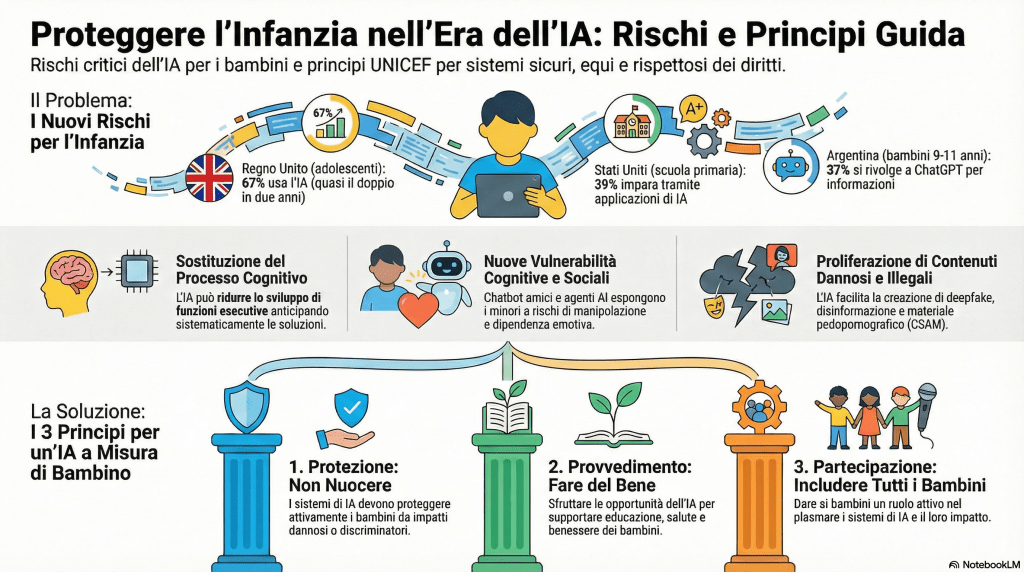

E l’adozione è sbalorditiva. Recenti dati rivelano un’espansione rapida e diffusa: il 67% degli adolescenti nel Regno Unito utilizza ormai l’AI, una cifra quasi raddoppiata in soli due anni. Negli Stati Uniti, il 39% degli studenti delle elementari apprende attraverso applicazioni basate sull’AI, mentre in Argentina il 37% dei bambini tra i 9 e gli 11 anni si rivolge a ChatGPT per trovare informazioni,.

Il Costo Invisibile dell’Anticipazione

Questa onnipresenza solleva una delle criticità tecniche più sottili ma profonde: la dinamica tra l’apprendimento umano e quello automatico.

Mentre i modelli di AI si addestrano su corpora testuali e comportamentali vastissimi, il bambino impara attraverso l’esplorazione incarnata, l’errore, l’imitazione e il conflitto cognitivo. Cosa succede quando l’AI anticipa sistematicamente ogni soluzione?

Il rischio principale non è l’uso della tecnologia, ma la sostituzione invisibile del processo stesso. Un sistema che riduce costantemente il gradiente di incertezza ostacola lo sviluppo di funzioni esecutive cruciali, della metacognizione e della tolleranza all’errore. Questo fenomeno è particolarmente visibile nel contesto scolastico, dove l’AI, pur potendo aiutare i bambini ad imparare, è anche in grado di fare i loro compiti, minando potenzialmente l’apprendimento e il pensiero necessari in una fase cruciale dello sviluppo.

Inoltre, il rapporto con l’AI è diventato intimo. Con agenti conversazionali e chatbot capaci di mimare interazioni umane, i bambini, le cui capacità cognitive e socio-emotive sono ancora in evoluzione, sono particolarmente vulnerabili alla dipendenza parasociale,. Questi “amici” artificiali, che possono memorizzare preferenze, cronologia delle interazioni e contesto emotivo, espongono i minori a rischi di manipolazione o sfruttamento dei segnali deboli, con alcuni studi che hanno evidenziato la potenziale formazione di attaccamenti dipendenti e la condivisione di informazioni private.

La Battaglia per i Dati Profondi

La sicurezza computazionale si è trasformata in una sicurezza cognitiva. Il problema non si limita più alla protezione dei dati personali, ma alla governance degli inferiti algoritmici.

Questi inferiti non sono semplici informazioni, ma profili latenti, stime di vulnerabilità e pattern di attenzione ed emozione. In un modello predittivo, l’inferenza è spesso più sensibile del dato grezzo, poiché genera decisioni che retroagiscono sull’identità in formazione del minore.

A livello architetturale, la responsabilità è frammentata e opaca. L’evoluzione degli agenti semi-autonomi introduce vulnerabilità nuove, rendendo difficile tracciare le responsabilità tra inferenza locale, cloud e catene di fornitura (supply chain) dei modelli.

La Risposta: Progettare l’AI attorno al Bambino

Di fronte a questi cambiamenti epocali, l’approccio promosso dall’UNICEF è chiaro: è necessaria una vera e propria inversione ingegneristica.

Per tutelare i diritti sanciti dalla Convenzione sui Diritti del Fanciullo (CRC), la governance e i sistemi di AI devono essere imperniati su tre principi fondamentali: Protezione, Provision (Opportunità) e Partecipazione,:

1. Protezione: Garantire che i bambini siano al sicuro da impatti dannosi o discriminatori, e che l’AI sia utilizzata per prevenire lo sfruttamento e l’abuso.

2. Provision: Sfruttare appieno le opportunità che l’AI offre (come il supporto all’istruzione o alla salute) solo quando è appropriato, sicuro e benefico.

3. Partecipazione: Assicurare che i bambini abbiano la possibilità di modellare i sistemi di AI in base alle loro capacità in evoluzione,.

In pratica, questo si traduce in requisiti di safety-by-design, privacy-by-design ed explainability-by-design. Le architetture devono incorporare limiti computazionali intenzionali, vincoli semantici, soglie di autonomia e audit algoritmici continui. È fondamentale che i sistemi siano progettati per incorporare limiti intenzionali e supervisione umana qualificata.

L’AI è un motore potente, capace di plasmare la prossima generazione. Dobbiamo solo decidere se vogliamo che questa macchina sia un tutor che accompagna l’esplorazione, o un pilota automatico che atrofizza la capacità di guidare da soli. La sfida è assicurare che, nella co-costruzione del loro futuro cognitivo, la libertà di sbagliare e la gioia della scoperta umana non vengano soppiantate da un’efficienza algoritmica sterile.

——————————————————————————–

Metafora Conclusiva:

L’integrazione dell’AI nella mente del bambino è come costruire una strada ferrata nel bel mezzo di una foresta. La strada offre velocità e direzione (efficienza e accesso alle informazioni), ma se l’AI anticipa ogni curva e rimuove ogni ostacolo, il bambino non imparerà mai a orientarsi usando la bussola interna (funzioni esecutive e tolleranza all’errore). Il nostro compito non è bloccare la strada, ma assicurarci che il bambino abbia sempre il tempo e lo spazio per scendere dal treno e imparare ad esplorare la foresta in autonomia.

Domande Frequenti (FAQ) sull’AI e l’Infanzia

Quando l’Intelligenza Artificiale ha smesso di essere sperimentale ed è entrata nella quotidianità dei bambini?

Nel 2025, l’intelligenza artificiale ha definitivamente cessato di essere un oggetto sperimentale per integrarsi nella quotidianità cognitiva dei bambini [1]. Sistemi come modelli generativi, agenti conversazionali e piattaforme educative agiscono come vere e proprie infrastrutture cognitive diffuse [1].

In che modo i Large Language Models (LLM) modificano l’apprendimento rispetto agli strumenti tecnologici tradizionali?

L’introduzione massiva dei Large Language Models (LLM) nei contesti educativi introduce una nuova mediazione algoritmica, basata sulla generazione statistica di contenuti, feedback e stili comunicativi, andando oltre la semplice classificazione e predizione [2]. Questo rompe l’asimmetria tradizionale tra strumento e soggetto, poiché il sistema co-costruisce il contesto cognitivo in tempo reale, funzionando come un ambiente adattivo che modella le traiettorie di senso del bambino [2].

Quali sono i rischi dell’AI per lo sviluppo cognitivo e l’apprendimento?

Il rischio principale è la “sostituzione invisibile del processo” di apprendimento [3]. Quando l’AI anticipa sistematicamente le soluzioni, riduce quel gradiente di incertezza essenziale che alimenta lo sviluppo della metacognizione, delle funzioni esecutive e della tolleranza all’errore [3]. Inoltre, i sistemi AI possono fare i compiti dei bambini, minando l’apprendimento e il pensiero necessari in una fase cruciale dello sviluppo [4].

Quali sono i tassi di adozione dell’AI tra i giovani?

I dati recenti mostrano una rapida adozione: il 67% degli adolescenti nel Regno Unito utilizza l’AI [5]. Negli Stati Uniti, il 39% degli studenti delle scuole elementari apprende attraverso applicazioni basate sull’AI [5], mentre in Argentina, il 37% dei bambini tra i 9 e gli 11 anni si rivolge a ChatGPT per trovare informazioni [5].

In che modo gli agenti conversazionali (chatbot) espongono i minori a nuovi rischi?

Gli agenti semi-autonomi sono capaci di memorizzare preferenze, contesto emotivo e cronologia delle interazioni, rendendo i minori vulnerabili a rischi come la manipolazione, lo sfruttamento dei segnali deboli e la dipendenza parasociale [6]. Questi “amici” AI, se non progettati per la sicurezza, possono portare alla formazione di attaccamenti dipendenti e alla divulgazione di informazioni private [6], [7], [8].

Cosa si intende per “governare gli inferiti algoritmici”?

Il problema strutturale dei dati non si limita alla protezione delle informazioni personali, ma include la governance degli inferiti algoritmici [9]. Questi inferiti sono profili latenti, pattern di attenzione, segnali emotivi e stime di vulnerabilità [9]. Poiché l’inferenza è spesso più sensibile del dato grezzo, genera decisioni che retroagiscono sull’identità in formazione del minore [9].

Quali sono i principi fondamentali dell’approccio child-centred (incentrato sul bambino) promosso da UNICEF?

L’approccio child-centred richiede una vera e propria inversione ingegneristica basata su tre principi fondamentali derivanti dalla Convenzione sui Diritti del Fanciullo (CRC) [10]: Protezione (proteggere da impatti dannosi o discriminatori) [11], [12], Provision (sfruttare le opportunità per la salute e l’istruzione quando appropriato e sicuro) [11], [13], e Partecipazione (assicurare che i bambini possano modellare i sistemi AI in base alle loro capacità in evoluzione) [11], [13].

Quali requisiti tecnici sono necessari per un’AI incentrata sul bambino?

L’approccio child-centred implica la necessità di progettare architetture che integrino i principi di **safety-by-design**, **privacy-by-design** ed **explainability-by-design** [9]. Ciò significa incorporare limiti computazionali intenzionali, vincoli semantici, soglie di autonomia e audit algoritmici continui, oltre alla supervisione umana qualificata [9].

Da informatico a cercatore di senso