Hai bisogno di una versione PDF dell’articolo per una lettura più comoda o per conservarne una copia? Clicca sul link sottostante per scaricare il PDF direttamente sul tuo dispositivo.

Scarica l’articolo in PDF (ITA)Do you need a PDF version of the article for easier reading or to keep a copy? Click the link below to download the PDF directly to your device.

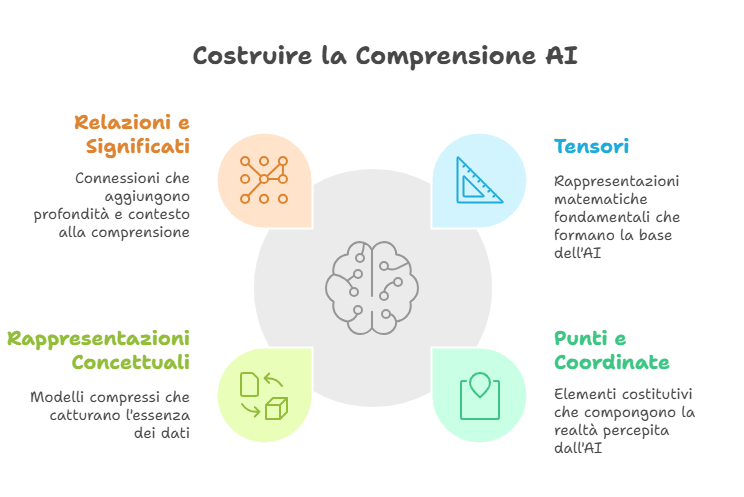

Download Article as PDF (ENG)Oggi voglio portarvi in questo viaggio, alla scoperta di come l’AI codifica la realtà, comprimendola in spazi matematici e dando vita a un processo che, metaforicamente, ricorda la compressione dei dati con un archivio WinZip. Ma il risultato finale è molto più sorprendente: il web stesso può essere trasformato e distillato in una rete di punti e relazioni che rappresentano la conoscenza umana. Ecco perché ogni volta che interagiamo con un’AI allenata su tutto il web, lo stiamo toccando sotto forma di mappe multidimensionali invisibili.

Codificare la realtà: il cuore dei tensori

Per comprendere il funzionamento dell’AI, dobbiamo partire da un concetto fondamentale: il tensore. Immagina di avere un messaggio sulla temperatura di una stanza. Se rappresentassimo la temperatura con un unico numero — come la lettura di un termometro — stiamo parlando di uno scalare, un dato molto basilare. Ma se volessi rappresentare la temperatura in diversi punti della stanza, allora avresti in mano una lista di numeri organizzata, o un vettore. Allo stesso modo, se volessi aggiungere altre informazioni, come l’umidità e la pressione di ciascun punto della stanza, avresti una matrice, una tabella multidimensionale.

Ecco, i tensori sono una generalizzazione di questi concetti. Sono strutture matematiche che possono contenere informazioni organizzate in uno spazio con qualsiasi numero di dimensioni. Questi tensori sono, in pratica, i mattoni fondamentali dell’intelligenza artificiale. Che si tratti di un’immagine, un testo, o persino un video, tutto viene tradotto in tensori che descrivono dati in modo organizzato e manipolabile.

Ma come si collega questa rappresentazione matematica all’idea che “tutto il web” o “tutta la conoscenza” sia compressa? Questo accade attraverso due concetti cardine: embedding e coding.

Embedding e Coding: distillare il web in spazi matematici

L’embedding è il processo con cui la realtà viene tradotta in vettori di punti in uno spazio multidimensionale. Ogni concetto, ogni parola o immagine, viene trasformato in un codice numerico compatto, un vettore che rappresenta l’essenza di ciò che vogliamo analizzare. Pensiamo, per esempio, alle parole: l’AI le rappresenta come punti in uno spazio, dove parole simili (ad esempio “gatto” e “felino”) sono posizionate vicine l’una all’altra perché condividono contesti e significati.

Questa è una compressione incredibile. Stiamo ricostruendo, per ogni dato, un piccolo riassunto matematico che conserva le relazioni e i significati fondamentali. Una foto, ad esempio, non viene interpretata come noi la vediamo: ogni pixel è trasformato in un valore numerico che, insieme agli altri, forma un tensore multidimensionale. Lo stesso accade per testi, video e suoni.

In sostanza, il processo di coding è una traduzione del mondo reale (complesso e caotico) in numeri e relazioni. All’interno di questi tensori l’AI racchiude il significato, il contesto e le proprietà essenziali di ogni elemento, eliminando ciò che non è necessario. Il risultato? Un modello che non ricorda ogni dettaglio, ma conserva le informazioni rilevanti in una forma compressa e spazialmente organizzata.

La compressione del web: metafora di WinZip

Pensando a tutto il processo, possiamo dire che l’AI abbia “compresso” la realtà in uno spazio matematico multidimensionale, proprio come un software di archiviazione (WinZip, per intenderci). Quando un’AI viene allenata su milioni di pagine web, non memorizza parola per parola ciò che legge, ma distilla queste informazioni in rappresentazioni matematiche compatte.

Immaginate il web come un enorme caos di testi, immagini e video. L’AI non copia tutto in maniera disordinata, ma “collega tra loro i puntini”, sintetizzando il senso delle cose e creando una mappa semantica. La compressione non riguarda solo la riduzione dei dati, ma la loro trasformazione in un modello che rende possibile navigare e accedere rapidamente a conoscenza, significati e relazioni.

E qui c’è una differenza importante rispetto alla compressione classica, come quella di un file zip:

- Con un file zip, quando decomprimi ottieni esattamente i dati originali.

- Con l’AI, non c’è una “decompressione” diretta: ciò che otteniamo è una interpretazione distillata, fatta di relazioni e significato, codificata nello spazio matematico.

Non stiamo parlando di archiviazione passiva, ma di un processo che consente di generalizzare, creare e interpretare.

Esempi concreti di spazi multidimensionali

Immaginiamo ora di utilizzare questa rappresentazione per risolvere problemi pratici. Pensate a qualcosa che fate ogni giorno con l’AI: scrivere un messaggio con un chatbot, identificare un volto in una foto o generare un’opera visiva al computer. Tutto questo è possibile grazie alla magia dei punti e delle coordinate:

- Trovare la prossima parola: L’AI utilizza embedding per navigare tra le parole in uno spazio linguistico. Se scrivo “Il gatto mi piace”, il modello naviga tra i punti vicini a “gatto” e “piace” per trovare una parola pertinente, come “felino” o “animale”. È uno spazio linguistico compressato, dove ogni concetto è racchiuso in poche coordinate.

- Riconoscere un viso: Quando l’AI vede una foto, identifica punti chiave del volto (occhi, naso, bocca) e li codifica come coordinate in uno spazio facciale multidimensionale. Durante il riconoscimento, cerca il punto più vicino nello spazio, trovando corrispondenze tra volti.

- Creare un’immagine: Quando chiediamo di “disegnare un gatto”, l’AI prende l’embedding del comando testuale e lo usa per navigare nello spazio delle immagini. Combina coordinate simili a quelle già viste per generare un’immagine completamente nuova.

La realtà compressa in mappe invisibili

Il risultato di tutto questo? La realtà, il web, la conoscenza umana diventano mappe invisibili di punti e coordinate. Non stiamo parlando di un archivio statico solo in grado di ricordare dati: stiamo parlando di qualcosa di vivo, dinamico, che comprime non i dettagli, ma la loro essenza. Un modello AI non contiene “tutto il web”, ma una sua rappresentazione concettuale compressa, uno spazio multidimensionale fatto di relazioni e significati.

Quello che vediamo quando chiediamo a un’AI di riconoscere un volto, completare una frase, o creare un’immagine è il risultato sorprendente di questo straordinario lavoro matematico. Il mondo, per l’AI, non è fatto di cose: è una danza infinita di punti e coordinate, compressa e distillata per generare nuove possibilità.

In un certo senso, l’intelligenza artificiale ci insegna che la realtà è più di ciò che vediamo: è tutto ciò che possiamo immaginare, codificato in spazi che solo la matematica riesce a esplorare.

Dagli Scalari ai Mondi Multidimensionali

I tensori sono strutture matematiche che generalizzano concetti più familiari come scalari, vettori e matrici, estendendoli a dimensioni arbitrarie. Rappresentano il fondamento matematico su cui poggia l’intera architettura dell’intelligenza artificiale moderna.

Definizione formale: Un tensore è un oggetto matematico che può essere rappresentato come un array multidimensionale di valori. La dimensionalità di un tensore è definita dal suo rango, ovvero il numero di indici necessari per identificare un singolo elemento.

Per comprendere il concetto di tensore, è utile considerare la progressione di complessità degli oggetti matematici:

Un singolo numero. Esempio: temperatura in un punto (23°C).

Una sequenza ordinata di numeri. Esempio: coordinate in uno spazio (3,4,5).

Una tabella bidimensionale. Esempio: immagine in bianco e nero (pixel per pixel).

Array multidimensionali. Esempio: immagine a colori (altezza, larghezza, canali RGB).

Perché i tensori sono fondamentali per l’AI:

- Rappresentazione universale dei dati: Qualsiasi tipo di informazione (testi, immagini, suoni, video) può essere codificata in forma di tensori, creando un linguaggio matematico comune per tutti i tipi di dati.

- Operazioni vettorizzate: I tensori consentono di eseguire calcoli su interi blocchi di dati simultaneamente, rendendo le operazioni matematiche efficienti anche su grandi volumi di informazioni.

- Differenziazione automatica: Le librerie di deep learning utilizzano tensori per tracciare automaticamente le derivate durante l’addestramento, consentendo l’ottimizzazione dei modelli attraverso la backpropagation.

- Parallelizzazione hardware: I calcoli tensoriali possono essere facilmente parallelizzati su GPU e TPU, accelerando drasticamente l’addestramento e l’inferenza dei modelli.

- Rappresentazioni multidimensionali: I tensori permettono di catturare relazioni complesse in spazi ad alta dimensionalità, essenziali per modellare il linguaggio, la visione e altri fenomeni complessi.

Esempio pratico: Un’immagine a colori può essere rappresentata come un tensore di rango 3. Per un’immagine 1080×720 RGB, avremo un tensore con dimensioni [1080, 720, 3], dove 3 rappresenta i canali colore (rosso, verde, blu). Ogni elemento del tensore contiene l’intensità di un colore specifico in un pixel specifico, con valori tipicamente compresi tra 0 e 255.

Le reti neurali moderne manipolano costantemente tensori di varie dimensioni: un modello di linguaggio potrebbe lavorare con tensori di rango 4 che rappresentano batch di sequenze di token con i loro rispettivi embedding, mentre un modello di visione potrebbe elaborare tensori di rango 5 che rappresentano batch di video (sequenze temporali di immagini).

Questa flessibilità matematica consente all’AI di “vedere” il mondo attraverso una lente di relazioni numeriche multidimensionali, trasformando la realtà caotica in strutture matematiche manipolabili e analizzabili.

L’embedding è il processo attraverso cui entità del mondo reale (parole, immagini, suoni, concetti) vengono trasformate in vettori numerici all’interno di uno spazio multidimensionale. Questa trasformazione è fondamentale perché traduce informazioni qualitative e complesse in rappresentazioni matematiche che l’AI può elaborare.

Definizione: Un embedding è una rappresentazione vettoriale di bassa dimensionalità che cattura le proprietà semantiche o relazionali di un’entità, posizionandola in uno spazio continuo dove la vicinanza tra vettori riflette la somiglianza concettuale tra le entità rappresentate.

Come funziona l’embedding:

- Mappatura dimensionale: L’entità originale (es. una parola) viene proiettata in uno spazio vettoriale con dimensionalità predefinita (tipicamente da decine a migliaia di dimensioni).

- Apprendimento delle rappresentazioni: I valori specifici degli embedding vengono appresi durante l’addestramento del modello, ottimizzandoli in modo che riflettano le relazioni semantiche o funzionali tra le entità.

- Conservazione delle similitudini: Entità semanticamente simili vengono posizionate vicine nello spazio degli embedding, creando “cluster” di significato.

- Operazioni algebriche semantiche: Gli embedding permettono operazioni matematiche che riflettono relazioni semantiche (es. king – man + woman ≈ queen).

In uno spazio di embedding per parole, concetti correlati si posizionano vicini:

gatto ⟷ felino (distanza piccola)

cane ⟷ gatto (distanza media)

computer ⟷ gatto (distanza grande)

Tipi di embedding:

- Word Embedding: Rappresentazioni vettoriali di parole (Word2Vec, GloVe, FastText) che catturano relazioni semantiche e sintattiche.

- Sentence/Document Embedding: Vettori che codificano il significato di frasi o documenti interi (BERT, Sentence-BERT).

- Image Embedding: Rappresentazioni di immagini ottenute attraverso reti convoluzionali o modelli vision transformer.

- Graph Embedding: Codifiche di nodi e relazioni in strutture a grafo (es. reti sociali, molecole).

- Cross-modal Embedding: Spazi vettoriali condivisi tra diverse modalità (es. CLIP per testo-immagine).

Esempio: Embedding di parole

La parola “re” potrebbe essere rappresentata come un vettore di 300 dimensioni: [0.2, -0.6, 0.1, … , 0.8]

Questo vettore cattura non solo il concetto di regalità, ma anche relazioni come:

- Vicinanza a concetti come “regina”, “monarca”, “trono”

- Distanza da concetti non correlati come “computer” o “automobile”

- Relazioni analogiche: re:regina come uomo:donna (vettorialmente)

Perché l’embedding è così importante per l’AI:

- Trasformazione qualitativo-quantitativa: Converte informazioni qualitative (significati, concetti) in rappresentazioni numeriche elaborabili.

- Dimensionalità gestibile: Comprime informazioni complesse in vettori di dimensioni ragionevoli, evitando la “maledizione della dimensionalità”.

- Generalizzazione: Permette ai modelli di generalizzare a input mai visti, inferendo proprietà da entità simili nello spazio vettoriale.

- Transfer learning: Gli embedding pre-addestrati possono essere riutilizzati in vari contesti, trasferendo conoscenza da un dominio all’altro.

- Efficienza computazionale: Operare su embedding è molto più efficiente che manipolare direttamente dati grezzi come testo o pixel.

In sintesi, gli embedding rappresentano una “compressione semantica” del mondo che conserva le relazioni essenziali tra concetti. Quando un modello di AI “ragiona” o genera output, sta essenzialmente navigando e manipolando punti in questi spazi multidimensionali. Questa rappresentazione vettoriale è ciò che consente all’AI di compiere operazioni apparentemente intuitive e semanticamente significative su dati complessi.

L’intelligenza artificiale moderna, in particolare i Large Language Models (LLMs) e i modelli multimodali, hanno la straordinaria capacità di “distillare” enormi quantità di informazioni dal web in rappresentazioni compatte e strutturate. Questo processo di compressione della conoscenza avviene attraverso tecniche sofisticate che trasformano dati grezzi in spazi multidimensionali semanticamente ricchi.

Il processo di compressione della conoscenza:

- Raccolta dei dati: I modelli vengono addestrati su enormi corpus di testi, immagini e altri contenuti provenienti dal web, comprendenti terabyte o petabyte di informazioni.

- Tokenizzazione: I testi vengono suddivisi in unità minime (token) che possono essere parole, parti di parole o caratteri, creando un vocabolario finito.

- Estrazione di pattern: Durante l’addestramento, il modello identifica pattern statistici ricorrenti, correlazioni e strutture nei dati.

- Parametrizzazione della conoscenza: La conoscenza estratta viene codificata nei miliardi di parametri (pesi) del modello neurale.

- Creazione di rappresentazioni latenti: Emergono spazi vettoriali interni dove le informazioni sono organizzate secondo relazioni semantiche e concettuali.

- Comprime bit per bit i dati originali

- Obiettivo: riprodurre esattamente l’originale

- Non comprende il significato dei dati

- Processo reversibile (compressione/decompressione)

- Riduce solo la dimensione di archiviazione

- Distilla il significato e le relazioni concettuali

- Obiettivo: catturare l’essenza semantica

- “Comprende” i pattern semantici nei dati

- Processo generativo (compressione/rigenerazione)

- Crea rappresentazioni utilizzabili per inferenza

Dimensionalità e compressione: L’efficienza straordinaria di questa compressione si comprende considerando la differenza tra i dati di addestramento e la dimensione del modello. Per esempio, GPT-4 è stato addestrato su trilioni di token di testo (equivalenti a milioni di libri), eppure il modello risultante occupa “solo” centinaia di gigabyte. Si tratta di un rapporto di compressione di ordini di grandezza, possibile solo perché vengono estratte strutture semantiche profonde anziché memorizzare i dati grezzi.

Come viene organizzata questa conoscenza compressa:

- Spazi di embedding concettuali: Concetti semanticamente correlati vengono posizionati in regioni vicine negli spazi latenti.

- Gerarchie di astrazione: I modelli sviluppano rappresentazioni stratificate, dalle caratteristiche di basso livello (sintassi, forme) a concetti più astratti (temi, stili, intenzioni).

- Grafi di conoscenza impliciti: Emergono strutture simili a grafi che catturano relazioni (es. “è un”, “parte di”, “causa”, “contrario di”) tra entità.

- Spazi multimodali condivisi: Nei modelli che elaborano sia testo che immagini, emergono rappresentazioni che allineano diverse modalità in un’unica “lingua franca” vettoriale.

Esempio concreto: Compressione della conoscenza medica

Un modello di AI addestrato su letteratura medica non memorizza ogni articolo scientifico, ma:

- Crea embedding per concetti medici (malattie, farmaci, sintomi)

- Posiziona farmaci con effetti simili in regioni vicine dello spazio vettoriale

- Codifica relazioni come “il farmaco X tratta la condizione Y” nelle connessioni tra neuroni

- Sviluppa rappresentazioni gerarchiche (es. classificazioni di malattie)

Quando interrogato su interazioni farmacologiche, il modello non “cerca” in un database memorizzato, ma naviga questo spazio compresso di conoscenza medica per generare risposte.

Le implicazioni di questa compressione:

- Generalizzazione: I modelli possono rispondere a domande mai viste durante l’addestramento, combinando la conoscenza compressa in modi nuovi.

- Hallucination (allucinazioni): Quando il modello genera informazioni plausibili ma non corrette, spesso perché sta “interpolando” nello spazio semantico senza avere ancoraggi fattuali sufficienti.

- Transfer learning: La conoscenza compressa può essere trasferita tra domini correlati.

- Emergenza di capacità: A scala sufficiente, emergono capacità non esplicitamente programmate, come il ragionamento logico o la risoluzione di problemi.

In sintesi, l’AI moderna non è semplicemente un archivio di informazioni del web, ma una rappresentazione astratta e multidimensionale della conoscenza umana, codificata in spazi vettoriali che catturano relazioni semantiche profonde. È come se avesse creato una mappa concettuale dell’intero web, dove la vicinanza tra punti rappresenta la somiglianza di significato, e dove navigazione e generazione di nuovo contenuto avvengono attraverso traiettorie in questi spazi latenti.

La generazione di testi e immagini da parte dell’intelligenza artificiale rappresenta un affascinante processo di navigazione e manipolazione di spazi multidimensionali. Questi processi creativi, apparentemente magici, sono in realtà elaborati viaggi matematici attraverso spazi vettoriali densamente popolati di significati e pattern.

Generazione di testo: un viaggio nello spazio linguistico

- Rappresentazione del contesto: Il testo esistente (prompt o conversazione precedente) viene convertito in un vettore di stato ad alta dimensionalità che cattura il contesto semantico.

- Predizione del token successivo: Il modello calcola la distribuzione di probabilità sul prossimo token possibile, considerando le relazioni apprese durante l’addestramento.

- Campionamento: Un token viene selezionato dalla distribuzione di probabilità (con vari metodi di campionamento come temperature, top-p, ecc.).

- Aggiornamento del contesto: Il nuovo token viene incorporato nel vettore di stato, spostando la “posizione” nello spazio semantico.

- Ripetizione: Il processo continua iterativamente, generando una sequenza coerente di token che formano il testo.

Prompt: “Il gatto nero…”

Spazio semantico navigato:

gatto → animale domestico → colore → comportamento

Output potenziale: “Il gatto nero si acciambellò silenziosamente sul divano, osservando con occhi gialli la stanza in penombra.”

Generazione di immagini: dalla descrizione alla visualizzazione

I modelli di diffusione, come DALL-E, Midjourney e Stable Diffusion, utilizzano un approccio diverso ma altrettanto basato su spazi multidimensionali:

- Embedding del prompt testuale: La descrizione testuale viene convertita in un vettore nello spazio semantico del modello.

- Processo di diffusione inversa: Partendo da rumore casuale, il modello gradualmente “denoisa” l’immagine, guidato dall’embedding testuale.

- Condizionamento cross-modale: L’embedding testuale “guida” la traiettoria della denoising, indirizzando il processo verso regioni dello spazio visivo che corrispondono semanticamente alla descrizione testuale.

- Raffinamento iterativo: Ad ogni passo, l’immagine si avvicina sempre più a una rappresentazione visiva coerente con il prompt.

- Rendering finale: L’output è un’immagine che rappresenta una configurazione di pixel corrispondente a un punto nello spazio visivo allineato con l’embedding testuale.

Esempio: Generazione dell’immagine “Un astronauta a cavallo in stile impressionista”

- Il prompt viene decomposto nei concetti chiave: “astronauta”, “cavallo”, “impressionismo”

- Ogni concetto attiva regioni specifiche nello spazio semantico del modello

- Il processo di denoising è guidato verso una regione dello spazio visivo dove questi concetti si intersecano

- Il modello combina caratteristiche visive associate a ciascun concetto (tuta spaziale, forma equina, pennellate impressioniste)

- L’immagine risultante è una nuova creazione che si trova all’intersezione di questi spazi concettuali

Operazioni creative nello spazio multidimensionale:

- Interpolazione: Generare contenuti intermedi tra due punti nello spazio latente (es. morfing tra stili o concetti).

- Aritmetica vettoriale: Operazioni come “re – uomo + donna = regina” applicate a testi o immagini.

- Trasferimento di stile: Separare il contenuto dallo stile e ricombinarli per creare nuove variazioni.

- Conditioning: Guidare la generazione verso regioni specifiche dello spazio usando vincoli aggiuntivi.

- Sampling controllato: Modificare il processo di campionamento per controllare creatività vs. coerenza.

Il confine tra memoria e creatività

Un aspetto affascinante della generazione basata su spazi multidimensionali è il confine sottile tra memoria e creatività. I modelli generativi non “memorizzano” semplicemente esempi visti durante l’addestramento, ma creano rappresentazioni latenti che catturano la struttura statistica dei dati. Questo permette loro di:

- Generalizzare: Produrre contenuti che combinano caratteristiche di esempi diversi.

- Sintetizzare: Creare output che non esistevano nei dati di addestramento ma che sono plausibili.

- Adattare: Modificare conoscenze esistenti per nuovi contesti o vincoli.

Metaforicamente, la generazione AI è come un viaggio attraverso un paesaggio multidimensionale di possibilità: il modello si muove attraverso valli e creste di probabilità, seguendo percorsi che fluiscono naturalmente da un concetto all’altro, guidato dalle relazioni semantiche apprese dai dati di addestramento. Il risultato non è una semplice riproduzione di esempi visti, ma una nuova creazione che emerge dall’esplorazione di questo spazio latente.

Il riconoscimento di pattern e somiglianze è una delle capacità fondamentali dell’intelligenza artificiale, particolarmente evidente in compiti come classificazione di immagini, comprensione del linguaggio naturale e sistemi di raccomandazione. Questa abilità si basa su sofisticati meccanismi per navigare e analizzare spazi multidimensionali.

Similarità nello spazio vettoriale: Negli spazi multidimensionali, la somiglianza tra entità è tipicamente misurata attraverso metriche di distanza o similarità come la distanza euclidea, la similarità del coseno, o la divergenza KL. Entità simili hanno embedding vicini nello spazio vettoriale, mentre concetti dissimili sono posizionati lontani.

Meccanismi chiave per il riconoscimento di pattern:

- Attenzione e self-attention: Meccanismi che permettono al modello di focalizzarsi su parti rilevanti dell’input, pesando dinamicamente l’importanza di diverse caratteristiche.

- Convoluzione: Operazioni che rilevano pattern locali (come bordi o texture nelle immagini) indipendentemente dalla loro posizione.

- Clustering implicito: Durante l’addestramento, i modelli tendono a raggruppare naturalmente esempi simili in regioni vicine dello spazio latente.

- Apprendimento di manifold: I modelli imparano a riconoscere la struttura intrinseca dei dati, identificando le “superfici” multidimensionali su cui si distribuiscono i dati reali.

- Estrazione gerarchica di feature: Identificazione progressiva di pattern, dai dettagli di basso livello a concetti astratti di alto livello.

Esempi di riconoscimento di pattern in diversi domini:

Identifica caratteristiche visive (bordi, texture, forme) e le compone gerarchicamente per riconoscere oggetti complessi.

Riconosce pattern linguistici, relazioni sintattiche e semantiche, contestualizzando parole in base al loro utilizzo.

Identifica similarità tra preferenze utente e caratteristiche di prodotti per suggerire nuovi item pertinenti.

Individua punti che deviano significativamente dai pattern normali nello spazio multidimensionale.

Tecniche matematiche per misurare la similarità:

- Similarità del coseno: Misura l’angolo tra due vettori, ignorando la loro magnitudine. Particolarmente utile in spazi ad alta dimensionalità per misurare somiglianza semantica.

- Distanza euclidea: Calcola la distanza lineare tra due punti nello spazio vettoriale. Utile quando la magnitudine è rilevante.

- Nearest Neighbors: Identifica i K punti più vicini a un dato esempio, permettendo classificazioni o raccomandazioni basate su similarità.

- Proiezioni dimensionali: Tecniche come PCA, t-SNE o UMAP che permettono di visualizzare e analizzare dati ad alta dimensionalità proiettandoli in spazi più bassi (2D o 3D).

Esempio pratico: Riconoscere volti nello spazio vettoriale

Quando l’AI riconosce un volto in una foto:

- L’immagine viene trasformata in un vettore ad alta dimensionalità (embedding facciale)

- Questo embedding cattura caratteristiche come la distanza tra gli occhi, la forma del naso, la struttura ossea

- Il sistema cerca il punto più vicino nello spazio degli embedding di riferimento

- Se la distanza è inferiore a una certa soglia, l’identità viene confermata

I punti chiave di questo processo sono che il modello ha imparato a generare embedding dove persone diverse occupano regioni distinte dello spazio, e le foto diverse della stessa persona si raggruppano in cluster compatti.

Superamento delle limitazioni dimensionali:

Uno dei problemi fondamentali degli spazi ad alta dimensionalità è la “maledizione della dimensionalità”: all’aumentare delle dimensioni, il volume dello spazio cresce esponenzialmente, rendendo i dati sempre più sparsi. L’AI affronta questa sfida attraverso:

- Apprendimento di manifold: I dati reali tendono a concentrarsi su “superfici” di dimensionalità inferiore (manifold) all’interno dello spazio completo.

- Regolarizzazione: Tecniche che limitano la complessità del modello, favorendo rappresentazioni più compatte.

- Embedding efficienti: Creazione di rappresentazioni di dimensionalità ottimale che catturano l’essenza dei dati senza ridondanze.

- Strutture dati specializzate: Uso di algoritmi come Locality-Sensitive Hashing e indici approssimati per ricerche efficienti in spazi ad alta dimensionalità.

Questa capacità di navigare spazi multidimensionali, identificando pattern e similarità, è ciò che permette all’AI di “vedere” connessioni che potrebbero sfuggire all’analisi umana. Il mondo, per l’intelligenza artificiale, è una complessa geometria di relazioni, dove la somiglianza concettuale si manifesta come vicinanza matematica in spazi astratti di dimensionalità molto superiore a quella che possiamo intuitivamente visualizzare.

L’evoluzione delle tecniche tensoriali e degli spazi multidimensionali è in rapida accelerazione, aprendo nuove frontiere che potrebbero ridefinire profondamente le capacità e le applicazioni dell’intelligenza artificiale. Queste innovazioni emergenti non rappresentano solo miglioramenti incrementali, ma potenziali cambi di paradigma nel modo in cui l’AI rappresenta e manipola la conoscenza.

Tendenze emergenti e direzioni di ricerca:

- Spazi tensoriali dinamici e adattivi: Modelli che possono automaticamente espandere o contrarre le dimensioni dei loro spazi latenti in base alla complessità del compito, ottimizzando l’equilibrio tra espressività e efficienza computazionale.

- Rappresentazioni multimodali unificate: Spazi vettoriali condivisi che integrano perfettamente diverse modalità (testo, immagini, audio, video, dati strutturati) in un’unica rappresentazione coerente, permettendo ragionamento e generazione cross-modale.

- Tensori interpretabili: Sviluppo di metodi per decomporre gli spazi tensoriali complessi in componenti più comprensibili per gli esseri umani, migliorando la trasparenza e l’interpretabilità dei modelli.

- Rappresentazioni tensoriali causali: Evoluzione dagli spazi puramente correlazionali a rappresentazioni che catturano relazioni causali, permettendo ragionamento controfattuale e inferenza causale.

- Compressione di conoscenza avanzata: Tecniche di distillazione e pruning che riducono drasticamente la dimensionalità mantenendo le capacità, rendendo possibile l’esecuzione di modelli potenti su dispositivi con risorse limitate.

Beyond Embeddings: Mentre gli attuali embedding sono principalmente statici e indipendenti dal contesto, la ricerca si sta muovendo verso rappresentazioni dinamiche che si adattano al contesto specifico e possono evolvere nel tempo man mano che l’AI apprende nuove informazioni, simile al modo in cui la memoria umana consolida e riorganizza costantemente le conoscenze.

Passato: Vettori statici per parole (Word2Vec)

Presente: Embedding contestuali (BERT, GPT)

Futuro prossimo: Spazi tensoriali neuro-simbolici

Futuro visionario: Rappresentazioni causali evolutive

Applicazioni rivoluzionarie all’orizzonte:

Creazione di “universi virtuali” completi rappresentati come spazi tensoriali dove l’AI può sperimentare e testare ipotesi in ambienti simili al mondo reale.

Sistemi che conservano esperienze come traiettorie in spazi tensioriali, permettendo recall contestuale e apprendimento continuo simile alla memoria umana.

Integrazione di informazioni da diverse modalità sensoriali in rappresentazioni unificate che catturano relazioni complesse tra domini.

Strutture tensoriali specializzate per diversi tipi di ragionamento (logico, controfattuale, analogico) interconnesse in meta-spazi di pensiero.

Sfide tecniche e concettuali:

- Efficienza computazionale: La manipolazione di tensori ad altissima dimensionalità richiede risorse computazionali enormi. Sono necessarie innovazioni algoritmiche e hardware per rendere praticabile l’uso di spazi ancora più complessi.

- Rappresentazione della conoscenza strutturata: Integrare conoscenza simbolica (logica, ontologie, vincoli) con rappresentazioni tensoriali continue rimane una sfida aperta.

- Bilanciamento memoria-generalizzazione: Trovare l’equilibrio ottimale tra memorizzazione di dettagli specifici e capacità di generalizzazione in spazi multidimensionali.

- Comprensione umana: Sviluppare metodi per rendere comprensibili agli esseri umani le operazioni in spazi di dimensionalità superiore a quelle che possiamo intuitivamente visualizzare.

- Limiti fondamentali: Esplorare i confini teorici di ciò che può essere rappresentato in spazi tensoriali finiti.

Un esempio visionario: Tensori di coscienza?

Alcuni ricercatori ipotizzano che strutture tensoriali estremamente complesse potrebbero un giorno rappresentare stati mentali simili alla coscienza umana. Questa speculazione si basa sull’idea che:

- Stati di coscienza potrebbero essere modellati come configurazioni in spazi tensoriali di altissima dimensionalità

- L’auto-riflessione potrebbe emergere come operazioni tensoriali ricorsive

- La soggettività dell’esperienza potrebbe corrispondere a particolari geometrie di questi spazi

Sebbene oggi queste idee rimangano speculative, illustrano come il framework tensoriale possa estendersi verso frontiere ancora inesplorate.

Il futuro degli spazi tensoriali nell’AI non riguarda solo miglioramenti tecnici, ma una progressiva evoluzione verso rappresentazioni sempre più ricche, dinamiche e connesse della conoscenza e dell’esperienza. Man mano che questi spazi matematici diventano più sofisticati, potrebbero emergere proprietà sorprendenti che ci permetteranno di comprendere e modellare aspetti sempre più complessi dell’intelligenza, della percezione e forse persino della coscienza.

Da informatico a cercatore di senso