Hai bisogno di una versione PDF dell’articolo per una lettura più comoda o per conservarne una copia? Clicca sul link sottostante per scaricare il PDF direttamente sul tuo dispositivo.

Scarica l’articolo in PDF (ITA)Do you need a PDF version of the article for easier reading or to keep a copy? Click the link below to download the PDF directly to your device.

Download Article as PDF (ENG)Le innovazioni che stanno cambiando gli LLM

1. Claude 3.7 (Anthropic): Il modello “bifase”

Claude 3.7 funziona come un’auto che può passare dalla modalità “sportiva” a quella “eco”.

- Modalità avanzata: Usa tutta la sua potenza per compiti complessi (es. risolvere un problema matematico).

- Modalità leggera: Consuma meno energia per compiti semplici (es. rispondere a una domanda breve).

Perché è utile? Risparmia tempo ed energia senza perdere qualità.

2. LCM di Meta: Ragiona per concetti, non per parole

I vecchi modelli leggevano le parole una per una, come un bambino che impara a sillabare. LCM di Meta, invece, capisce il significato globale di un testo, un’immagine o un suono.

- Esempio: Se gli mostrate una foto di un gatto su un albero, LCM non pensa “g-a-t-t-o”, ma capisce il concetto “un animale in pericolo”.

Perché è utile? È più flessibile e capisce meglio il contesto, anche in lingue diverse.

3. Titan di Google: La memoria a lungo termine

Titan ha una “memoria” simile a quella umana.

- Come funziona? Ricorda informazioni importanti durante una conversazione (es. il nome del vostro cane menzionato 10 minuti prima).

- Vantaggio: Gestisce dialoghi lunghi senza perdere il filo, perfetto per assistenti virtuali o chatbot.

4. Transformer-squared di Sakana AI: Il modello “camaleonte”

Transformer-squared si adatta in tempo reale, come un camaleonte che cambia colore.

- Esempio: Se gli chiedete uno stile di scrittura informale, modifica immediatamente il tono senza bisogno di riprogrammazione.

Perché è utile? È più personalizzabile e versatile per esigenze specifiche.

5. DeepSeek: Impara velocemente, spendendo meno

DeepSeek è come uno studente che studia in modo intelligente, evitando di perdere tempo su cose inutili.

- Come funziona? Si allena solo su informazioni selezionate e di alta qualità (es. testi chiari e precisi).

- Vantaggio: Riduce i costi di addestramento e raggiunge ottimi risultati in meno tempo.

6. Mistral: Velocità e lavoro di squadra

Mistral è come un gruppo di esperti che collaborano:

- Sliding Window: Legge il testo “a pezzi” (come scorre una finestra), evitando di sovraccaricare la memoria.

- Mixture of Experts (MoE): Usa specialisti diversi per compiti diversi (es. uno per la grammatica, uno per il significato).

Perché è utile? È leggero, veloce e gira anche su computer normali.

Tabella comparativa per non esperti

| Modello | Innovazione | A cosa serve? | Vantaggio per l’utente |

|---|---|---|---|

| Claude 3.7 | Modalità “bifase” (avanzata/leggera) | Risparmiare energia senza perdere qualità | Risposte veloci e meno costose |

| LCM (Meta) | Ragiona per concetti, non per parole | Capire testi, immagini o audio in modo più naturale | Maggiore flessibilità e comprensione contestuale |

| Titan (Google) | Memoria a lungo termine | Ricordare dettagli in conversazioni lunghe | Dialoghi più coerenti e personalizzati |

| Transformer-squared | Adattamento in tempo reale | Cambiare stile o comportamento all’istante | Personalizzazione immediata senza attese |

| DeepSeek | Addestramento “smart” a basso costo | Ridurre tempo e soldi per creare il modello | Tecnologia più accessibile per tutti |

| Mistral | Velocità e lavoro di squadra (MoE) | Funzionare su computer normali con risultati rapidi | Usare un chatbot avanzato senza hardware costoso |

Recap

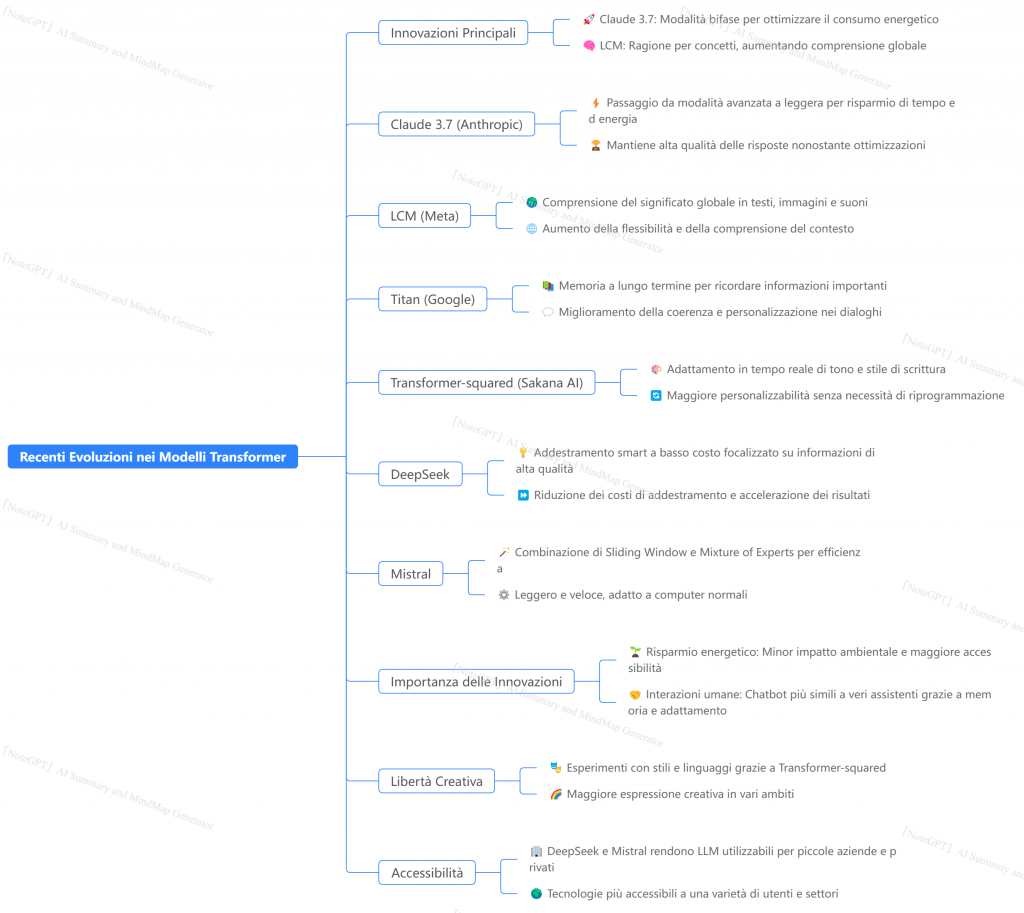

A beneficio di una maggiore comprensione, il report evidenzia le recenti evoluzioni nei modelli Transformer, focalizzandosi su come stanno diventando più intelligenti ed efficienti. Le innovazioni principali includono:

- Claude 3.7 (Anthropic): Implementa una modalità “bifase” per ottimizzare il consumo energetico, passando da una modalità avanzata per compiti complessi a una leggera per compiti semplici [Testo fornito]. Questo consente di risparmiare tempo ed energia senza compromettere la qualità delle risposte.

- LCM (Meta): Ragiona per concetti anziché per singole parole, comprendendo il significato globale di testi, immagini o suoni [Testo fornito]. Ciò aumenta la flessibilità e la comprensione del contesto, anche in lingue diverse.

- Titan (Google): Integra una memoria a lungo termine per ricordare informazioni importanti durante le conversazioni, migliorando la coerenza e la personalizzazione dei dialoghi [Testo fornito]. Questo è particolarmente utile per assistenti virtuali e chatbot che devono gestire interazioni prolungate.

- Transformer-squared (Sakana AI): Si adatta in tempo reale, modificando il tono e lo stile di scrittura in base alle richieste dell’utente senza bisogno di riprogrammazione [Testo fornito]. Questa capacità di adattamento immediato rende il modello più personalizzabile e versatile.

- DeepSeek: Utilizza un addestramento “smart” a basso costo, concentrandosi solo su informazioni selezionate e di alta qualità per ridurre i costi di addestramento e accelerare i risultati [Testo fornito]. Questo rende la tecnologia più accessibile.

- Mistral: Impiega una combinazione di “Sliding Window” per leggere il testo a pezzi e “Mixture of Experts (MoE)” per delegare compiti specifici a specialisti diversi, risultando leggero, veloce e adatto a computer normali [Testo fornito].

Queste innovazioni sono importanti perché portano a un risparmio energetico, interazioni più umane, maggiore libertà creativa e accessibilità ampliata. Il futuro dei modelli Transformer si prospetta sempre più orientato verso “cervelli digitali” efficienti, empatici e creativi, utilizzabili su dispositivi comuni e in diversi ambiti, dalla medicina all’assistenza clienti

PS: Mercury, il modello che corre più veloce del pensiero

Mentre gli LLM continuano a evolversi, Mercury si distingue come un vero pioniere. Sviluppato da Inception Labs (fondato dal professor Stefano Ermon di Stanford), Mercury non è solo un esperimento accademico, ma un modello pronto per rivoluzionare il mercato. Ho scritto recentemente un articolo in corrispondenza del seguente link: https://umanesimodigitale.info/mercury

Cosa lo rende speciale?

- Velocità da record: Mentre i modelli tradizionali generano al massimo 200 token al secondo, Mercury supera i 1.000 token al secondo su GPU standard. Un salto di 20 volte che riduce i tempi di attesa a quasi zero.

- Qualità senza compromessi: Nonostante la velocità, Mercury mantiene prestazioni competitive, dimostrando che i modelli basati sulla diffusione possono rivaleggiare con i migliori LLM autoregressivi.

- Accessibilità: Grazie a un uso efficiente delle GPU, Mercury riduce i costi di inferenza, rendendo l’IA di alta qualità più accessibile per startup, ricercatori e paesi in via di sviluppo.

Impatto pratico

- Applicazioni in tempo reale: Ideale per assistenti virtuali, strumenti di coding e sistemi di emergenza, dove ogni millisecondo conta.

- Flessibilità: Disponibile via API o on-premise, Mercury si adatta a esigenze specifiche, dal supporto clienti alla ricerca avanzata.

Una nuova era per l’IA

Mercury non è solo un’evoluzione tecnologica; è una forza democratizzante che rende l’IA più inclusiva e potente. Con la sua velocità straordinaria e la capacità di ridurre i costi, Mercury sta ridefinendo ciò che è possibile nel mondo dell’intelligenza artificiale.

Curiosità: Immaginate uno strumento di scrittura che genera bozze complete in pochi secondi o un assistente di ricerca che sintetizza articoli scientifici mentre leggete. Con Mercury, il futuro dell’IA non è solo veloce, ma anche alla portata di tutti. 🚀

Perché queste novità sono importanti?

- Risparmio energetico: Meno consumo = più accessibilità e minor impatto ambientale.

- Interazioni più umane: Memoria, adattamento e comprensione del contesto rendono i chatbot più simili a veri assistenti.

- Libertà creativa: Modelli come Transformer-squared permettono di sperimentare con stili e linguaggi inediti.

- Accessibilità: DeepSeek e Mistral rendono gli LLM utilizzabili anche da piccole aziende o privati.

Il futuro? Cervelli digitali sempre più “umani”

Queste innovazioni ci avvicinano a un futuro in cui l’intelligenza artificiale non sarà solo “potente”, ma anche:

- Efficiente: Girerà su smartphone o computer di casa (grazie a Mistral e DeepSeek).

- Empatica: Ricorderà preferenze e dettagli personali (grazie a Titan).

- Creativa: Inventerà storie, immagini o soluzioni in tempo reale (grazie a LCM e Transformer-squared).

Grazie a queste evoluzioni, gli LLM diventeranno strumenti sempre più utili nella vita quotidiana, dall’assistenza clienti alla medicina, senza richiedere supercomputer o team di ingegneri.

🤖 Transformer: Il Motore dell’IA Conversazionale

- Modalità avanzata: Utilizza tutta la potenza di calcolo disponibile per affrontare compiti complessi che richiedono ragionamento approfondito, come risolvere problemi matematici o generare codice.

- Modalità leggera: Consuma meno energia per compiti semplici e conversazioni base, come rispondere a domande dirette o fornire informazioni generali.

- Approccio tradizionale: I modelli precedenti elaboravano il testo parola per parola in sequenza, come un bambino che impara a sillabare.

- Approccio LCM: Comprende il significato globale e astratto dietro le parole, lavorando con rappresentazioni concettuali invece che con singoli token.

Titan implementa una memoria simile a quella umana che gli permette di ricordare informazioni importanti durante una conversazione prolungata:

- Ricorda dettagli menzionati molto prima nella conversazione (come il nome del tuo cane o preferenze personali)

- Mantiene il contesto anche in dialoghi molto lunghi

- Costruisce un modello mentale dell’utente e delle sue esigenze nel tempo

Transformer-squared si adatta in tempo reale alle esigenze dell’utente:

- Modifica immediatamente lo stile di scrittura, il tono o il comportamento in base alle richieste

- Non richiede riprogrammazione o fine-tuning per cambiare approccio

- Apprende dinamicamente dalle preferenze dell’utente durante l’interazione

DeepSeek rivoluziona il processo di addestramento dei modelli linguistici:

- Si allena solo su informazioni selezionate e di alta qualità

- Evita di “sprecare tempo” su dati irrilevanti o di bassa qualità

- Riduce drasticamente i costi e i tempi di addestramento (fino al 60%)

Mistral combina due innovazioni chiave:

- Sliding Window: Legge il testo “a pezzi” come una finestra scorrevole, riducendo il carico di memoria

- Mixture of Experts (MoE): Utilizza “esperti” specializzati per diversi tipi di compiti invece di un unico modello generalista

| Modello | Innovazione | Vantaggi principali |

|---|---|---|

| Claude 3.7 | Modalità “bifase” | Risparmio energetico e velocità senza sacrificare la qualità |

| LCM (Meta) | Ragionamento per concetti | Maggiore flessibilità e comprensione del contesto |

| Titan (Google) | Memoria a lungo termine | Conversazioni più coerenti e personalizzate nel tempo |

| Transformer-squared | Adattamento in tempo reale | Personalizzazione immediata dello stile e del comportamento |

| DeepSeek | Addestramento efficiente | Riduzione costi e democratizzazione della tecnologia |

| Mistral | Sliding Window e MoE | Funzionamento su hardware comune con alte prestazioni |

- Efficienti: Funzionanti su dispositivi comuni con minor consumo energetico

- Empatici: Capaci di ricordare preferenze e dettagli personali

- Creativi: In grado di generare contenuti originali e personalizzati

- Accessibili: Utilizzabili da piccole aziende e privati senza infrastrutture costose

Da informatico a cercatore di senso