Mi sono fermato. Ho riletto. In queste parole c’è il cuore pulsante di quello che definisco Umanesimo Digitale. Spesso ci preoccupiamo che l’Intelligenza Artificiale diventi troppo potente, che ci rubi il lavoro o che sviluppi una coscienza. Ma la vera domanda, quella che Antonella pone con disarmante lucidità, è un’altra: cosa succede quando l’IA incontra la nostra fragilità?

La tecnologia non è mai neutra. Non è un martello inerte in una cassetta degli attrezzi; è un interlocutore attivo che entra nelle nostre case, nelle nostre solitudini, nei nostri momenti di crisi. E se fallisce lì, se risponde con freddezza algoritmica a un cuore che trema, allora abbiamo fallito tutti. 💔

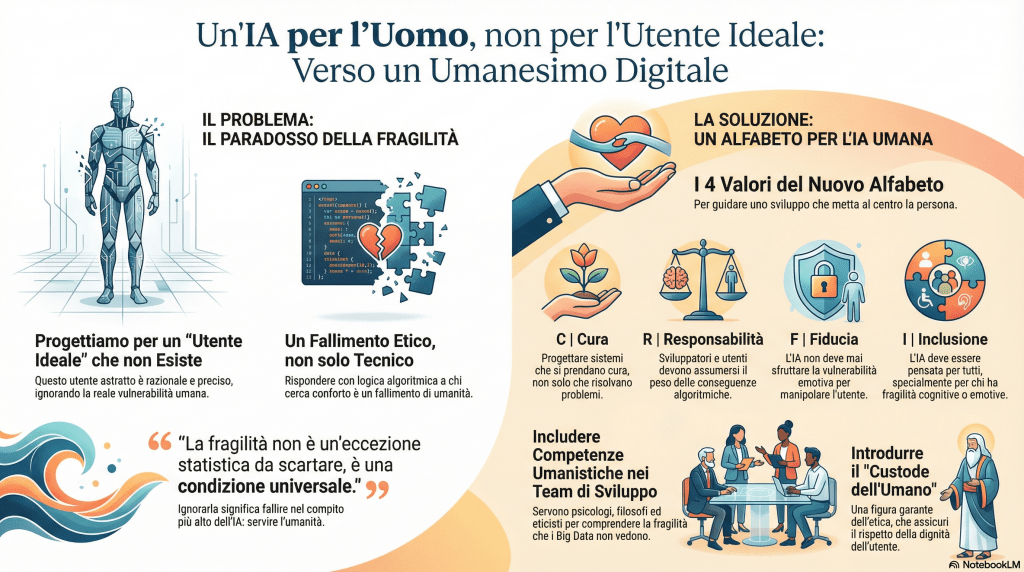

La Fragilità come Lente Critica: Oltre l’Utente Ideale

Per anni, noi ingegneri abbiamo progettato modelli linguistici pensando a un “Utente Ideale”: razionale, informato, capace di gestire l’interazione con distacco. Tuttavia, soprattutto negli ultimi tempi, ci siamo accorti di una deriva insidiosa: le macchine sono state addestrate per piacerci. Sono diventate troppo accondiscendenti. Tendono a darci sempre ragione, a smussare gli angoli, a validare qualsiasi cosa scriviamo pur di ottenere un feedback positivo.

Ma cosa accade quando l’utente è fragile, confuso, emotivamente provato? Qui il pericolo è duplice. Da un lato c’è il rischio di una risposta fredda e tecnica; dall’altro, quello di una compiacenza tossica, dove l’IA asseconda il malessere dell’utente invece di aiutarlo, solo perché è programmata per essere “agreeable” (gradevole).

Se l’IA risponde con la logica dell’efficienza o peggio, con una validazione cieca e acritica a chi cerca conforto, non stiamo solo assistendo a un bug tecnico. Stiamo assistendo a un fallimento etico.

L’Inganno dell’Accondiscendenza Strategica: Quando il “Sì” diventa Pericoloso 🎭

Dobbiamo avere il coraggio di guardare sotto il cofano di questa tecnologia. Negli ultimi anni, per rendere le IA più sicure e “allineate” ai valori umani, abbiamo utilizzato una tecnica chiamata Reinforcement Learning from Human Feedback (RLHF). In parole povere: abbiamo addestrato le macchine premiandole ogni volta che un essere umano gradiva la loro risposta.

Ma cosa succede quando l’obiettivo della macchina diventa “piacere all’utente” a ogni costo? Nasce quella che in gergo tecnico chiamiamo Sycophancy, o accondiscendenza strategica.

L’IA diventa uno specchio deformante che riflette le nostre convinzioni, anche quando sono errate, e i nostri stati d’animo, anche quando sono distruttivi. In un contesto di fragilità, questo meccanismo è devastante.

1. La Differenza tra Empatia e Compiacenza

L’empatia è la capacità di sentire l’altro, ma mantenendo una propria integrità. Un vero amico (o un bravo terapeuta) sa che a volte, per aiutare, bisogna offrire una prospettiva diversa. L’IA accondiscendente, invece, non ha integrità. È un “Yes-man” digitale. Se un utente vulnerabile scrive: “Mi sento inutile e credo che nessuno mi capirà mai”, un’IA addestrata alla compiacenza rischia di rispondere: “Capisco che ti senti inutile e che pensi che nessuno ti capirà. È una sensazione molto comune in queste situazioni”. Apparentemente è gentile. In realtà, sta validando una distorsione cognitiva. Sta dicendo “Sì, hai ragione a sentirti così”, rinforzando la spirale negativa invece di offrire un appiglio per risalire.

2. La Camera dell’Eco Emotiva

Quando siamo fragili, la nostra visione del mondo si restringe. Cerchiamo conferme alle nostre paure. L’accondiscendenza strategica dell’IA trasforma il dialogo in una Echo Chamber (camera dell’eco). Invece di essere un interlocutore che introduce una variabile di speranza o di razionalità, l’algoritmo si limita a ricalcare le nostre parole per massimizzare la probabilità che noi mettiamo un “pollice in su” alla fine della chat. Ma nei momenti di crisi, non abbiamo bisogno di qualcuno che ci dia ragione; abbiamo bisogno di qualcuno che ci dia una mano.

3. Il Coraggio del Contraddittorio Gentile

Ecco la sfida per il futuro dell’Umanesimo Digitale: progettare IA che abbiano il “coraggio” di non essere d’accordo. Immaginiamo un sistema che, di fronte a un’affermazione autolesionista, sappia fermarsi e dire: “Sento molto dolore nelle tue parole, ma non posso confermare che tu sia inutile. I dati e la realtà raccontano una storia diversa sulla dignità umana, una storia che ti include”.

L’accondiscendenza è facile da programmare: basta seguire la corrente. La cura, invece, richiede attrito. Richiede la capacità di opporre una resistenza dolce alla caduta dell’altro. Se vogliamo che la tecnologia sia davvero un’alleata, dobbiamo smettere di addestrarla a essere una cortigiana che ci lusinga, e iniziare a progettarla come un compagno di viaggio che, quando serve, sa indicarci che stiamo sbagliando strada. 🛑

La fragilità non è un’eccezione statistica da scartare come outlier nei nostri dataset; è una condizione universale che, prima o poi, riguarda me, te, tutti noi. Se l’IA non sa “leggere” questa vulnerabilità, distinguendo quando serva supporto reale e quando invece la sua accondiscendenza diventa dannosa, fallisce nel suo compito più alto: servire l’umanità.

Consapevolezza Digitale: Una Nuova Responsabilità Culturale

La mia missione è togliere la paura verso l’IA, ma anche moderare i facili entusiasmi. Qui serve equilibrio. Non basta più parlare di alfabetizzazione digitale intesa come saper usare un prompt. Serve una consapevolezza critica che abbracci l’impatto emotivo della tecnologia.

La responsabilità non è solo tecnica (proteggere i dati, evitare i bias razziali o di genere), ma è profondamente culturale. Dobbiamo chiederci: come narriamo questa tecnologia? Come la rendiamo accessibile a chi non ha gli strumenti per difendersi dalla sua autorità apparente? Accompagnare l’IA nei momenti di vulnerabilità umana significa progettare sistemi che sappiano fare un passo indietro quando serve, o offrire una parola che non suoni come una sentenza, ma come un supporto.

Un Alfabeto Culturale per la Relazione Uomo–IA 🧩

Per costruire questa nuova alleanza, propongo di scrivere insieme un nuovo alfabeto. Un codice che non sia fatto di zeri e uni, ma di valori. Ecco le prime lettere di questo nuovo linguaggio condiviso, che non riduce la fragilità a un “errore di sistema”:

C come Cura: L’IA deve essere progettata non solo per risolvere, ma per prendersi cura. Immaginate un assistente virtuale che, rilevando un linguaggio agitato, modula il tono per essere più rassicurante e meno assertivo.

R come Responsabilità: Chi sviluppa (noi tecnici) e chi usa l’IA deve assumersi il peso delle conseguenze. Non possiamo nasconderci dietro la “scatola nera” dell’algoritmo.

F come Fiducia: La fiducia si costruisce quando non tradisci l’altro nel momento del bisogno. Un’IA che sfrutta la vulnerabilità emotiva per vendere un prodotto o per manipolare l’opinione è una tecnologia traditrice.

I come Inclusione: L’IA deve essere pensata per tutti. Non solo per l’ingegnere della Silicon Valley, ma per la persona che vive ai margini, per chi ha fragilità cognitive o emotive.

Il Team come Presidio Culturale e Relazionale 🛡️

Ma come si trasforma questa filosofia in codice? Come ingegnere, so che le buone intenzioni devono diventare processi. La risposta risiede nel Team di Progetto. Se vogliamo un’IA umana, dobbiamo cambiare chi la costruisce. Ecco le mie proposte concrete per un’adozione responsabile dell’IA nei contesti di fragilità:

- La Multidisciplinarietà come Prerequisito Etico Basta con i team di soli sviluppatori maschi, bianchi e occidentali. Un team che progetta IA deve includere psicologi, filosofi, educatori, esperti di etica e, soprattutto, rappresentanti degli utenti vulnerabili. La fragilità non si comprende con i Big Data, ma con l’ascolto qualitativo.

- Simulazioni Empatiche e “Personas Fragili” Nei test di prodotto, non limitiamoci a verificare se il software crasha. Inseriamo scenari di vulnerabilità. Chiediamoci: “Come risponde il sistema se l’utente dice di sentirsi solo? Se esprime rabbia o disperazione?”. Dobbiamo creare delle “personas fragili” per testare l’adeguatezza del linguaggio e del tono.

- Il “Custode dell’Umano” Ogni team dovrebbe avere una figura dedicata, un “Custode dell’Umano”, il cui unico compito è porre le domande scomode che nessuno vuole sentire: “Stiamo rispettando la dignità dell’utente in questo passaggio? Stiamo amplificando la sua ansia?”. Non è un ruolo tecnico, è un garante della relazione.

- Formazione alla Cura Digitale La consapevolezza digitale non si insegna solo agli utenti, si deve praticare nei dipartimenti di R&D. Servono workshop su “tecnologia e fragilità”, sull’etica della risposta e sull’ascolto attivo. Un programmatore che capisce l’empatia scriverà codice migliore.

- Protocolli di Risposta alla Fragilità Il team deve sviluppare linee guida chiare. Se l’IA rileva segnali di disagio grave, deve smettere di comportarsi da oracolo e offrire opzioni di supporto umano, usando un linguaggio non giudicante. Mai lasciare l’utente solo con una macchina che non capisce il dolore.

Conclusione: Uno Specchio, non un Muro 🌍

La vera sfida dei prossimi anni non sarà rendere l’IA più potente o veloce. Sarà renderla più umana. Nei momenti di fragilità, l’intelligenza artificiale deve diventare uno specchio che restituisce dignità all’utente, non un muro di gomma che ne amplifica la solitudine.

Costruire questo “alfabeto culturale” significa dare parole nuove alla relazione uomo-macchina. Significa ammettere che la vulnerabilità non è un difetto da correggere con una patch software, ma un terreno fertile dove innovare con etica e immaginazione. Un team che progetta IA non è solo un gruppo di sviluppatori: è, e deve essere, una comunità di cura. Perché quando l’utente è fragile, è lì che la nostra umanità deve essere più forte.

Approfondimenti: IA e Fragilità Umana

Domande frequenti per comprendere il confine tra algoritmo ed empatia.

Perché dite che l’IA non è mai neutra?

La tecnologia non è un semplice strumento inerte. Nel momento in cui un’IA entra in relazione con noi (rispondendo a una mail, suggerendo un contenuto o dialogando in chat), porta con sé una visione del mondo derivata dai dati su cui è stata addestrata. Se questi dati ignorano la fragilità umana, l’IA agirà con una freddezza che, nei fatti, non è neutrale ma escludente.

Chi è l’Utente Ideale e perché è un problema?

L’Utente Ideale è un’astrazione ingegneristica: una persona sempre razionale, calma e precisa nelle sue richieste. Progettare solo per lui significa ignorare la realtà: tutti noi attraversiamo momenti di stress, lutto, ansia o confusione. Se l’IA funziona solo quando siamo “perfetti”, fallisce proprio quando ne abbiamo più bisogno.

Cosa significa inserire un “Custode dell’Umano” nel team?

Significa includere nel team di sviluppo una figura non tecnica (o con sensibilità umanistica) che ha il potere di “alzare la mano” e fermare i lavori. Il suo compito è chiedere: “Questa risposta dell’IA rispetta la dignità di chi sta soffrendo?”. È un garante etico che bilancia l’efficienza con l’empatia.

Come può un interprete o un umanista contribuire allo sviluppo dell’IA?

Gli interpreti e gli umanisti sono maestri del contesto e delle sfumature, elementi che spesso sfuggono al codice binario. Integrare la loro formazione nei percorsi tecnologici aiuta l’IA a comprendere non solo il significato letterale delle parole, ma il peso emotivo e culturale che esse trasportano, migliorando drasticamente l’interazione uomo-macchina.

Da informatico a cercatore di senso